简介

笔名:数据人阿多

小编拥有超过十余年的数据领域工作经验,技术路径从最初的 Excel 数据处理开始,逐步走向基于分布式集群的 Hive 数据开发与分析

- 接触的技术范畴也在不断扩展

早期从 Excel 中的统计与数据分析起步,随后逐渐深入机器学习领域,实践过决策树、聚类分析等经典算法,并进一步涉足自然语言处理(NLP)与计算机视觉(CV),尝试将多种智能技术应用于实际业务问题

- 工具与编程语言层面也持续演进

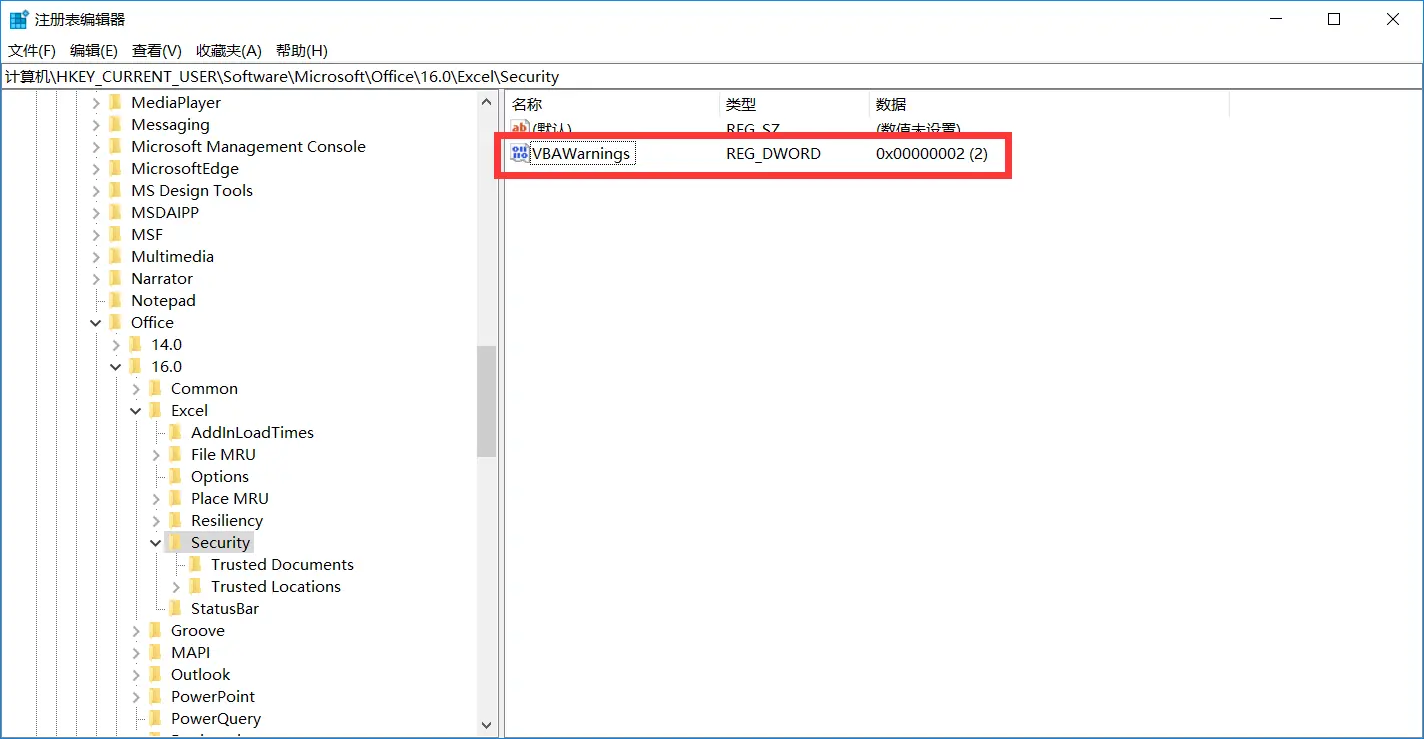

从借助 Excel VBA 实现办公自动化,到系统学习并运用 Python、Hive、Tableau 等专业工具,逐渐成长为一名兼具数据分析与数据开发能力的技术实践者

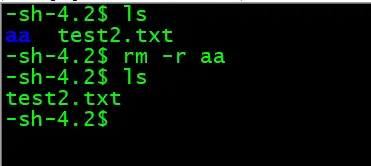

- 使用的操作系统环境也从 Windows 逐步拓展至 Linux

从最初的学习基本命令与系统操作,到能够在 Linux 环境中部署和维护自己的轻量级服务

一路走来,虽然工具在迭代、技术在演进,但是不变的是围绕数据价值的持续探索与务实构建

其他平台

- 微信公众号:DataShare

- QQ群:581146525

作者:数据人阿多

背景

NumPy(Numerical Python)诞生已经过去了 15 年,前一段时间NumPy 核心开发团队的论文终于发表,详细介绍了使用 NumPy 的数组编程(Array programming),并且登上了Nature 。

NumPy 是什么?它是大名鼎鼎的使用 Python 进行科学计算的基础软件包,是 Python 生态系统中数据分析、机器学习、科学计算的主力军,极大简化了向量与矩阵的操作处理。

- 功能强大的 N 维数组对象

- 精密广播功能函数

- 集成 C/C++ 和 Fortran 代码的工具

- 强大的线性代数、傅立叶变换和随机数功能

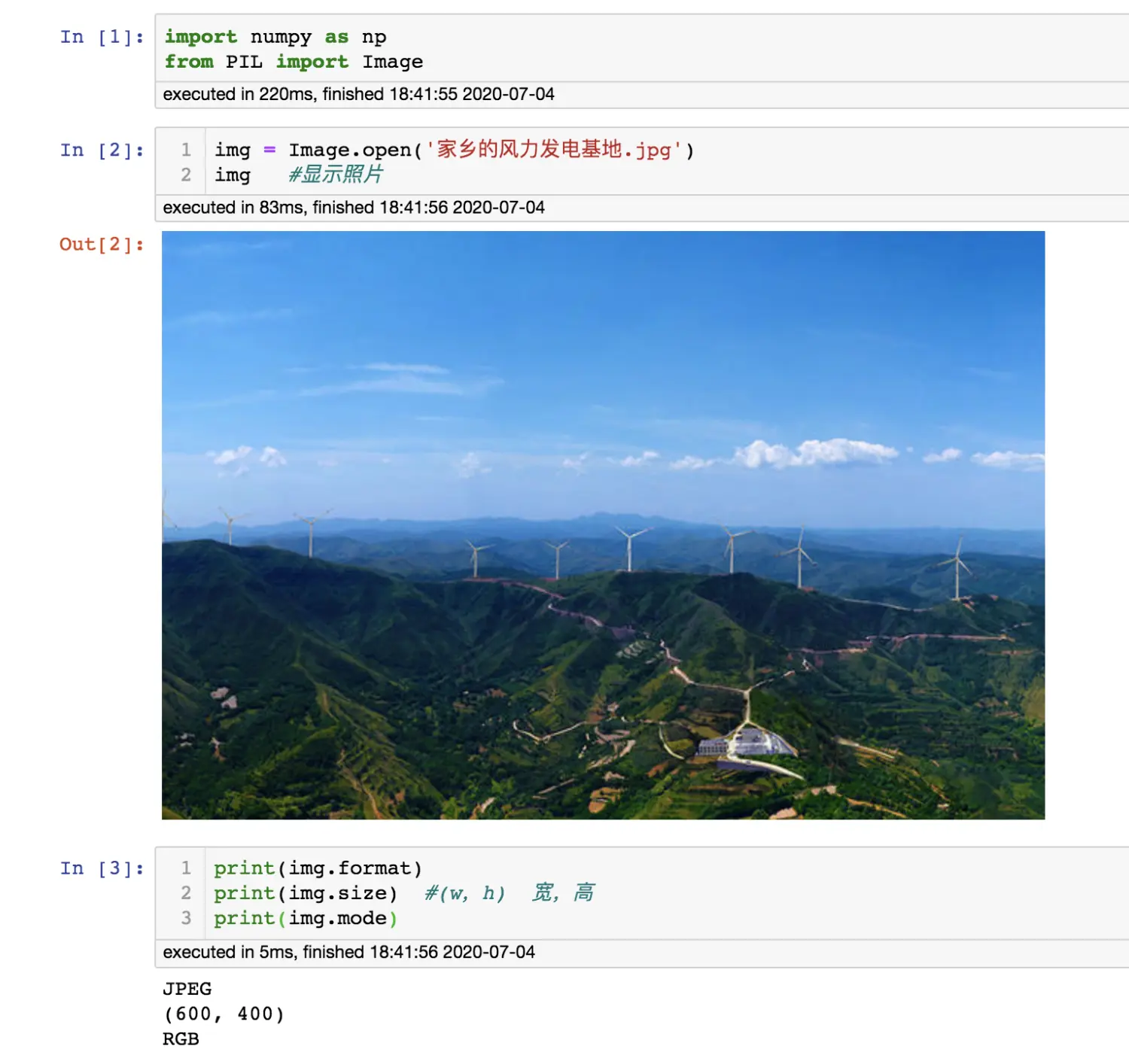

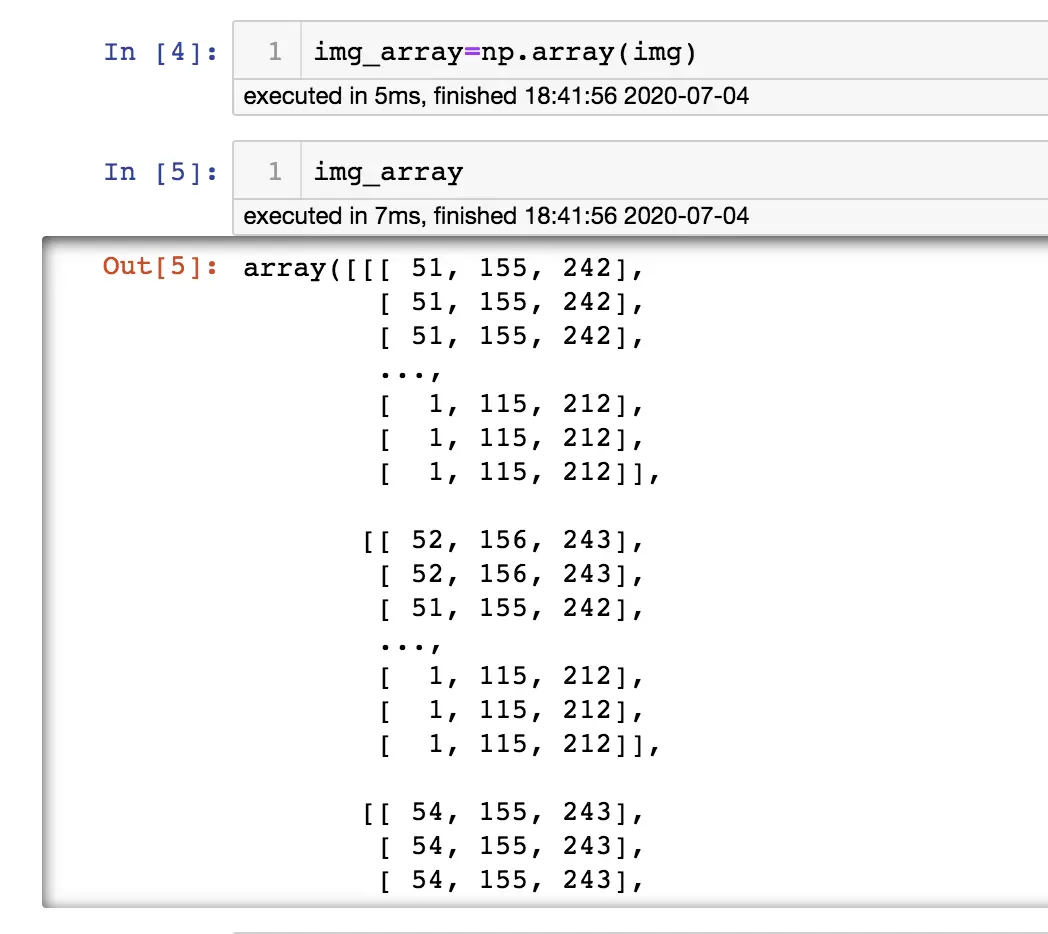

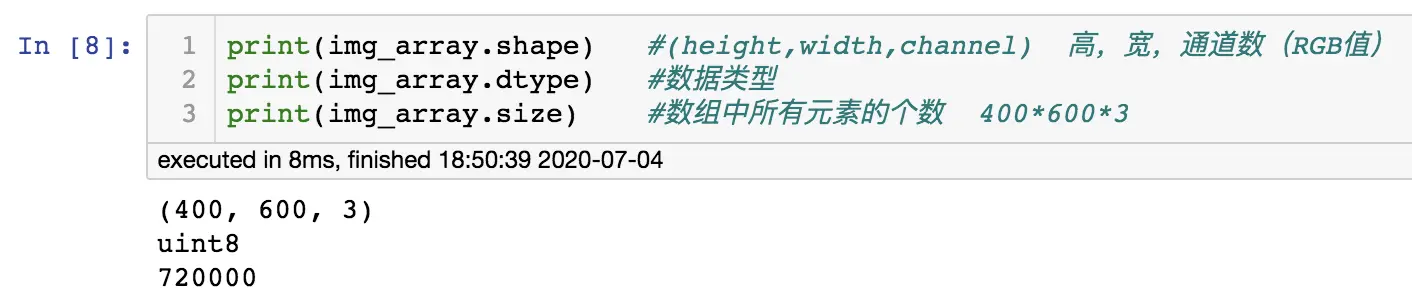

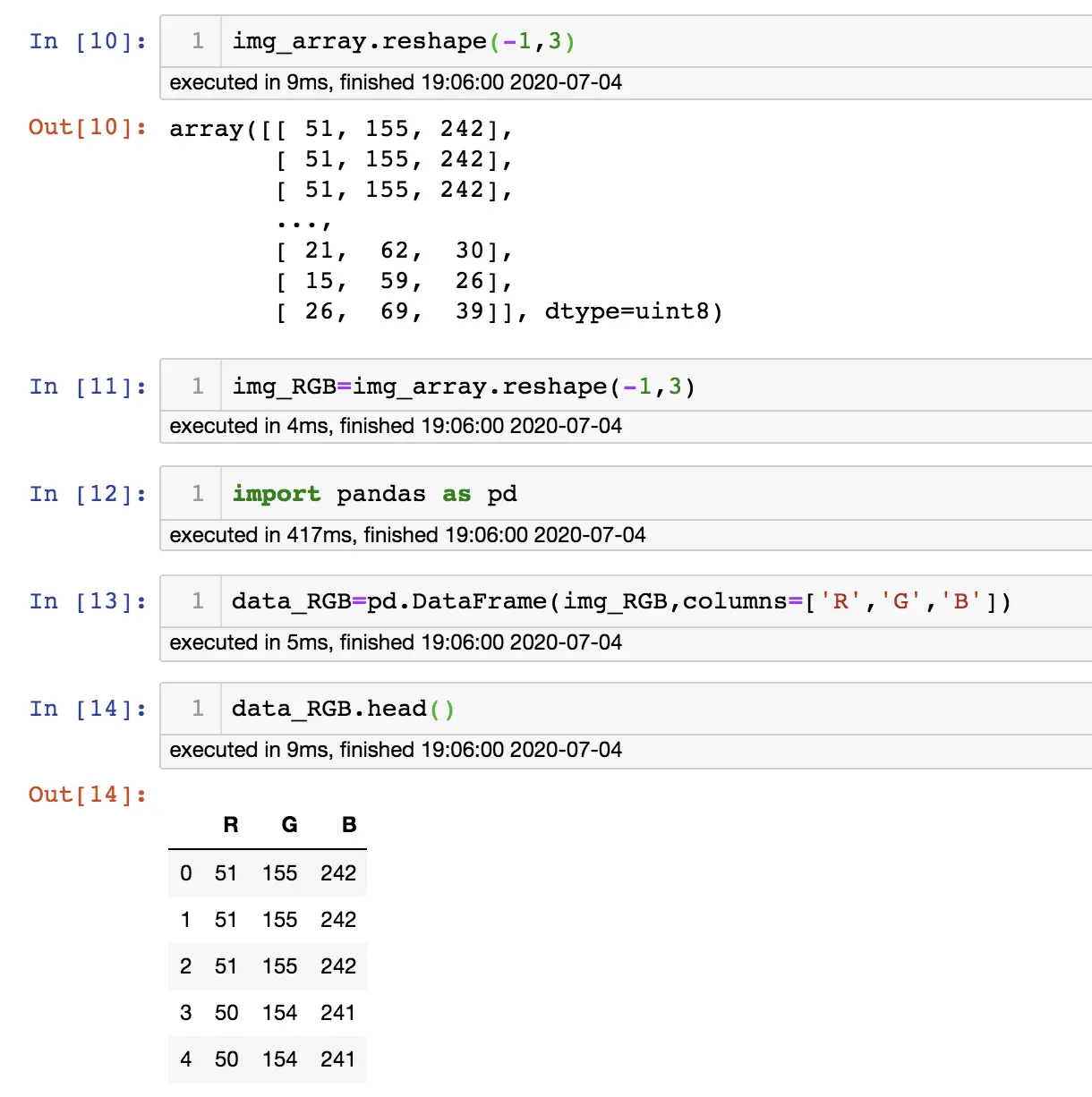

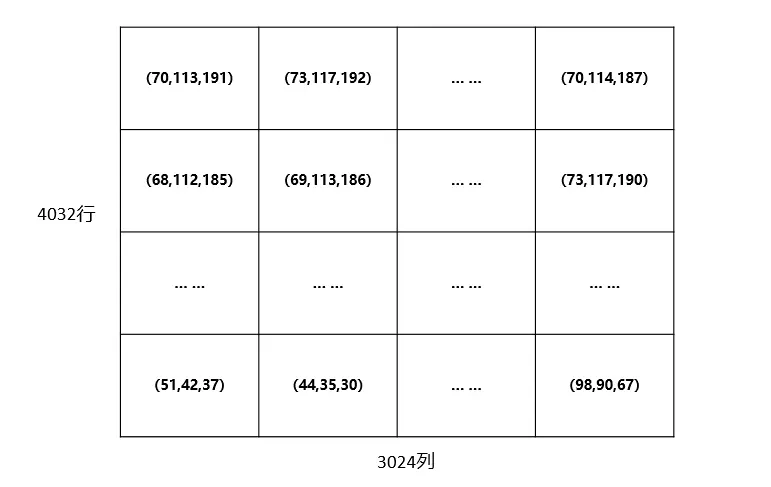

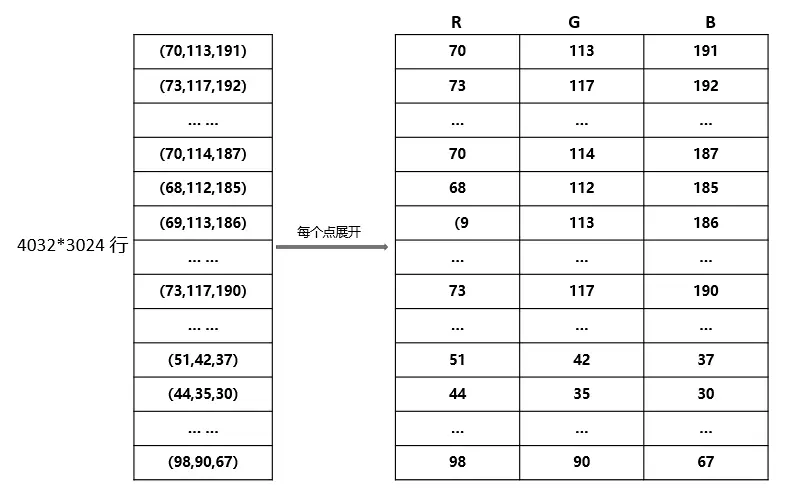

在平时数据处理中,大部分人用的都是Pandas,用Numpy的场景可能比较少,但是Pandas是基于Numpy实现的更高级的库,使大家用起来更方便。但在做深度学习时用Numpy比较多,比如:图像处理,图片里面其实都是Numpy数组;音频处理;文本处理等等。

下面为大家介绍一些Numpy的常用基础

Numpy基础

- 安装

由于Numpy是第三方库,默认是不集成在Python里面,所以就需要手动安装一下: 如果你安装的是Anaconda,那么就不用再安装了,请忽略 如果你是从官方网站下载的Python,那么你就需要手动安装一下这个库

#指定阿里云镜像,安装更快

pip install numpy -i https://mirrors.aliyun.com/pypi/simple/

- 导入

默认成规,numpy导入后命名为np,所以在python脚本(程序)里面看见np一般都是代表numpy

import numpy as np

- 认识Ndarray

计算机里面能计算的就是数字,也就是数学里面的各种数字,我们都知道数学里面的数组可以有多层,也就是多维,1维就是向量,2维就是矩阵,3维就是$x y z$坐标轴构成的空间(形象理解),但体现在numpy中就是N 维数组对象ndarray,它是一系列同类型数据的集合。

1维:

>>> import numpy as np

>>> a=np.array([1,2,3,4])

>>> print(a)

[1 2 3 4]

>>> type(a)

<class 'numpy.ndarray'>

>>> a.ndim

1

2维:

>>> import numpy as np

>>> b=np.array([[1,2,3],[4,5,6]])

>>> print(b)

[[1 2 3]

[4 5 6]]

>>> type(b)

<class 'numpy.ndarray'>

>>> b.ndim

2

- 切片和索引

切片、索引与python内置的列表、字符串的切片和索引基本一样,如果理解了列表的切片和索引,那么ndarray对象就不在话下

>>> import numpy as np

>>> a=np.arange(10)

>>> print(a)

[0 1 2 3 4 5 6 7 8 9]

>>> type(a)

<class 'numpy.ndarray'>

>>> a.ndim

1

>>> a[:5]

array([0, 1, 2, 3, 4])

>>> a[7:]

array([7, 8, 9])

>>> a[3:6]

array([3, 4, 5])

>>> a[::2]

array([0, 2, 4, 6, 8])

>>> a[::-1]

array([9, 8, 7, 6, 5, 4, 3, 2, 1, 0])

>>> a[0]

0

>>> a[5]

5

- 数组操作

修改数组形状

>>> import numpy as np

>>> a=np.arange(10)

>>> print(a)

[0 1 2 3 4 5 6 7 8 9]

>>> type(a)

<class 'numpy.ndarray'>

>>> a.ndim

1

>>> b=a.reshape(5,2)

>>> print(b)

[[0 1]

[2 3]

[4 5]

[6 7]

[8 9]]

>>> b.ndim

2

>>> c=a.reshape(2,5)

>>> print(c)

[[0 1 2 3 4]

[5 6 7 8 9]]

>>> c.ndim

2

数组转置

>>> import numpy as np

>>> a=np.arange(12).reshape(3,4)

>>> print(a)

[[ 0 1 2 3]

[ 4 5 6 7]

[ 8 9 10 11]]

>>> np.transpose(a)

array([[ 0, 4, 8],

[ 1, 5, 9],

[ 2, 6, 10],

[ 3, 7, 11]])

>>> a.T

array([[ 0, 4, 8],

[ 1, 5, 9],

[ 2, 6, 10],

[ 3, 7, 11]])

数组连接

concatenate、stack、hstack、vstack这个几个函数均是数组连接,原理基本都一样,只要理解了其中一个,其他的都很好理解,这里只介绍concatenate

>>> import numpy as np

>>> a=np.array([[1,2],[3,4]]

... )

>>> b=np.array([[5,6],[7,8]])

>>> np.con

np.concatenate( np.conj( np.conjugate( np.convolve(

>>> np.concatenate([a,b],axis=0) #沿着0轴拼接

array([[1, 2],

[3, 4],

[5, 6],

[7, 8]])

>>> np.concatenate([a,b],axis=1) #沿着1轴拼接

array([[1, 2, 5, 6],

[3, 4, 7, 8]])

修改数组维度

>>> import numpy as np

>>> x=np.array([1,2])

>>> np.expand_dims(x,axis=0)

array([[1, 2]])

>>> np.expand_dims(x,axis=1)

array([[1],

[2]])

>>> y=np.array([[1,2]])

>>> np.squeeze(y) #从给定数组的形状中删除一维,当前维必须等于1

array([1, 2])

- 数组计算

>>> import numpy as np

>>> a1=np.array([1,2,3,4])

>>> a2=np.array([5,5,5,5])

>>> a1+a2

array([6, 7, 8, 9])

>>> np.add(a1,a2)

array([6, 7, 8, 9])

>>> a1-a2

array([-4, -3, -2, -1])

>>> np.subtract(a1,a2)

array([-4, -3, -2, -1])

>>> a1*a2

array([ 5, 10, 15, 20])

>>> np.multiply(a1,a2)

array([ 5, 10, 15, 20])

>>> a1/a2

array([0.2, 0.4, 0.6, 0.8])

>>> np.divide(a1,a2)

array([0.2, 0.4, 0.6, 0.8])

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号DataShare,不定期分享干货

作者:数据人阿多

背景

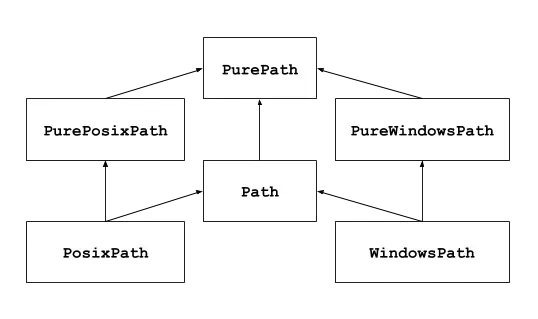

pathlib 标准库是在 Python3.4 引入,到现在最近版 3.11 已更新了好几个版本,主要是用于路径操作,相比之前的路径操作方法 os.path 有一些优势,有兴趣的同学可以学习下

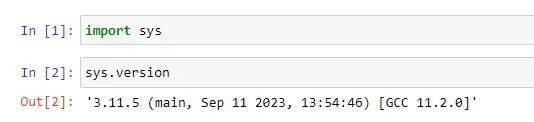

小编环境

import sys

print('python 版本:',sys.version.split('|')[0]) #python 版本: 3.11.4

主要方法、函数

该模块中主要使用的是 Path 类

from pathlib import Path

Path.cwd() #WindowsPath('D:/桌面/Python/标准库')

Path.home() #WindowsPath('C:/Users/admin')

file = Path('pathlib_demo1.py')

print(file) #WindowsPath('pathlib_demo1.py')

file.resolve() #WindowsPath('D:/桌面/Python/标准库/pathlib_demo1.py')

file = Path('pathlib_demo1.py')

print(file) #WindowsPath('pathlib_demo1.py')

file.stat()

'''

os.stat_result(st_mode=33206, st_ino=1970324837176895, st_dev=2522074357,

st_nlink=1, st_uid=0, st_gid=0, st_size=273,

st_atime=1695642854, st_mtime=1695611301, st_ctime=1695611241)

'''

#文件大小

file.stat().st_size #273B

#最近访问时间 access ,It represents the time of most recent access

file.stat().st_atime #1695625134.9083948

#创建时间 create,It represents the time of most recent metadata change on Unix and creation time on Windows.

file.stat().st_ctime #1695611241.5981772

#修改时间 modify,It represents the time of most recent content modification

file.stat().st_mtime #1695611301.1193473

for f in path.iterdir():

print(f)

print('is_file:',f.is_file()) #判断是否为文件

print('is_dir:',f.is_dir()) #判断是否为文件夹

print('='*30)

'''

D:\桌面\Python\标准库\.ipynb_checkpoints

is_file: False

is_dir: True

==============================

D:\桌面\Python\标准库\pathlib.ipynb

is_file: True

is_dir: False

==============================

D:\桌面\Python\标准库\pathlib_demo1.py

is_file: True

is_dir: False

==============================

'''

file=Path('D:\桌面\Python\标准库\pathlib_demo1.py')

file.name #'pathlib_demo1.py'

file.stem #'pathlib_demo1'

file.suffix #'.py'

file.parent #WindowsPath('D:/桌面/Python/标准库')

file.anchor #'D:\\'

file.parent.parent #WindowsPath('D:/桌面/Python')

#获取所有的父级路径,层层递进

list(file.parents)

'''

[WindowsPath('D:/桌面/Python/标准库'),

WindowsPath('D:/桌面/Python'),

WindowsPath('D:/桌面'),

WindowsPath('D:/')]

'''

支持2种方式

#第1种方式:使用 /

Path.home() / 'dir' / 'file.txt' #WindowsPath('C:/Users/admin/dir/file.txt')

#第2种方式:使用方法

Path.home().joinpath('dir', 'file.txt') #WindowsPath('C:/Users/admin/dir/file.txt')

#当前文件件里面是否存在 子目录 archive/demo.txt 文件

Path("archive/demo.txt").exists() #False

#当前文件件里面是否存在 二级子目录 dir/subdir

Path('dir/subdir').exists() #True

#当前文件件里面是否存在 pathlib_demo1.py 文件

Path("pathlib_demo1.py").exists() #True

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

注:本文章由ChatGPT gpt-3.5-turbo 生成,小编进行略微调整 提出的问题:heapq详细讲解

背景

最近小编在读《Python Cookbook》书籍时,遇到一个新的标准库heapq,该库主要涉及堆数据结构,自己之前没有用过,所以就问了一下 ChatGPT,给出的内容非常详细且容易理解,分享出来供大家参考

heapq介绍

heapq 是 Python 标准库中的一个基于堆的优先队列实现。它提供了一些函数来实现对列表中的元素进行加入、弹出、替换等操作,同时也支持对列表中的元素进行建堆、堆排序等高级功能。本文将详细介绍 heapq 的使用方法和内部实现原理。

基本用法

1、heapq.heappush 和 heapq.heappop

heapq.heappush(lst, item):将元素 item 加入到列表 lst 中,并保持 lst 始终为一个堆。

heapq.heappop(lst):从列表 lst 中弹出最小的元素,并保持 lst 始终为一个堆。

下面是一个示例:

import heapq

lst = [10, 30, 2, 20, 50] # 初始列表

heapq.heapify(lst) # 建堆

print(lst) # 输出 [2, 20, 10, 30, 50]

heapq.heappush(lst, 5) # 将 5 加入到 lst 中

print(lst) # 输出 [2, 5, 10, 30, 50, 20]

min_item = heapq.heappop(lst) # 弹出最小元素

print(min_item, lst) # 输出 2 [5, 20, 10, 30, 50]

2、heapq.heapreplace

heapq.heapreplace(lst, item):将最小元素替换为 item,并保持 lst 始终为一个堆。

这个函数相当于先执行 heapq.heappop(lst),再执行 heapq.heappush(lst, item)。使用该函数可以避免在先弹出再加入元素时,列表中出现不合法的状态。例如:

import heapq

lst = [10, 30, 2, 20, 50] # 初始列表

heapq.heapify(lst) # 建堆

print(lst) # 输出 [2, 20, 10, 30, 50]

heapq.heapreplace(lst, 5) # 用 5 替换最小元素 2

print(lst) # 输出 [5, 20, 10, 30, 50]

3、heapq.nlargest 和 heapq.nsmallest

heapq.nlargest(n, lst):返回列表 lst 中前 n 个最大的元素,按照从大到小的顺序排序。

heapq.nsmallest(n, lst):返回列表 lst 中前 n 个最小的元素,按照从小到大的顺序排序。

这两个函数的实现都是先使用 heapq.heappush 和 heapq.heappop 对列表进行处理,之后返回前 n 个元素。示例:

import heapq

lst = [10, 30, 2, 20, 50] # 初始列表

heapq.heapify(lst) # 建堆

print(lst) # 输出 [2, 20, 10, 30, 50]

print(heapq.nlargest(3, lst)) # 输出 [50, 30, 20]

print(heapq.nsmallest(3, lst)) # 输出 [2, 10, 20]

内部实现原理

Heap 是一种树形数据结构,通常用二叉树来实现。堆树的最上面是根节点,根节点下面的每个节点都比它自己所有的子节点都大(称为大根堆)或者都小(称为小根堆)。根据这个性质,堆树可以快速地找到最大或者最小元素。

Python 中的 heapq 模块实现是使用了一种叫做“二叉堆”的数据结构。二叉堆由固定数量的元素组成,堆的根节点包含所有能够在其中的元素中具有最小或者最大关键字的元素。我们称这个根节点为“最小堆”或者“最大堆”。堆中的每一个其他的节点都符合堆的性质:最小堆中的每一个节点都比它的子节点小;最大堆中的每一个节点都比它的子节点大。

这种数据结构可以直接用一个数组来实现,每个元素在数组中顺序存储,并按照堆的性质排列。数组的第一个元素是根节点,也就是堆的最小或最大元素。根据元素在数组中的位置,可以快速地用简单的数学运算找到它的子节点和父节点

二叉堆分为两种类型:最小堆和最大堆。在 Python 中的 heapq 模块中使用最小堆

Python 中,可以以列表的形式存储二叉堆,将列表作为二叉树,树的根节点即为第一个元素,树的子节点为列表中其左右孩子。具体来说,以第 k 个节点为例,其左孩子为第 2k+1 个节点,右孩子为第 2k+2 个节点,其父节点为第(k-1)//2 个节点

通过使用 heapq 模块提供的高效的堆算法,可以快速地实现对列表中元素的排序、寻找最大/最小值等常见操作

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

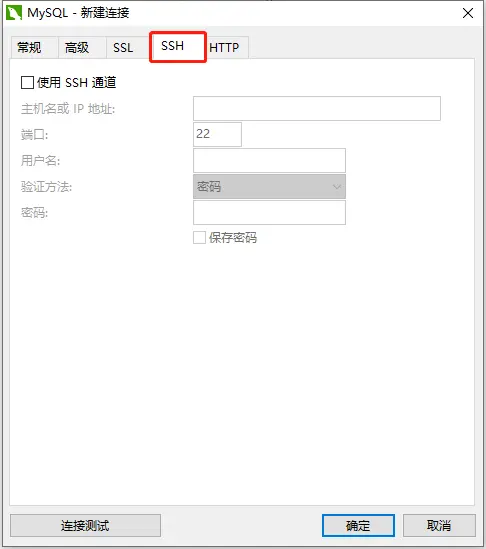

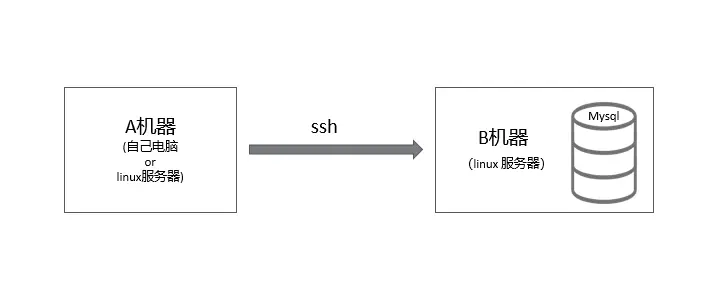

背景

如果需要访问远程服务器的Mysql数据库,但是该Mysql数据库为了安全期间,安全措施设置为只允许本地连接(也就是你需要登录到该台服务器才能使用),其他远程连接是不可以直接访问,并且相应的端口也做了修改,那么就需要基于ssh来连接该数据库。这种方式连接数据库与Navicat里面界面化基于ssh连接一样。

安装支持库

- 如果要连接Mysql,首先需要安装pymysql

pip install pymysql

- 安装基于ssh的库sshtunnel

pip install sshtunnel #当前最新 0.3.1版

建议安装最新的sshtunnel库,旧版本库有一些bug

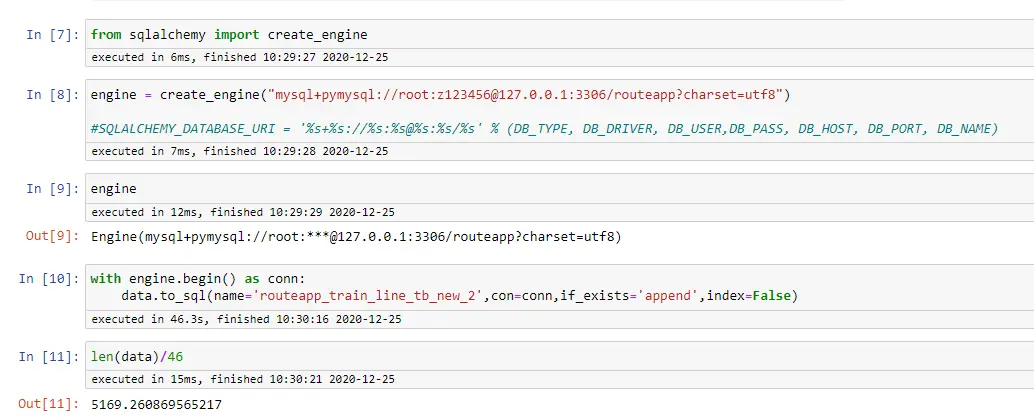

连接Mysql

基于ssh连接Mysql可以查看sshtunnel的文档,里面有一些案例

with SSHTunnelForwarder(

('192.168.1.1', 2222),

ssh_password='123456',

ssh_username='root',

remote_bind_address=('127.0.0.1', 3306)) as server:

print('SSH连接成功')

conn = pymysql.connect(host='127.0.0.1',

port=server.local_bind_port,

user='root',

database='data',

charset='utf8')

print('mysql数据库连接成功')

cursor = conn.cursor()

... #获取数据操作,此处省略

cursor.close()

conn.close()

自定义查询函数

可以对上面的连接进行封装为一个函数,方便其他地方使用

def mysql_ssh(sql,args=None):

with SSHTunnelForwarder(

('192.168.1.1', 2222),

ssh_password='123456',

ssh_username='root',

remote_bind_address=('127.0.0.1', 3306)) as server:

print('SSH连接成功')

conn = pymysql.connect(host='127.0.0.1',

port=server.local_bind_port,

user='root',

database='data',

charset='utf8')

print('mysql数据库连接成功')

cursor = conn.cursor()

print('游标获取成功')

try:

print(f'执行查询语句:{sql} 参数:{args}')

cursor.execute(sql,args)

print('数据查询成功')

conn.commit()

print('事务提交成功')

datas = cursor.fetchall()

success = True

except:

print('数据查询失败')

datas = None

success = False

print('正在关闭数据库连接')

cursor.close()

conn.close()

return datas, success

注意点:

- 在使用数据库时,

conn.commit()、cursor.close()、conn.close()这些一定要规范使用,防止不必要的bug - 传入参数时建议用这种方式

cursor.execute(sql,args),防止sql注入的风险

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注 DataShare (同微),不定期分享干货

作者:数据人阿多

前言

小编第一次了解正则,是在VBA编程时用到,当时看了很多的学习资料,来了解和学习正则。因为现在数据录入、数据存放相对都比较规范,使用正则的场景越来越少,但运用正则在杂乱的数据中提取一些有用数据还是很方便,最近阅读书籍时又看到了正则相关的内容,于是总结了一下,分享出来,供大家参考学习

官方文档:https://docs.python.org/zh-cn/3/library/re.html

Excelhome精选正则文章

正则文章:正则表达式入门与提高---VBA平台的正则学习参考资料

地址:https://club.excelhome.net/thread-1128647-1-3.html

环境与正则库版本

import sys

import re

print('python 版本:',sys.version.split('|')[0]) #python 版本: 3.11.4

print('re 正则库版本:',re.__version__) #re 正则库版本: 2.2.1

正则模块中的函数/方法

- re.compile 将正则表达式模式编译为一个正则表达式对象,方便多次使用

import re

text='Does this text match the pattern?'

regexes=re.compile('this')

print(regexes) #re.compile('this')

print(regexes.search(text)) #<re.Match object; span=(5, 9), match='this'>

- re.search

在给定的字符串中 查找/匹配 正则表达式模式,首次出现的位置,如果能匹配到,则返回相应的正则表达式对象;如果匹配不到,则返回

None

import re

pattern='this'

text='Does this text match the text pattern?'

match=re.search(pattern,text)

print(match) #<re.Match object; span=(5, 9), match='this'>

print(match.re) #re.compile('this')

print(match.re.pattern) #this

print(match.string) #Does this text match the text pattern?

print(match.start()) #5

print(match.end()) #9

- re.match

在给定的字符串开头进行匹配,如果在开头能与给定的正则表达式模式匹配,则返回相应的正则表达式对象;如果匹配不到,则返回

None

import re

text='Does this text match the text pattern?'

match1=re.match('Does',text)

print(match1) #<re.Match object; span=(0, 4), match='Does'>

print(match1.span()) #(0, 4)

match2=re.match('this',text)

print(match2) #None

- re.fullmatch

如果整个字符串需要与给定的正则表达式模式匹配,则返回相应的相应的正则表达式对象;如果匹配不到,则返回

None

import re

text='Does this text match the text pattern?'

match1=re.fullmatch('Does this text match the text pattern\?',text)

print(match1) #<re.Match object; span=(0, 38), match='Does this text match the text pattern?'>

match2=re.fullmatch('Does this text',text)

print(match2) #None

match3=re.fullmatch('Does .* pattern\?',text)

print(match3) #<re.Match object; span=(0, 38), match='Does this text match the text pattern?'>

- re.findall 对字符串与给定的正则表达式模式,从左至右进行查找,匹配结果按照找到的顺序进行返回,返回结果是以字符串列表或字符串元组列表的形式,如果匹配不到,返回空列表的形式

import re

text='Does this text match the text pattern?'

matches1=re.findall('text',text)

print(matches1) #['text', 'text']

matches2=re.findall('regexes',text)

print(matches2) #[]

- re.finditer

与

findall方法类似,结果返回的是一个迭代器,并且每个元素是匹配到的正则表达式对象

import re

text='Does this text match the text pattern?'

matches1=re.finditer('text',text)

print(matches1) #<callable_iterator object at 0x0000024D0E9018D0>

for match in matches1:

print(match)

#<re.Match object; span=(10, 14), match='text'>

#<re.Match object; span=(25, 29), match='text'>

matches2=re.findall('regexes',text)

print(matches2) #[]

本篇文章只介绍了几个常用的方法,重点是方法的含义,而没有介绍元字符相关的内容,如果对正则表达式感兴趣,可以深入学习拓展知识范围

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

介绍

bisect模块提供了一种只针对 已排序的序列 的方法,快速找到插入元素的位置,这个模块使用二分查找算法,算法的时间复杂度相对更低一些,可以用于程序优化提升性能

官方文档:https://docs.python.org/3/library/bisect.html#module-bisect

函数分为 bisect、insort 两大块

各函数详解

- bisect、bisect_right

这两个函数功能一模一样,

bisect是对bisect_right的引用,用于查找元素在已经排序的序列中应该插入的位置,返回值为最靠右 or 最大的索引位置

l = [1, 23, 45, 12, 23, 42, 54, 123, 14, 52, 3]

l.sort()

print(l) #[1, 3, 12, 14, 23, 23, 42, 45, 52, 54, 123]

print(bisect.bisect(l, 3)) #2

- bisect_left 返回值为最靠左 or 最小的索引

l = [1, 23, 45, 12, 23, 42, 54, 123, 14, 52, 3]

l.sort()

print(l) #[1, 3, 12, 14, 23, 23, 42, 45, 52, 54, 123]

print(bisect.bisect_left(l, 3)) #1

- insort、insort_right

这两个函数功能一模一样,

insort是对insort_right的引用,用于将一个元素插入到已经排序的序列中,并且保持序列的排序状态,插入位置为最靠右 or 最大的索引位置

l = [1, 23, 45, 12, 23, 42, 54, 123, 14, 52, 3]

l.sort()

print(l) #[1, 3, 12, 14, 23, 23, 42, 45, 52, 54, 123]

bisect.insort(l, 3.0)

print(l) #[1, 3, 3.0, 12, 14, 23, 23, 42, 45, 52, 54, 123]

- insort_left 插入位置为最靠左 or 最小的索引位置

li = [1, 23, 45, 12, 23, 42, 54, 123, 14, 52, 3]

li.sort()

print(li) #[1, 3, 12, 14, 23, 23, 42, 45, 52, 54, 123]

bisect.insort_left(li, 3.0)

print(li) #[1, 3.0, 3, 12, 14, 23, 23, 42, 45, 52, 54, 123]

官方文档案例

def grade(score, breakpoints=[60, 70, 80, 90], grades='FDCBA'):

i = bisect.bisect(breakpoints, score)

return grades[i]

[grade(score) for score in [33, 99, 77, 70, 89, 90, 100]]

#['F', 'A', 'C', 'C', 'B', 'A', 'A']

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

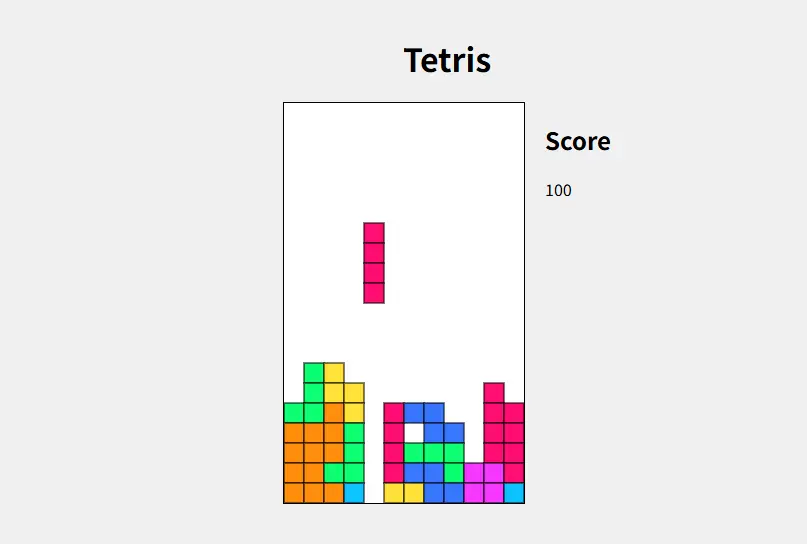

背景

最近在看《Python - 100天从新手到大师》时,运行了一下代码,感觉挺有意思。一个简单的小游戏,包含了pyhon的很多知识,分享出来,供大家参考学习

小编对扑克牌的排序进行了简单修改,使相同大小的牌放在一起

《Python - 100天从新手到大师》,感兴趣的同学可以去学习该教程

地址:https://github.com/jackfrued/Python-100-Days

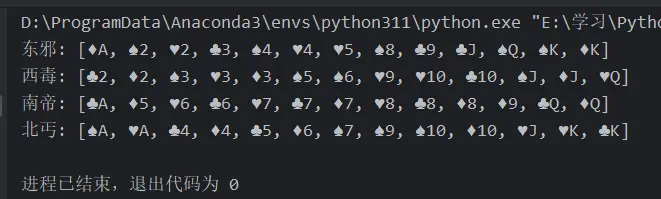

发牌结果

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.4

完整代码

"""

===========================

@Software: PyCharm

@Platform: Win10

@Author : DataShare

===========================

"""

from enum import Enum, unique

import random

@unique

class Suite(Enum):

"""花色"""

SPADE, HEART, CLUB, DIAMOND = range(4)

def __lt__(self, other):

return self.value < other.value

class Card:

"""牌"""

def __init__(self, suite, face):

"""初始化方法"""

self.suite = suite

self.face = face

def show(self):

"""显示牌面"""

suites = ['♠︎', '♥︎', '♣︎', '♦︎']

faces = ['', 'A', '2', '3', '4', '5', '6',

'7', '8', '9', '10', 'J', 'Q', 'K']

return f'{suites[self.suite.value]}{faces[self.face]}'

def __repr__(self):

return self.show()

class Poker:

"""扑克"""

def __init__(self):

self.index = 0

self.cards = [Card(suite, face)

for suite in Suite

for face in range(1, 14)]

def shuffle(self):

"""洗牌(随机乱序)"""

random.shuffle(self.cards)

self.index = 0

def deal(self):

"""发牌"""

card = self.cards[self.index]

self.index += 1

return card

@property

def has_more(self):

return self.index < len(self.cards)

class Player:

"""玩家"""

def __init__(self, name):

self.name = name

self.cards = []

def get_one(self, card):

"""摸一张牌"""

self.cards.append(card)

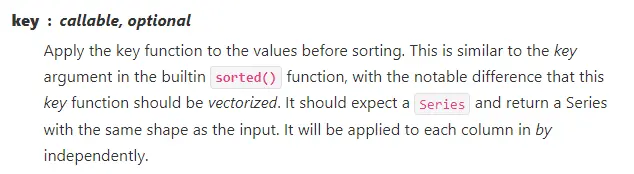

def sort(self, comp=lambda card: (card.face, card.suite)):

"""整理手上的牌"""

self.cards.sort(key=comp)

def main():

"""主函数"""

poker = Poker()

poker.shuffle()

players = [Player('东邪'), Player('西毒'),

Player('南帝'), Player('北丐')]

while poker.has_more:

for player in players:

player.get_one(poker.deal())

for player in players:

player.sort()

print(player.name, end=': ')

print(player.cards)

if __name__ == '__main__':

main()

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

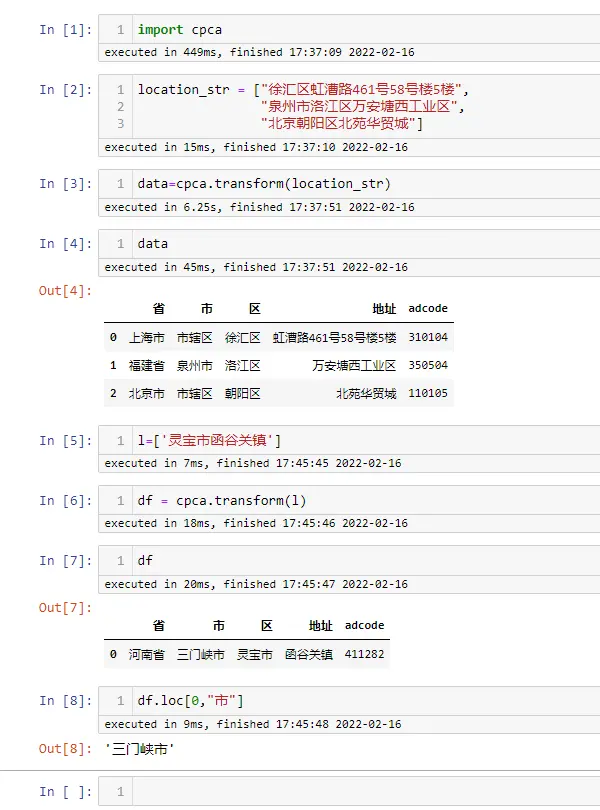

简介

gihub地址: https://github.com/DQinYuan/chinese_province_city_area_mapper

cpca---chinese province city area,一个用于提取简体中文字符串中省,市和区并能够进行映射,检验和简单绘图的python模块

["徐汇区虹漕路461号58号楼5楼", "泉州市洛江区万安塘西工业区"]

↓

省 市 区 地址 上海市 上海市 徐汇区 虹漕路461号58号楼5楼 福建省 泉州市 洛江区 万安塘西工业区 “地址”列:代表去除了省市区之后的具体地址

安装介绍

该库目前仅支持Python3,在命令行直接进行安装即可:

pip install cpca

windows 中需要C/C++编译环境的支持,需要下载另外的软件,然后再进行安装 http://go.microsoft.com/fwlink/?LinkId=691126

编译环境的安装教程: https://o7planning.org/11467/install-microsoft-visual-cpp-build-tools

基本使用方法

常规用法

会自动补全相应的省、市、区

import cpca

location_str = ["徐汇区虹漕路461号58号楼5楼",

"泉州市洛江区万安塘西工业区",

"北京朝阳区北苑华贸城"]

data=cpca.transform(location_str)

data

l=['灵宝市函谷关镇']

df = cpca.transform(l)

df

df.loc[0,"市"]

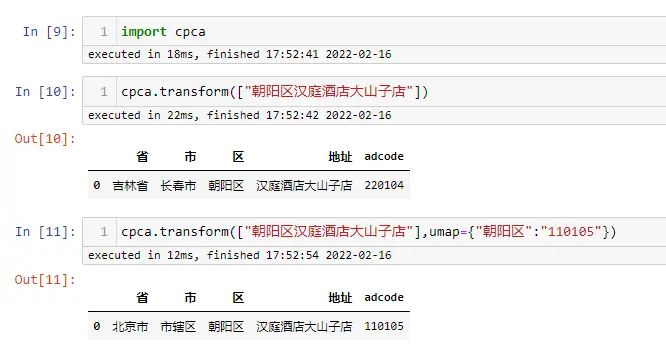

重名情况

中国的区级行政单位非常的多,经常有重名的情况,比如“北京市朝阳区”和“吉林省长春市朝阳区”,当有上级地址信息的时候,cpca 能够根据上级地址 推断出这是哪个区,但是如果没有上级地址信息,单纯只有一个区名的时候, cpca 就没法推断了,只能随便选一个了, 通过 umap 参数你可以指定这种情况下该选择哪一个

从例子可以看出,umap 字典的 key 是区名,value 是区的 adcode,这里 110105 就是北京市朝阳区的 adcode,具体的 adcode 可以去全国行政区划查询平台上查询

全国行政区划查询平台: http://xzqh.mca.gov.cn/map

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

随着Python版本的更新,背后的一些数据结构会进行不断优化迭代,重新进行架构设计,以实现内存减少、性能提升。其中字典的底层数据结构在Python3.6版本时,重新进行了设计,从而优化了字典的内存占用

具体的底层细节这里不做过多介绍,感兴趣的同学可以看一下这篇文章: 《为什么Python 3.6以后字典有序并且效率更高?》 地址:https://zhuanlan.zhihu.com/p/73426505

该文章的评论精彩评论: 一句话解释:从Python3.6开始,dict的实现由 哈希表 改成 链式哈希表

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.4

测试代码

#创建测试数据

keys=[chr(i) for i in range(97,123)]

values=range(1,27)

#生成字典

dic={}

for key,value in zip(keys,values):

dic[key]=value

#打印字典

print(dic)

#{'a': 1, 'b': 2, 'c': 3, 'd': 4, 'e': 5, 'f': 6,

#'g': 7, 'h': 8, 'i': 9, 'j': 10, 'k': 11, 'l': 12,

# 'm': 13, 'n': 14, 'o': 15, 'p': 16, 'q': 17,

#'r': 18,'s': 19, 't': 20, 'u': 21, 'v': 22,

# 'w': 23, 'x': 24, 'y': 25, 'z': 26}

#遍历字典

for key,value in dic.items():

print(key,':',value,end=',')

#a : 1,b : 2,d : 4,e : 5,f : 6,g : 7,h : 8,j : 10,

#k : 11,l : 12,n : 14,o : 15,p : 16,q : 17,r : 18,

#s : 19,t : 20,u : 21,v : 22,w : 23,x : 24,z : 26,

#删除测试

del dic['c']

del dic['y']

del dic['i']

del dic['m']

print(dic)

#{'a': 1, 'b': 2, 'd': 4, 'e': 5, 'f': 6, 'g': 7,

#'h': 8, 'j': 10, 'k': 11, 'l': 12, 'n': 14, 'o': 15,

#'p': 16, 'q': 17, 'r': 18, 's': 19, 't': 20,

#'u': 21, 'v': 22, 'w': 23, 'x': 24, 'z': 26}

结论

经过添加、删除操作可以看出,字典是按添加键值对时的先后顺序保存数据,是有序的

历史相关文章

- Python 标准库之pathlib,路径操作

- Python 记录re正则模块,方便后期查找使用

- Python 内建模块 bisect,数组二分查找算法

- Python 标准库heapq,堆数据结构操作详解

- Python math模块详解

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

概述

math模块是内置模块,提供了许多对浮点数的数学运算函数,提供类似C语言标准定义的数学函数(This module provides access to the mathematical functions defined by the C standard)

包含以下 七部分 函数:

- 算术函数(Number-theoretic and representation functions)

- 幂函数与对数函数(Power and logarithmic functions)

- 三角函数(Trigonometric functions)

- 角度转换函数(Angular conversion)

- 双曲函数(Hyperbolic functions)

- 特殊函数(Special functions)

- 常量(Constants)

math模块常用函数

虽然math模块提供的函数很多,但是现阶段工作中使用的很少,下面就列出一些实际工作中常用的函数:

注意:虽然math是内置模块,但使用前需要先import导入该库

import math

- math.ceil(x)----------向上取整

>>> math.ceil(2.1)

3

>>> math.ceil(3.7)

4

>>> math.ceil(-1.5)

-1

>>> math.ceil(-3.1)

-3

- math.floor(x)----------向下取整

>>> math.floor(1.2)

1

>>> math.floor(4.8)

4

>>> math.floor(-0.1)

-1

>>> math.floor(-2.8)

-3

- math.exp(x)----------e的x次方,其中 e = 2.718281… 是自然对数的基数

>>> math.exp(1)

2.718281828459045

>>> math.exp(2)

7.38905609893065

>>> math.exp(0)

1.0

- math.log(x,base=e)---------- 默认返回x 的自然对数,默认底为 e,如果指定底,返回指定底的对数

>>> math.log(math.exp(1))

1.0

>>> math.log(math.exp(0))

0.0

>>> math.log(math.exp(2))

2.0

>>> math.log(4,base=2)

2.0

>>> math.log(9,base=3)

2.0

>>> math.log(100,base=10)

2.0

- math.pow(x, y)---------- x 的 y 次幂

>>> math.pow(2,3)

8.0

>>> math.pow(4,2)

16.0

>>> math.pow(-5,2)

25.0

- math.sqrt(x)---------- x 的算术平方根,也就是正数的平方根

>>> math.sqrt(25)

5.0

>>> math.sqrt(4)

2.0

>>> math.sqrt(10)

3.1622776601683795

- math.pi---------- 常量π,15位小数

>>> math.pi

3.141592653589793

- math.e---------- 常量e,15位小数

>>> math.e

2.718281828459045

- math.sin(x)---------- x弧度的正弦值

>>> math.sin(math.pi/2)

1.0

>>> math.sin(math.pi/3)

0.8660254037844386

>>> math.sin(math.pi/6) #近似0.5

0.49999999999999994

>>> math.sin(math.pi/4)

0.7071067811865476

- math.cos(x)---------- x弧度的余弦值

>>> math.cos(0)

1.0

>>> math.cos(math.pi/3) #近似0.5

0.5000000000000001

>>> math.cos(math.pi/4)

0.7071067811865476

- math.degrees(x)----------将角度 x 从弧度转换为度数

>>> math.degrees(math.pi)

180.0

>>> math.degrees(math.pi/2)

90.0

>>> math.degrees(math.pi/6) #近似30

29.999999999999996

- math.radians(x)----------将角度 x 从度数转换为弧度

>>> math.radians(90)

1.5707963267948966

>>> math.radians(180)

3.141592653589793

>>> math.radians(360)

6.283185307179586

度数、弧度概念可参考历史相关文章,有详细说明

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号,不定期分享干货

作者:数据人阿多

介绍

偏函数(functools.partial),主要用来解决函数中某些参数是已知的固定值。利用偏函数的概念,可以生成一些新的函数,在调用这些新函数时,不用再传递固定值的参数,这样可以使代码更简洁

下面列举一些偏函数的巧妙使用方法,在使用偏函数时,需要从标准库functools中导入

from functools import partial

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.4

生成不同的聚合函数

1. 创建底层的元函数、函数类

from functools import partial

def aggregation_fn_meta(aggregation_fn, values):

return aggregation_fn(values)

def aggregation_fn_class(aggregation_fn):

return partial(aggregation_fn_meta, aggregation_fn)

2. 基于函数类,来生成不同的聚合函数

- 基于内建函数创建(python中可以直接使用的函数)

sum_fn=aggregation_fn_class(sum)

sum_fn([1,2,3,4,5,1,2,10]) #28

max_fn=aggregation_fn_class(max)

max_fn([1,2,3,4,5,1,2,10]) #10

min_fn=aggregation_fn_class(min)

min_fn([1,2,3,4,5,1,2,10])

- 基于自定义函数创建

def count(values):

return len(values)

count_fn=aggregation_fn_class(count)

count_fn([1,2,3,4,5,1,2,10]) #8

def distinct_count(values):

return len(set(values))

distinct_count_fn=aggregation_fn_class(distinct_count)

distinct_count_fn([1,2,3,4,5,1,2,10]) #6

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

前言

无论是在自己Windows、MacOS电脑,还是在Linux服务器,在操作文件时,多多少少都会涉及到文件的管理。

Python里面有个自带的 os 模块,专门是用来对文件、路径等进行管理的工具,下面列出一些自己在工作中常用的函数、方法,供大家参考学习。

路径的正确表示,三种都可以

- 由于

\是转义的意思,所以路径都用\\表示,例如:'C:\\Users\\abc\\Desktop' - 如果想用单个

\,可以在前面加个r,例如:r'C:\Users\abc\Desktop' - 也可以用

/来表示,例如:'C:/Users/abc/Desktop'

点点们的介绍

./ 当前你所编辑的这个脚本所在目录

../ 当前你所编辑的这个脚本所在目录的上一级目录

os 模块常用函数、方法

- 无需pip安装,可以直接导入

import os

- 获取当前工作路径 也就是你编写的这个脚本所在的文件夹位置

os.getcwd() #C:\\Users\\abc\\Desktop\\Python\\python库

- 获取绝对路径

path='./111.xlsx'

os.path.abspath(path) #C:\\Users\\abc\\Desktop\\Python\\python库\\111.xlsx

- 获取文件的完整路径里面的文件名字

a='C:\\Users\\abc\\Desktop\\Python\\python库\\111.xlsx'

os.path.basename(a) #111.xlsx

- 获取文件的完整路径里面的路径

a='C:\\Users\\abc\\Desktop\\Python\\python库\\111.xlsx'

os.path.dirname(a) #C:\\Users\\abc\\Desktop\\Python\\python库

- 判断是否存在相应的文件或文件夹

a='./111.xlsx'

b='C:\\Users\\abc\\Desktop\\Python\\python库\\111'

os.path.exists(a) #True

os.path.exists(b) #False

- 分隔文件的完整路径为:路径、文件名字

相对上面的方法,这样可以一次都获取到,但是也有缺点,os.path.split只识别

/,不识别\\,因此在用该方法时,需要先进行替换

a='C:\\Users\\abc\\Desktop\\Python\\python库\\111.xlsx'

b,c=os.path.split(a.replace('\\','/'))

#b C:/Users/abc/Desktop/Python/python库

#c 111.xlsx

- 删除存在的文件

a='./111.xlsx'

os.remove(a) #无返回值,直接删除该文件

- 创建文件夹 建议用makedirs方法,这样即可以直接创建单级文件夹,有可以创建多层级文件夹

os.makedirs('./a')

os.makedirs('./1/2')

以上这些方法是在工作中经常使用的,如有新的路径的需求可以在其他一些网站进行查找

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

有时写的Python程序需要交给业务人员使用,但业务人员电脑上基本都没有安装Python,并且业务人员也不会使用命令行,所以就需要把Python程序打包成exe可执行程序,让业务人员无需安装Python,可以直接使用。

这里只针对Windows操作系统的打包,以及只针对业务人员使用场景。(Linux系统基本都是技术开发人员在使用,基本都用的是命令行;而Mac系统不知是否有相关的打包库,可以打包为dmg)

打包过程(以下均为在cmd命令行执行)

- 首先安装第三方库:

pyinstaller

pip install pyinstaller

- 打包

需要先切换到打包程序目录,cd c:\xxx\xxx然后对Python程序进行打包

pyinstaller -F xxx.py

- 结果

如果打包成功,当前目录下会增加一个新的dist文件夹,打开该文件夹,会发现打包好的exe文件:xxx.exe,文件名与Python程序文件相同 - 其他

打包大概流程如上所示,除此之外pyinstaller支持其他一些功能,比如打包时指定自定义图标,首先需要下载一张正常的ico,不能用直接修改后缀的,然后进行打包,一定是先图标文件路径,再是程序路径,如下所示:

pyinstaller -F -i xxx.ico xxx.py

注意事项!!!

- 运行报错

虽然经过一番折腾,终于打包好exe可执行程序,但是双击运行时总是报错,无法成功运行,这种情况大多数是因为缺少第三方库造成的。

解决方法:

在打包之前先在cmd运行一次Python程序看是否成功运行

python xxx.py

- 如果能成功运行,那么打包后基本没什么问题

- 如果运行失败,那么查看报错信息,是否缺少第三方库,然后进行

pip安装,确保能成功运行

- 文件太大

以上打包过程是不是很简单,但是有没有注意打包的exe文件有时会很大,有时几百兆大小,但是自己的Python程序也就几KB,这个问题也是自己之前遇到的难题(使用的是Anaconda),即使另外建立了新的环境也不行(conda create -n 环境名)

解决方法:

一定要使用Python官网下载的原生Python程序,并且确保系统环境变量里面只有这一个Python路径,只有这一个Python路径,只有这一个Python路径!!!

亲测自己的打包程序从200M降到50M大小

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号DataShare,不定期分享干货

作者:数据人阿多

背景

最近小编利用业余时间充电,细读了《Python 编程从新手到高手》这本书的部分章节,作者:【美】贾森·C. 麦克唐纳,其中确实藏了不少干货!一些之前未曾涉猎的知识点,这次也被一一解锁。整理出来部分内容,分享给大家一起学习交流,共同进步呀~ 📚✨

该书中文版的翻译还是差点意思,读起来不是很通顺

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.11

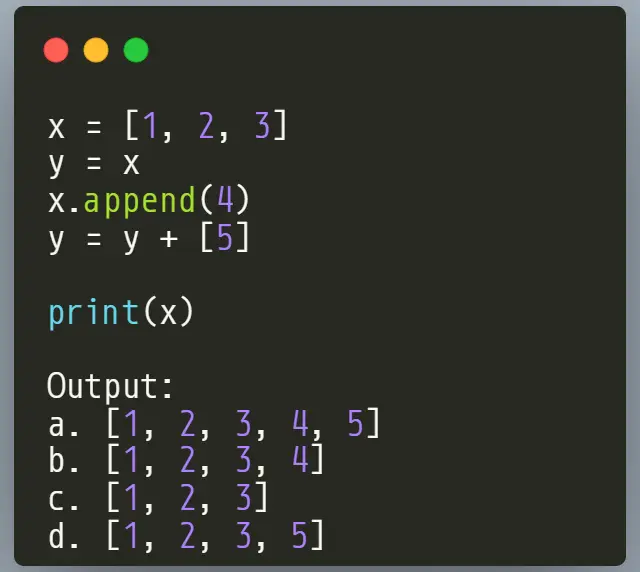

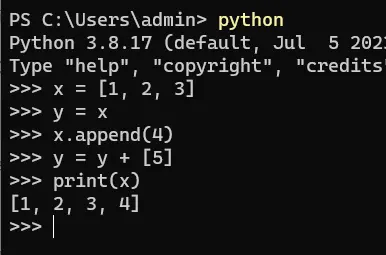

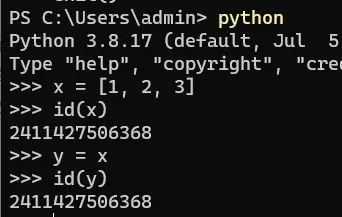

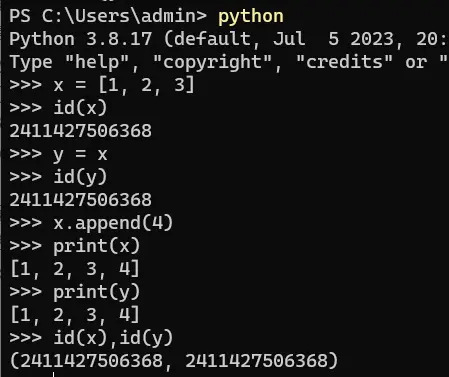

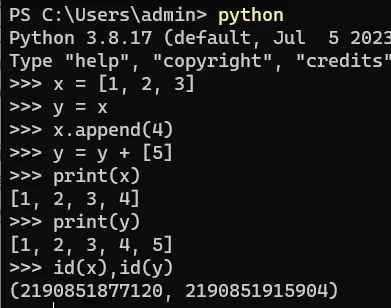

Python中的变量:名称和值

原文中关于 变量 的描述:Python 用name(名称)和 value(值)来代替variable(变量)

- 一个name指向一个value或object(对象),就像你的名字指向你一样。可能有多个name指向同一个value,就像你可能有一个名字和一个昵称

- 一个value是内存中一个特定的数据实例

- “变量”这个术语指代这两者的组合:一个name指向一个value

- 名称有作用域,它们随着函数的出现而出现,随着函数的消失而消失,但是它们没有类型

- 值有类型,但是没有作用域

- 名称被绑定到值,而这些值存在于内存中,且有一些引用指向它们。你可以把一个名称绑定到任何你想要的值上,但是你只能对特定的值执行一些有限的操作

作者强调:虽然Python是一种动态类型的语言,但是Python仍然是一种强类型的语言。名称可以随意绑定到不同类型的值上面,但是任何值都是有类型的

类属性与类方法

- 类属性属于类本身,而不属于某个实例。实际上,这意味着所有相关的类实例“共享”类属性。即使没有任何实例,类属性也依然存在

- 类方法属于类,而不属于类的某个实例

@classmethod

def inform(cls, codeword):

cls._codeword = codeword

以上代码在类方法上使用了@classmethod装饰器。类方法将类作为其第一个参数接收,因此第一个参数被命名为cls。该inform()类方法既可以直接在SecretAgent类上调用,也可以在任何SecretAgent实例(如fox)上调用。inform()对类属性_codeword所做的更改会出现在类本身及其所有实例上

流

要想处理任何数据文件,你需要获得一个流(又称文件对象或类文件对象),其提供读取和写入内存中的特定文件的方法。一般存在两种流:

- 二进制流是所有流的基础,用来处理二进制数据(0和1)

- 文本流则处理二进制文本的编码和解码

print 刷新

- 指定参数:

print('.', end='', flush=True),大家一般使用的方法 - 全局的方法:如果需要所有的print()调用默认每次都刷新,可以在非缓冲模式下运行Python,只需要在调用程序时将-u选项传递给Python解释器即可,如

python3 -u test.py

并发与并行

- 并发(concurrency)是编程中的多任务处理:在多个任务之间快速分配程序的注意力

- 并行(parallelism),并行是指多个任务同时发生

- 有两种方法可以在Python中实现并发:线程、异步

重点是记住这2个英文单词,比如在hive sql中,任务在集群中运行,可以启动并行,set hive.exec.parallel=true;,中文翻译有时会忽略两者差异

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

你是否听说过 Python 中的 单实例模式(Singleton Pattern)? ,小编之前在阅读别人代码的时候曾经遇到过,一直不知道那段代码什么含义,后来在搜索资料时,才知道那段代码的含义是创建单实例,也正是从那之后,才知道这个名词 “单实例”,是 Python 中的一种设计模式,用大白话说就是类的实例对象在内存中只有一个

单实例模式代码

class Singleton:

_instance = None

def __new__(cls, *args, **kwargs):

if not cls._instance:

cls._instance = super(Singleton, cls).__new__(cls, *args, **kwargs)

return cls._instance

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.11

借助大模型进行详细解释

首次创建实例对象时,类的属性 _instance = None,然后程序会进入 if 条件进行执行,重点语句:

cls._instance = super(Singleton, cls).__new__(cls, *args, **kwargs)

# cls._instance = super().__new__(cls, *args, **kwargs)

1. super(Singleton, cls) 的作用

- super函数:用于获取父类(基类)的方法,继承父类,进行父类初始化的用法

- 参数含义:

Singleton:当前类cls:当前类的引用(在类方法中,cls代表类本身)

这种写法明确指定了从Singleton类开始,在MRO(Method Resolution Order)中查找父类。在Python 3中可以简化为super(),但这种写法更清晰地展示了继承关系

2. .__new__(cls, *args, **kwargs)

- 调用父类的

__new__方法:这是实际创建对象实例的关键步骤

super(Singleton, cls).__new__(cls) → 实际调用object.__new__(Singleton)

在 CPython(Python 的官方实现)中,object.__new__ 是用 C 语言实现的底层函数。它的核心工作是:

- 内存分配:为新对象分配适当的内存空间

- 对象初始化:设置对象的基本结构

- 返回原始对象:返回一个"空"的、未初始化的对象实例

object.__new__ 是底层实现,它不会触发 Python 层面的 __new__ 方法调用

当 object.__new__ 执行时:

- 它直接操作内存分配,不经过 Python 的方法查找机制

- 它是解释器内置的 C 函数,不是 Python 函数

- 它的工作就是创建原始对象,不会检查或调用任何

__new__方法

object.__new__(Singleton) 的工作原理:

- 内存分配:为 Singleton 实例分配适当大小的内存

- 对象初始化:设置基本对象头(类型指针、引用计数等)

- 返回原始对象:返回一个"空"的、未初始化的对象实例

3. 返回赋值 cls._instance=

经过第2步之后,会将原始对象赋值给 cls._instance,其实是类在内存中的地址/指针,这样类的属性不再为None,后续如果再次创建实例时,直接返回第一次创建好的实例对象

单例模式的核心优点

- 节省内存资源:在内存中只有一个对象,避免了重复创建实例带来的内存浪费

- 减少系统开销:单例可长驻内存,避免频繁的创建和销毁对象,减少系统开销

- 全局访问点:提供一个全局访问点,允许在应用程序中轻松访问该唯一实例

- 数据同步控制:全局只有一个接入点,可以更好地进行数据同步控制,避免多重占用

单例模式的实际应用场景

- 日志记录器:应用程序通常只需要一个日志记录器实例,避免多个日志文件冲突

- 数据库连接池:数据库连接是稀缺资源,使用单例模式可以统一管理连接,避免资源浪费

- 配置管理:应用程序的全局配置通常只需要一个实例,保证配置的一致性,比如大模型在内存/GPU中只初始化一次,来处理所有的用户请求

- 缓存系统:全局缓存需要统一管理,避免多个缓存实例导致数据不一致

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

在Python编程中,函数参数的设计直接影响代码的健壮性和可预测性。**一个需要警惕的实践是:避免将可变对象(尤其是列表)作为函数参数的默认值。**这样做可能导致极其隐蔽且令人困惑的bug

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.11

现象:一个诡异的“记忆”功能

想象你设计了一个函数,用来记录新添加的学生姓名到某个班级列表。如果列表为空,则创建一个新列表:

def add_student(name, student_list=[]):

student_list.append(name)

return student_list

# 第一次调用:添加Alice

class1 = add_student("Alice")

print(class1) # 输出: ['Alice']

# 第二次调用:添加Bob

class2 = add_student("Bob")

print(class2) # 输出: ['Alice', 'Bob']

问题来了: 第二次调用add_student("Bob")时,并没有传递student_list参数,期望的是生成一个只包含**"Bob"的新列表。但结果却包含了第一次添加的"Alice"**!这个函数似乎“记住了”之前的调用

原因揭秘:列表是引用类型

要理解这个问题的本质,必须明白Python中变量的工作方式:

-

列表是引用类型 在Python中,变量存储的是对象的引用(内存地址),而不是对象本身。当你将一个列表赋值给变量时,实际上是在创建一个指向列表对象的引用。

-

默认参数的创建时机 当Python解释器遇到函数定义时,它会立即创建默认参数对象。对于列表这样的可变对象,这意味着只有一个列表对象被创建,并且这个对象会持续存在于整个程序的生命周期中。

-

函数调用时的陷阱 当你多次调用函数而不提供参数时,Python不会创建新的列表,而是重复使用同一个默认列表对象。因为列表是可变的,每次对它的修改都会永久改变这个共享对象。

-

引用传递的后果 由于函数操作的是指向同一个列表对象的引用,所有使用默认参数的调用实际上都在操作同一个物理列表。这就是为什么数据会"神奇地"在函数调用之间保留下来

解决方案:使用不可变默认参数

正确的做法是使用 None 作为哨兵值

def add_item(item, items=None):

if items is None:

items = [] # 每次调用都创建新列表

items.append(item)

return items

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

Python以其灵活性著称,这种特性在函数参数设计中尤为明显。本文将依据语言规范,系统阐述Python函数所支持的全部参数类型及其应用

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.11

完整函数参数示例1

def func(pos_only=None, /, pos_kw=None, *, kw_only=None):

- 仅位置参数 (Positional-only) :

/前面的参数 标识:使用/符号分隔 特点:只能通过位置传递,不能使用参数名

def func(a, b, /, c):

# a, b 是仅位置参数

pass

# 正确调用

func(1, 2, 3) # a=1, b=2, c=3

func(1, 2, c=3) # a=1, b=2, c=3

# 错误调用

func(a=1, b=2, c=3) # TypeError: 不能使用关键字传递a, b

- 位置或关键字参数 (Positional-or-keyword):

/和*之间的参数 位置:在/之后,*之前(如果没有/或*,则在所有参数中) 特点:既可以通过位置传递,也可以通过关键字传递

def func(a, b, c):

# 传统写法,所有参数都是位置或关键字参数

pass

# 两种方式都可以

func(1, 2, 3) # 位置传递

func(a=1, b=2, c=3) # 关键字传递

func(1, b=2, c=3) # 混合传递

- 仅关键字参数 (Keyword-only):

*后面的参数 标识:使用*符号分隔,或者单个*特点:必须使用关键字传递

def func(*, a, b):

# a, b 是仅关键字参数

pass

# 正确调用

func(a=1, b=2)

# 错误调用

func(1, 2) # TypeError: 必须使用关键字参数

完整函数参数示例2

def comprehensive(

pos_only_1, # 仅位置参数

pos_only_2=10, # 带默认值的仅位置参数

/, # 分隔符

pos_kw_1, # 位置或关键字参数

pos_kw_2=20, # 带默认值的位置或关键字参数

*args, # 可变位置参数

kw_only_1, # 仅关键字参数

kw_only_2=30, # 带默认值的仅关键字参数

**kwargs # 可变关键字参数

):

pass

# 调用示例

comprehensive(

1, # pos_only_1

2, # pos_only_2

3, # pos_kw_1

pos_kw_2=4, # pos_kw_2

5, 6, # 进入args

kw_only_1=7, # kw_only_1

kw_only_2=8, # kw_only_2

extra1=9, # 进入kwargs

extra2=10 # 进入kwargs

)

- 可变位置参数:

*args

def func(a, *args, b=10):

# args收集所有额外的位置参数

pass

func(1, 2, 3, 4) # a=1, args=(2,3,4), b=10

- 可变关键字参数:

**kwargs

def func(a, **kwargs):

# kwargs收集所有额外的关键字参数

pass

func(1, x=2, y=3) # a=1, kwargs={'x':2, 'y':3}

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

近2年随着Rust语言的大力发展,一些系统与软件开始逐渐使用Rust语言来实现,并且一些大型公司也开始逐渐转向Rust

因为在学习 Polars 库时,看到该库是使用Rust实现的,小编近一年也逐渐开始学习Rust语言,了解到其中的一些思想相对其他语言来说确实比较先进,所有权概念的引入,不仅可以提升性能,而且还保证了数据安全、准确,不会有数据竞争问题的产生

小编最近在处理加解密任务时,借助Rust语言实现了一个DES加解密库,借助Rust 中的 pyo3 包,在Python 中借助 maturin 库,可以把 Rust 实现的库转换为 Python 的包,供Python调用

DES加解密,Rust实现

#![allow(unused)] fn main() { use pyo3::prelude::*; use openssl::provider::Provider; use openssl::symm::{Cipher,encrypt,decrypt}; use hex; const KEY:&[u8; 8]=b"ABCD1234"; const IV:&[u8; 8]=b"ABCD1234"; #[pyfunction] fn des_encrypt(data:String)-> String { let _provider = Provider::try_load(None, "legacy", true).unwrap(); let cipher: Cipher = Cipher::des_cbc(); let ciphertext = encrypt(cipher, KEY, Some(IV), data.as_bytes()); hex::encode(&ciphertext.unwrap()).to_uppercase() } #[pyfunction] fn des_decrypt(data:String)-> String { let _provider = Provider::try_load(None, "legacy", true).unwrap(); let cipher: Cipher = Cipher::des_cbc(); match hex::decode(&data) { Ok(bytes) => { // println!("Decoded: {:?}", bytes); // 输出: [104, 101, 108, 108, 111] // println!("{:?}", des_decrypt(&bytes)); match decrypt(cipher, KEY, Some(IV), &bytes) { Ok(bytes) => { // println!("Decoded: {:#?}", bytes); // 输出: [104, 101, 108, 108, 111] match String::from_utf8(bytes) { Ok(string) => string, // 输出: "hello" Err(_) => "".to_string(), } }, Err(_) => "".to_string(), } }, Err(_) => "".to_string(), } } #[pymodule] fn des_rust(_py: Python, m: &PyModule) -> PyResult<()> { m.add_function(wrap_pyfunction!(des_encrypt, m)?)?; m.add_function(wrap_pyfunction!(des_decrypt, m)?)?; Ok(()) } }

然后利用 Maturin 进行打包,可以生成 Python 的库/包/轮子,小编这里生成的是 des_rust-0.1.0-cp37-abi3-win_amd64.whl

然后安装该包后,即可在Python中进行使用

Python 使用

from des_rust import des_decrypt,des_encrypt

data=des_decrypt(des_encrypt('DataShare'))

print(data) #DataShare

通过性能测试,效率相对使用Python实现的包,性能有大幅提升

进一步思考

通过以上的案例,小编走通了从Python中调用Rust代码的流程,结合小编学习 Rust 的思考,那么Rust + Python 结合,是否会成为将来数据分析、机器学习领域的趋势?

-

Python 比较灵活,拿来即用,学习起来也容易,现在普及程度也很广,最重要的是能很快出成果,处在现阶段的社会,出成果很重要,有的老板恨不得第1天晚上想出了一个idea,第2天就想要成果,当然这个也不能怨老板,只能说现阶段竞争很激烈

-

Rust 内存安全、性能高,可以弥补Python 的不足,截止当前已经有很多Python 库是使用Rust 实现的,随着老板的想发愈发复杂,想提升数据处理性能,只能使用底层的语言实现,但也不能另起炉灶,否则前期的工作相当于白做,而且业务也需要快速迭代

Rust + Python 结合是否会成为将来数据领域的趋势呢?让我们拭目以待

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

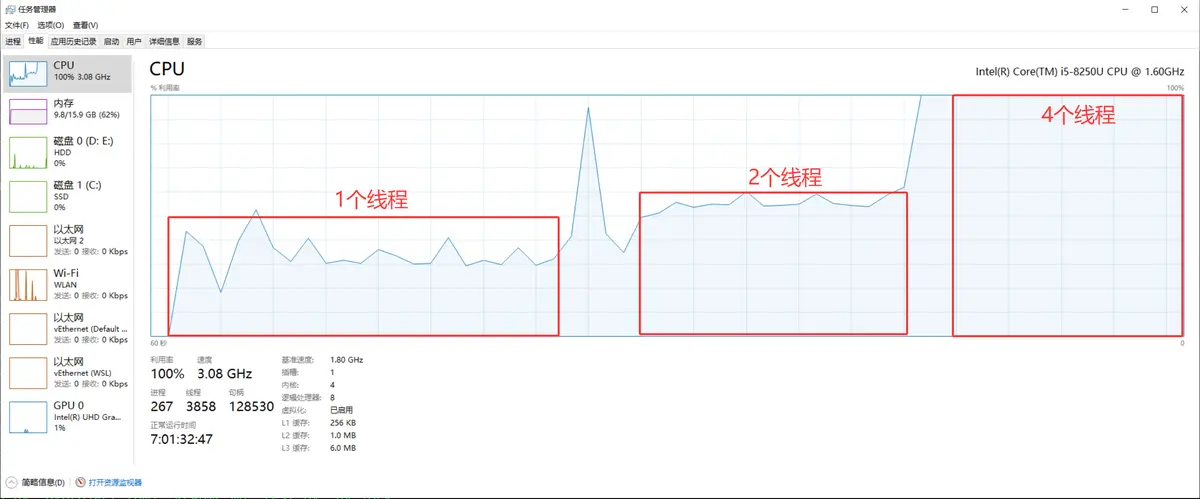

背景

Python 3.14 自2025年10月7日发布以来,已在技术社区中积累了丰富的实践与评测资料。目前国内的相关文章大多译自国外大神的博客文章,内容都很“高大上”,但在普遍适用性方面尚缺乏贴近实际的基础案例。为此,本文旨在提供一个通用的实践示例,作为后续深入研究和学习的baseline

名词解释

自由线程、无GIL与英文术语 Free-threaded 同义,均指代同一项核心语言特性,即代码在执行时不再受全局解释器锁(GIL)的约束

小编环境

#Win10 系统 安装uv

pip install uv

uv -V

#uv 0.9.0 (39b688653 2025-10-07)

python -VV

#Python 3.14.0 free-threading build (main, Oct 7 2025, 15:34:02) [MSC v.1944 64 bit (AMD64)]

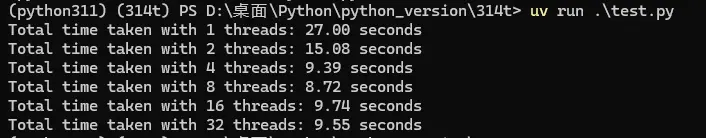

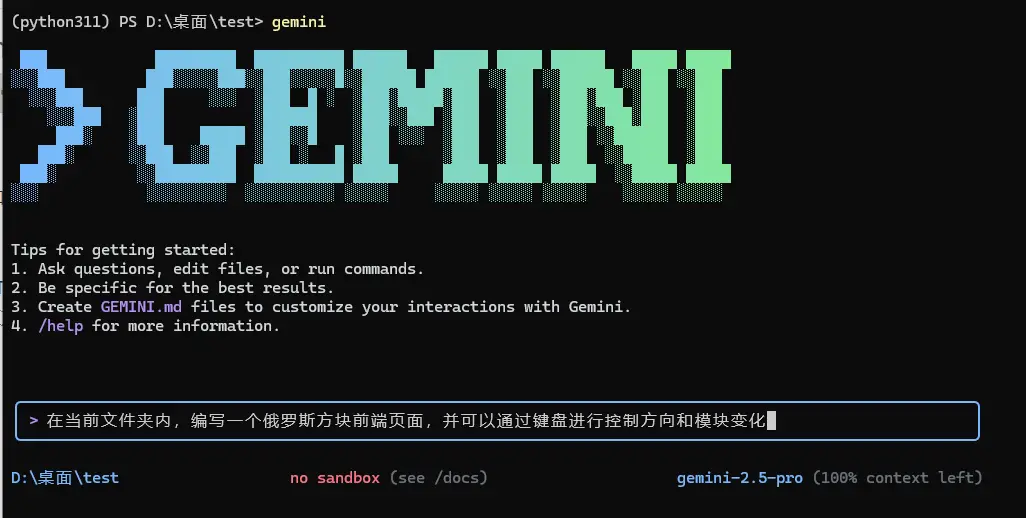

测试结果图

安装python3.14无GIL解释器

目前,Python官方的标准构建版本仍默认包含全局解释器锁(GIL)。若需使用无GIL的解释器,开发者需从源代码自行构建,或选用由社区提供的预编译版本。值得注意的是,工具 uv 现已提供预编译的无GIL解释器,支持用户直接安装使用。

mkdir 314t && cd 314t #创建目录

uv init #初始化项目

uv python list #查看所有可用的python版本

uv python install cpython-3.14.0+freethreaded-windows-x86_64-none #安装无GIL版本

uv python pin 3.14t #切换项目解释器

测试代码

#test.py

import time

import threading

import queue

N = 3_0000_0000 #模拟任务量

def cpu_bound_task(n, thread_id, q):

count = 0

for i in range(n):

count += i * i

q.put(count)

def run_with_threads(num_threads):

threads = []

start = time.time()

q = queue.Queue()

for i in range(num_threads):

t = threading.Thread(

target=cpu_bound_task,

args=(N // num_threads, i, q) #每个线程计算 1/n

)

threads.append(t)

t.start()

for t in threads:

t.join()

end = time.time()

print(f"Total time taken with {num_threads} threads: {end - start:.2f} seconds")

if __name__ == "__main__":

for num in [1, 2, 4, 8, 16, 32]:

run_with_threads(num)

运行测试代码: 小编电脑是物理4核,启动4个线程时,CPU利用率达到100%

uv run test.py

#Total time taken with 1 threads: 27.00 seconds

#Total time taken with 2 threads: 15.08 seconds

#Total time taken with 4 threads: 9.39 seconds

#Total time taken with 8 threads: 8.72 seconds

#Total time taken with 16 threads: 9.74 seconds

#Total time taken with 32 threads: 9.55 seconds

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

装饰器:Python开发者的效率利器! 🛠️

在Python的世界里,装饰器绝对是一把强大的“瑞士军刀”。它能帮我们优雅地封装通用逻辑,大幅减少重复代码,真正实现事半功倍的开发效率。

如果你是第一次接触装饰器这个概念,强烈建议先找些基础资料了解一下它的核心思想和工作原理(别担心,小编当初也是一头雾水,看别人的代码完全摸不着头脑)。打好基础再往下看,理解起来会顺畅得多,相信小编!

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.11

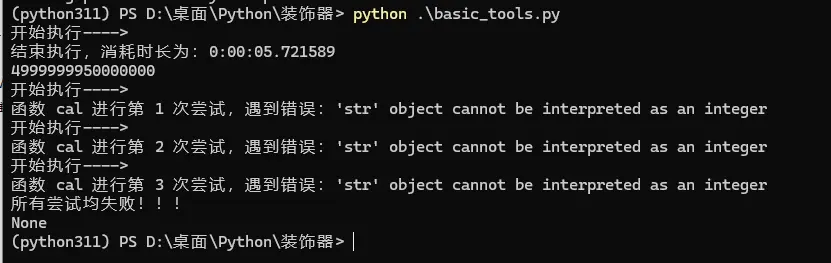

计算耗时

想知道函数执行耗时?一个装饰器轻松搞定!⏱️

还在手动写 time.time() 包裹你的函数来计算耗时吗?太麻烦啦!只需几行代码定义一个计时装饰器,轻轻松松给任何函数“戴上”,就能自动获取精准的执行时间

def time_it(func):

@wraps(func) # 保留原始函数的元数据

def wrapper(*args, **kwargs):

print("开始执行---->")

start_time=datetime.datetime.now()

result = func(*args, **kwargs)

end_time=datetime.datetime.now()

print(f"结束执行,消耗时长为:{end_time - start_time}")

return result

return wrapper

重试机制

在程序中调用外部API、访问数据库或进行网络请求时,网络环境的不稳定性往往是导致程序“意外扑街”的头号元凶!面对这种不可控因素,与其祈祷网络永远畅通,不如主动出击——引入重试机制,来增加程序的健壮性

def retry(func=None,*,times=3):

if func is None:

return partial(retry,times=times)

@wraps(func)

def wrapper(*args,**kwargs):

for attempt in range(1,times+1):

try:

return func(*args,**kwargs)

except Exception as exc:

print(f"函数 {func.__name__} 进行第 {attempt} 次尝试,遇到错误:{exc}")

sleep(SLEEP_TIME * attempt)

print(f"所有尝试均失败!!!")

return None

return wrapper

完整代码

from time import sleep

import datetime

from functools import wraps,partial # 导入 wraps 装饰器

SLEEP_TIME=1

def time_it(func):

@wraps(func) # 保留原始函数的元数据

def wrapper(*args, **kwargs):

print("开始执行---->")

start_time=datetime.datetime.now()

result = func(*args, **kwargs)

end_time=datetime.datetime.now()

print(f"结束执行,消耗时长为:{end_time - start_time}")

return result

return wrapper

def retry(func=None,*,times=3):

if func is None:

return partial(retry,times=times)

@wraps(func)

def wrapper(*args,**kwargs):

for attempt in range(1,times+1):

try:

return func(*args,**kwargs)

except Exception as exc:

print(f"函数 {func.__name__} 进行第 {attempt} 次尝试,遇到错误:{exc}")

sleep(SLEEP_TIME * attempt)

print(f"所有尝试均失败!!!")

return None

return wrapper

if __name__=='__main__':

@retry

@time_it

def cal(x):

total=0

for i in range(x):

total += i

return total

print(cal(100000000))

print(cal('100000'))

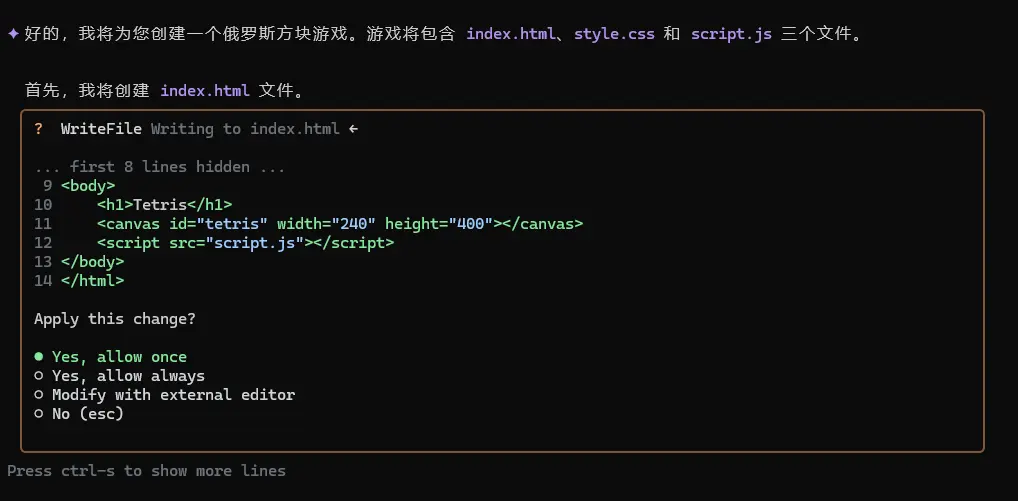

运行测试结果

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

虽然 Python 中已提供了 列表、字典 等非常灵活的数据结构,但是**collections** 模块提供了高性能的容器数据类型,能大幅优化代码效率和可读性,本文将深入解析该模块中的六大核心工具,助你写出更优雅的Python代码,避免你重复造轮子

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.11

namedtuple:命名元组

传统元组通过索引访问元素,代码可读性差:

point = (2, 5)

print(f"X: {point[0]}, Y: {point[1]}") # 可读性低

namedtuple 赋予元组字段名

from collections import namedtuple

# 创建具名元组类型

Point = namedtuple('Point', ['x', 'y'])

p = Point(2, 5)

print(p.x, p.y) # 直观访问

print(p._asdict()) # 转为字典:{'x': 2, 'y': 5}

✅ 适用场景:数据库查询结果、坐标点等轻量级数据结构

deque:高效双端队列

列表(list)在头部插入/删除效率为 O(n),deque 在两端操作均为 O(1)

from collections import deque

d = deque([1, 2, 3])

d.appendleft(0) # 左侧添加 → deque([0, 1, 2, 3])

d.extend([4, 5]) # 右侧扩展 → [0,1,2,3,4,5]

d.rotate(2) # 向右旋转 → [4,5,0,1,2,3]

🔥 性能对比:千万元素头部插入

- list.insert(0, x):耗时2.1秒

- deque.appendleft(x):耗时0.02秒

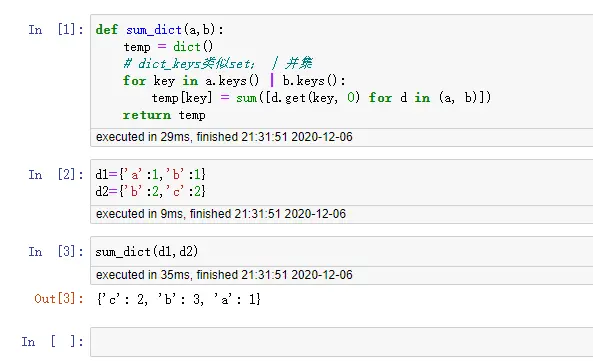

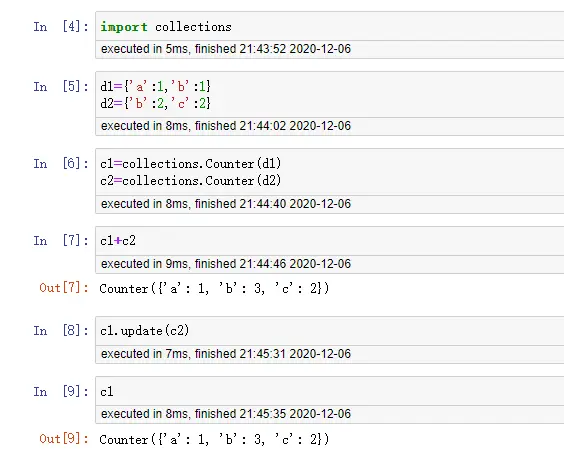

Counter:元素统计利器

快速统计可迭代对象中元素频率

from collections import Counter

text = "python collections is powerful"

word_count = Counter(text.split())

print(word_count.most_common(2))

# 输出:[('python', 1), ('collections', 1)]

# 数学运算

c1 = Counter(a=3, b=1)

c2 = Counter(a=1, b=2)

print(c1 + c2) # Counter({'a': 4, 'b': 3})

💡 进阶技巧:elements()方法生成迭代器,subtract()实现减法操作

defaultdict:智能字典

避免KeyError异常,自动初始化默认值

from collections import defaultdict

# 值为列表的字典

dd = defaultdict(list)

dd['fruits'].append('apple') # 无需初始化

print(dd['animal']) # 访问不存在的key,返回空列表 []

# 值为计数的字典

count_dict = defaultdict(int)

for char in "abracadabra":

count_dict[char] += 1

支持任意可调用对象:defaultdict(lambda: 'N/A')

ChainMap:字典聚合器

合并多个字典而不创建新对象

from collections import ChainMap

dict1 = {'a': 1, 'b': 2}

dict2 = {'b': 3, 'c': 4}

chain = ChainMap(dict1, dict2)

print(chain['b']) # 输出2(dict1优先)

print(chain['c']) # 输出4

# 动态添加字典

chain = chain.new_child({'d': 5})

🌟 特点:查找顺序可定制,原始字典修改实时同步

OrderedDict:有序字典

虽然Python3.7+的dict已有序,但OrderedDict提供额外功能

from collections import OrderedDict

od = OrderedDict()

od['z'] = 1

od['a'] = 2

print(list(od.keys())) # 保持插入顺序:['z', 'a']

# 特殊方法

od.move_to_end('z') # 移动键到末尾 ,OrderedDict([('a', 2), ('z', 1)])

od.popitem(last=False) # FIFO删除,删除 ('a', 2)

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

小编之前写过一篇介绍 pathlib 标准库的文章,最近在做项目时,又发现其有一个更好用的功能,分享给大家,供大家参考学习

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.11

创建目录方法:Path.mkdir()

pathlib.Path.mkdir() 方法是 Python 中创建目录的核心方法,提供了灵活且安全的目录创建功能

方法签名:

Path.mkdir(mode=0o777, parents=False, exist_ok=False)

参数详解:

1. mode (可选)

- 作用: 设置目录权限(Unix/Linux/Mac 系统有效)

- 默认值: 0o777 (八进制,表示最大权限)

- 注意: 在 Windows 上此参数被忽略

常用权限值:

from pathlib import Path

# 创建用户可读/写/执行,组和其他用户只读/执行的目录

Path("my_dir").mkdir(mode=0o755) # drwxr-xr-x

# 创建只有用户可读/写/执行的目录

Path("private_dir").mkdir(mode=0o700) # drwx------

2. parents (可选)

- 作用: 是否自动创建父目录

- 默认值:

False - 当

False时: 父目录必须存在,否则抛出FileNotFoundError - 当

True时: 自动创建所有不存在的父目录

3. exist_ok (可选)

- 作用: 目录已存在时的处理方式

- 默认值:

False - 当

False时: 目录已存在会抛出FileExistsError - 当

True时: 目录已存在不会报错

基础用法示例

示例 1: 创建单级目录

from pathlib import Path

# 在当前目录下创建新文件夹

Path("new_folder").mkdir()

# 创建指定路径的目录

Path("/tmp/example").mkdir()

示例 2: 创建多级目录(使用 parents=True)

from pathlib import Path

# 传统方式 - 需要逐级检查创建

# 这里演示只判断父目录是否存在

path = Path("a/b/c/d/e")

if not path.parent.exists():

path.parent.mkdir()

path.mkdir()

# 简化方式 - 一次性创建所有层级

Path("a/b/c/d/e").mkdir(parents=True)

示例 3: 安全创建目录(使用 exist_ok=True)

from pathlib import Path

# 安全创建 - 目录存在也不报错

Path("my_project").mkdir(exist_ok=True)

# 等同于检查是否存在再创建

path = Path("my_project")

if not path.exists():

path.mkdir()

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

端口扫描技术广泛应用于网络运维、网络安全测试、以及黑客攻击服务器等领域。在网络运维中,管理员通过端口扫描来检查服务器或设备的开放端口,确保网络安全并及时发现潜在的漏洞。在网络安全测试中,端口扫描帮助识别网络中的弱点,进而制定防护措施,提升整体安全性。而在黑客攻击的情境下,攻击者通过端口扫描发现目标设备开放的服务,从而寻找攻击入口点,实施非法入侵。因此,端口扫描不仅是安全防护的一个重要工具,也常被黑客用作攻击手段。

本篇文章的目的是通过构建一个端口扫描工具,深入探讨如何在Python中利用协程进行高效的网络端口扫描。传统的端口扫描通常是串行的,效率较低,尤其在扫描大量IP时,耗时非常长。借助Python的协程特性,我们可以实现高并发的网络扫描,显著提高扫描速度,并且在处理多个任务时能够有效地节省系统资源。通过实践这一过程,读者不仅可以掌握端口扫描的基本原理,还能进一步理解如何在Python中高效地使用协程来解决实际问题。

小编环境

import sys

print('python 版本:',sys.version)

#python 版本: 3.11.11 | packaged by Anaconda, Inc. |

#(main, Dec 11 2024, 16:34:19) [MSC v.1929 64 bit (AMD64)]

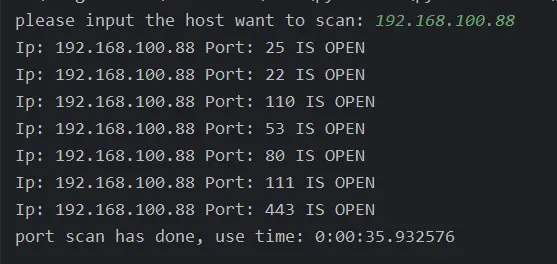

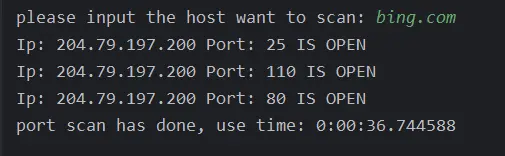

效果

直接扫描IP地址:

扫描域名:

完整代码

import asyncio

import socket

from datetime import datetime

class ScanPort:

def __init__(self, concurrency_limit=100):

self.ip = None

self.concurrency_limit = concurrency_limit # 并发限制,默认是 100

async def scan_port(self, port, semaphore):

try:

# 获取信号量

async with semaphore:

# 创建异步 TCP 连接

conn = asyncio.open_connection(self.ip, port)

reader, writer = await asyncio.wait_for(conn, timeout=1)

writer.close()

await writer.wait_closed()

print(f'Ip: {self.ip} Port: {port} IS OPEN')

except (asyncio.TimeoutError, ConnectionRefusedError, OSError):

pass # 忽略连接超时或端口未开启的错误

async def scan_ports(self):

semaphore = asyncio.Semaphore(self.concurrency_limit) # 限制最大并发数

tasks = []

for port in range(1, 65536): # 要扫描的端口范围

tasks.append(self.scan_port(port, semaphore)) # 为每个端口创建一个异步任务

await asyncio.gather(*tasks) # 并发执行所有任务

def start(self):

host = input("please input the host want to scan: ")

self.ip = socket.gethostbyname(host) # 获取主机的 IP 地址

start_time = datetime.now()

# 执行异步扫描

asyncio.run(self.scan_ports())

print("port scan has done, use time:", datetime.now() - start_time)

if __name__ == "__main__":

# 运行扫描程序

ScanPort(concurrency_limit=2000).start() # 设置并发量限制为2000

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

随着Python在Web开发、数据科学等领域的广泛应用,项目依赖管理与环境部署的效率直接影响着开发体验。传统的Python项目往往需要结合 virtualenv、pip 乃至 pipenv/poetry 等多种工具进行环境隔离、依赖安装与版本管理,步骤繁琐且容易因环境不一致导致运行问题

最近以来,一个名为 uv 的现代化、高性能 Python 包管理工具由 Astral 团队推出,它集成了虚拟环境管理、依赖解析与安装、项目初始化等核心功能,并以其极快的速度和简洁的命令受到开发者关注。uv 旨在简化 Python 项目的搭建与协作流程,通过一行命令即可完成从零开始的环境构建与依赖同步,大大提升了项目初始化与部署的效率

本文将基于一个实际的 FastAPI 项目案例,演示如何利用 uv 快速拉取现有项目、一键部署完整运行环境

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.11

拉取项目

这里以小编创建好的一个测试项目为案例进行操作,页面比较简单 github地址:https://github.com/DataShare-duo/uv_project

在本地终端或者git bash上执行:

git clone git@github.com:DataShare-duo/uv_project.git

uv 部署环境

前提:github上拉取的项目,必须是基于 uv 构建的

部署服务:

cd ./uv_project

uv sync

uv run main.py

在浏览器打开 http://0.0.0.0:8000 即可访问后端的服务,是不是很简单,可见 uv 工具是多么强大,通过一个命令 uv sync 构建好了项目的运行虚拟环境,即可启动服务,以往构建环境是多么的痛苦

本地基于 uv 项目构建

以上的测试项目在本地通过 uv 构建的过程:

uv init uv_project --python 3.11

cd uv_project

uv add fastapi

uv add uvicorn

该项目的前、后端代码,均是利用 DeepSeek 生成,并调试运行成功

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

Python 不再是你记忆中的“弱类型”语言了! 随着类型注释的普及和高版本Python的演进,它正悄然蜕变为一门兼具灵活性与严谨性的现代语言

为什么使用类型注释?

1. 提升可读性 类型注释是代码的“自文档化”工具,明确参数和返回值的类型,让代码意图一目了然

def process_data(data: list[int], threshold: float) -> list[float]:

return [x * threshold for x in data if x > 0]

2. 错误早捕获 结合静态检查工具(如 mypy),在运行前发现类型错误,告别隐藏的 TypeError!

pip install mypy

mypy your_script.py # 静态检查

3. IDE智能支持 VS Code/PyCharm 等工具通过类型注释提供精准的代码补全和错误提示,开发效率翻倍

Python 已悄然“强类型化”

-

动态类型 ≠ 弱类型 Python 仍是动态类型语言,但类型注释的引入(PEP 484)和社区实践推动它向强类型风格演进

-

高版本特性加持(Python 3.10+)

- 联合类型简化:

int | str替代Union[int, str] - 类型守卫:用

isinstance()细化类型范围(PEP 647) - 模式匹配:

match/case中类型推断更智能

- 联合类型简化:

如何开始?

1. 升级Python版本

# 推荐使用 Python 3.10 或更高版本

python --version # 检查版本

2. 渐进式添加类型

- 从关键函数参数和返回值开始

- 无需一次性改造旧代码!

3. 常用类型示例

from typing import Optional, TypedDict

class UserProfile(TypedDict):

name: str

age: Optional[int]

def greet(user: UserProfile) -> None:

print(f"Hello, {user['name']}!")

拥抱改变,代码长青

类型注释不仅是“语法糖”,更是工程实践的进化。切换到 Python 高版本,用类型注释写出更健壮、更易维护的代码,迎接 Python 的强类型新时代!

你目前使用的是Python哪个版本?欢迎留言交流

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

上手 uv 一段时间后,真心觉得这款工具让 Python 项目管理变得省心不少!它不仅操作便捷,安装第三方包的速度更是快得飞起。

不过,在使用过程中也发现了一个小痛点:uv 默认会为每个项目创建独立的虚拟环境。这意味着,如果你同时开发多个项目,即使它们依赖相同的第三方包(比如常用的 requests、pandas),这些包也需要在每个项目的虚拟环境中重复安装。久而久之,宝贵的磁盘空间就这样被悄悄占用了不少。

难道只能忍受这种“甜蜜的负担”吗?当然不是!仔细翻阅 uv 的文档后发现,它其实贴心地提供了工作空间(Workspace)功能!通过工作空间,你可以让多个项目共享同一个虚拟环境。这样一来,公共依赖包只需安装一次,所有关联项目都能顺畅使用,大幅减少了重复安装带来的空间浪费,管理效率再上一个台阶!

在尝试获取 uv 工作空间(Workspace) 功能的相关信息时,小编注意到 DeepSeek 模型提供的回答有时存在不准确或偏离主题的情况。

这表明,uv 这一相对较新的功能细节,可能尚未被充分纳入 DeepSeek 当前模型版本的训练数据。这一现象也提醒我们,即使是强大的 AI 模型,其知识覆盖和能力也存在一定的边界与时效性局限

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.11

uv self version

# uv 0.8.2 (21fadbcc1 2025-07-22)

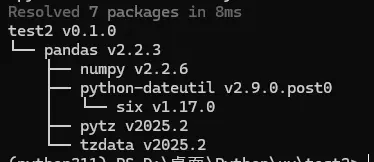

工作空间示例

- 创建根项目,并添加一个三方包

pandas在根项目的文件夹里面生成一个虚拟环境.venv,pandas被安装在该文件夹内

uv init workspace_project -p 3.11

cd workspace_project

uv add pandas

uv tree

workspace-project v0.1.0

└── pandas v2.3.1

├── numpy v2.3.1

├── python-dateutil v2.9.0.post0

│ └── six v1.17.0

├── pytz v2025.2

└── tzdata v2025.2

- 创建子项目1,并添加一个三方包

fastapi在子项目中添加的包,会被安装到根项目的虚拟环境.venv中

pwd # D:\桌面\Python\uv\workspace_project

uv init sub_project1 # 创建子项目1

cd sub_project1

uv add fastapi

uv tree

workspace-project v0.1.0

└── pandas v2.3.1

├── numpy v2.3.1

├── python-dateutil v2.9.0.post0

│ └── six v1.17.0

├── pytz v2025.2

└── tzdata v2025.2

sub-project1 v0.1.0

└── fastapi v0.116.1

├── pydantic v2.11.7

│ ├── annotated-types v0.7.0

│ ├── pydantic-core v2.33.2

│ │ └── typing-extensions v4.14.1

│ ├── typing-extensions v4.14.1

│ └── typing-inspection v0.4.1

│ └── typing-extensions v4.14.1

├── starlette v0.47.2

│ ├── anyio v4.9.0

│ │ ├── idna v3.10

│ │ ├── sniffio v1.3.1

│ │ └── typing-extensions v4.14.1

│ └── typing-extensions v4.14.1

└── typing-extensions v4.14.1

- 创建子项目2,并添加一个三方包

requests

pwd # D:\桌面\Python\uv\workspace_project

uv init sub_project2 # 创建子项目1

cd sub_project2

uv add requests

uv tree

workspace-project v0.1.0

└── pandas v2.3.1

├── numpy v2.3.1

├── python-dateutil v2.9.0.post0

│ └── six v1.17.0

├── pytz v2025.2

└── tzdata v2025.2

sub-project2 v0.1.0

└── requests v2.32.4

├── certifi v2025.7.14

├── charset-normalizer v3.4.2

├── idna v3.10

└── urllib3 v2.5.0

sub-project1 v0.1.0

└── fastapi v0.116.1

├── pydantic v2.11.7

│ ├── annotated-types v0.7.0

│ ├── pydantic-core v2.33.2

│ │ └── typing-extensions v4.14.1

│ ├── typing-extensions v4.14.1

│ └── typing-inspection v0.4.1

│ └── typing-extensions v4.14.1

├── starlette v0.47.2

│ ├── anyio v4.9.0

│ │ ├── idna v3.10

│ │ ├── sniffio v1.3.1

│ │ └── typing-extensions v4.14.1

│ └── typing-extensions v4.14.1

└── typing-extensions v4.14.1

所有的三方包都安装在根项目的虚拟环境内,path\workspace_project\.venv\Lib\site-packages,这样公共依赖包只需安装一次

以上的操作,其实是 uv 自动在根项目的配置文件 pyproject.toml 中,增加了如下配置,这样 uv 才识别所有项目同属于一个工作空间

[tool.uv.workspace]

members = [

"sub_project1",

"sub_project2",

]

- 在子项目2中使用同工作空间其它项目安装的包

import pandas as pd

import fastapi

def main():

print("Hello from sub-project2!")

if __name__ == "__main__":

main()

print('pandas版本:',pd.__version__)

print('fastapi版本:',fastapi.__version__)

运行:

pwd # D:\桌面\Python\uv\workspace_project\sub_project2

uv run .\main.py

# Hello from sub-project2!

# pandas版本: 2.3.1

# fastapi版本: 0.116.1

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

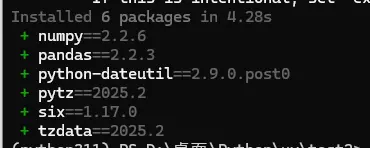

背景

小编最近看公众号里面 uv 文章比较多,于是也尝试着用了一下,整体感觉对于开发项目人员来说很好,方便自动管理项目依赖,后期在部署时,可以根据 uv 自动构建的项目依赖来进行配置,省去各种包冲突麻烦

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.11

安装uv

自己本地已经安装了python,可以直接使用 pip 进行安装

pip install uv -i https://pypi.tuna.tsinghua.edu.cn/simple

uv --version

#uv 0.7.3 (3c413f74b 2025-05-07)

uv各命令

- 初始化项目

初始化项目时,可以指定python版本

uv init test1

uv init test2 -p 3.11

uv init test3 --python 3.11

- 添加依赖

用于安装包并自动更新项目配置文件(pyproject.toml)和锁定文件(uv.lock)

uv add 可以理解为 uv pip install的增强版,底层同样是利用了pip进行安装,但是uv add额外增加了更新项目配置文件的功能

uv add pandas -i https://pypi.tuna.tsinghua.edu.cn/simple

- 删除依赖 也会自动删除pandas依赖的其他包

uv remove pandas

- 显示完整依赖树

uv tree

- uv python 命令

list 列出可用的Python安装版本

install 下载并安装Python版本

find 显示当前Python安装位置

pin 固定使用特定Python版本

dir 显示uv Python安装目录

uninstall 卸载Python版本

- uv 升级,自己升级

uv self update

- 设置全局默认python版本

uv python pin --global 3.11

- 安装python版本

uv python install 3.13

- 显示已安装的 Python 版本路径

uv python dir

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

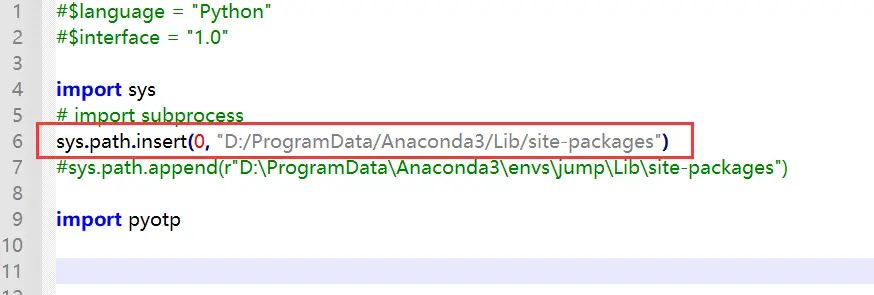

在公司内部的服务器中,安装三方库是需要经过层层审批,最后由运维人员进行安装,员工一般是没有权限去随意安装三方库,在审批之前需要进行测试验证可行性,那么这时就需要把三方库安装到自己有权限的目录中,然后再进行使用。小编这里经过亲身测试验证,分享出来供大家参考学习

指定文件夹下安装三方库

在python中安装三方库,默认使用 pip 命令进行安装,在该命令中可以通过 target 指定安装到的文件夹位置

pip3 install pyspark==2.4.3 \

--target=/mnt/disk1/datashare/python \

-i https://mirrors.aliyun.com/pypi/simple/ #指定阿里源

加载指定文件夹下安装的三方库

在安装三方库时是安装在指定文件夹下,所以需要把指定文件夹插入到 sys.path 的第1个位置,否则会加载系统自带的版本

import sys

lib_path = "/mnt/disk1/datashare/python"

sys.path.insert(0,lib_path) #插入安装三方库的文件夹

import pyspark

print(pyspark.__version__)

#2.4.3

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多 日期:2026年2月4日

背景

装饰器是Python中一种强大的语法糖,它允许我们在不修改原函数代码的情况下,为函数添加额外的功能。装饰器本质上是一个可调用对象,它接受一个函数作为输入,并返回一个新的函数。装饰器的使用方式非常灵活,既可以不带参数使用,也可以带参数使用

小编环境

import sys

print('python 版本:',sys.version.split('|')[0])

#python 版本: 3.11.11

函数装饰器实现

我们先来看一个简单的函数装饰器实现:

import time

def delayed_start(func=None, *, duration=1):

def decorator(_func):

def wrapper(*args, **kwargs):

print(f"Wait for {duration} seconds before starting...")

time.sleep(duration)

return _func(*args, **kwargs)

return wrapper

if func is None:

return decorator

else:

return decorator(func)

这个装饰器可以以两种方式使用:

- 不带参数使用:当装饰器不带参数使用时,Python会直接将装饰的函数作为参数传递给

delayed_start

@delayed_start

def hello_no_arg(name="datashare"):

print("from hello_no_arg, param name =", name)

等价于:

hello_no_arg = delayed_start(hello_no_arg)

- 带参数使用:当装饰器带参数使用时,Python会先调用装饰器函数,返回一个真正的装饰器,然后再用这个装饰器装饰函数

@delayed_start(duration=2)

def hello_with_arg(name="datashare"):

print("from hello_with_arg, param name =", name)

等价于:

hello_with_arg = delayed_start(duration=2)(hello_with_arg)

实现原理

delayed_start函数的巧妙之处在于它通过检查 func参数是否为 None来判断装饰器的使用方式:

- 如果

func不是None,说明是不带参数使用,直接返回decorator(func) - 如果

func是None,说明是带参数使用,返回decorator函数等待接收真正的函数参数

类装饰器实现

类装饰器通过实现 __call__方法来实现装饰器的功能。下面是带参数和不带参数的类装饰器实现:

from functools import wraps

import time

class Timer:

def __init__(self, func=None, *, print_args=False):

self.func = func

self.print_args = print_args

def __call__(self, *args, **kwargs):

# 情况 1:@Timer(print_args=True)

# 第一次 __call__,args[0] 是函数

if self.func is None:

func = args[0]

return self._decorate(func)

# 情况 2:@Timer

# 或者已经绑定好函数,真正执行

return self._decorate(self.func)(*args, **kwargs)

def _decorate(self, func):

@wraps(func)

def wrapper(*args, **kwargs):

st = time.perf_counter()

ret = func(*args, **kwargs)

if self.print_args:

print(f'"{func.__name__}", args: {args}, kwargs: {kwargs}')

print(f"time cost: {time.perf_counter() - st:.4f} seconds")

return ret

return wrapper

- 不带参数使用:

@Timer

def compute(x):

time.sleep(1)

return x * 2

当类装饰器不带参数使用时,Python会创建 Timer类的实例,并将 compute函数传递给 __init__方法。此时 self.func就是 compute函数。当我们调用 compute(10)时,实际上是调用 Timer实例的 __call__方法

- 带参数使用:

@Timer(print_args=True)

def compute2(x):

time.sleep(1)

return x * 3

当类装饰器带参数使用时,Python会先调用 Timer(print_args=True)创建实例,此时 self.func为 None。然后用这个实例去装饰 compute2函数,这相当于调用 Timer实例的 __call__方法,并将 compute2作为参数传入

两种实现方式的比较

| 特性 | 函数装饰器 | 类装饰器 |

|---|---|---|

| 代码简洁性 | 更简洁,适合简单的装饰逻辑 | 更复杂,但结构更清晰 |

| 状态管理 | 需要使用闭包或nonlocal变量 | 可以使用实例属性,更直观 |

| 可扩展性 | 适合简单的装饰功能 | 适合需要维护状态的复杂装饰器 |

| 可读性 | 对于简单场景更易读 | 对于复杂场景更易维护 |

实际应用场景

- 性能监控:如

Timer装饰器,用于测量函数执行时间 - 权限验证:检查用户是否有权限执行某个函数

- 日志记录:自动记录函数的调用和参数

- 缓存:实现函数结果的缓存,提高性能

- 重试机制:当函数执行失败时自动重试

最佳实践

- 使用

functools.wraps装饰器来保留原函数的元数据(如函数名、文档字符串等) - 对于简单的装饰器,优先使用函数装饰器

- 对于需要维护状态的装饰器,考虑使用类装饰器

- 在设计带参数的装饰器时,确保同时支持带参数和不带参数的使用方式

总结

Python装饰器是一个强大而灵活的特性,它允许我们以非侵入式的方式增强函数的功能。通过掌握函数装饰器和类装饰器的实现方式,以及如何实现带参数和不带参数的装饰器,我们可以编写出更加通用和可重用的代码。无论是简单的函数增强还是复杂的状态管理,装饰器都能提供优雅的解决方案

理解装饰器的工作原理不仅有助于我们编写更好的装饰器,还能加深我们对Python函数式编程和元编程的理解,是成为高级Python开发者的重要一步

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

背景

懂编程语言最开始是属于程序猿的世界,现在随着国内人们受教育程度的提升、互联网科技的发展,业务人员也开始慢慢需要懂编程语言。从最近几年的招聘需求看,要求会Python则成为刚需。

业务人员之前使用的大部分都是Excel,现在随着数据量的提升,Excel已无法满足数据处理需求。如果在Excel里面数据量超过10万行,则Excel运行起来就相当卡顿。

下面展示一些在Excel里面常用的功能,看看其在Python里面具体是怎么实现的,Python处理数据用到的主要是pandas库,这也是《利用python进行数据分析》整本书介绍的对象。

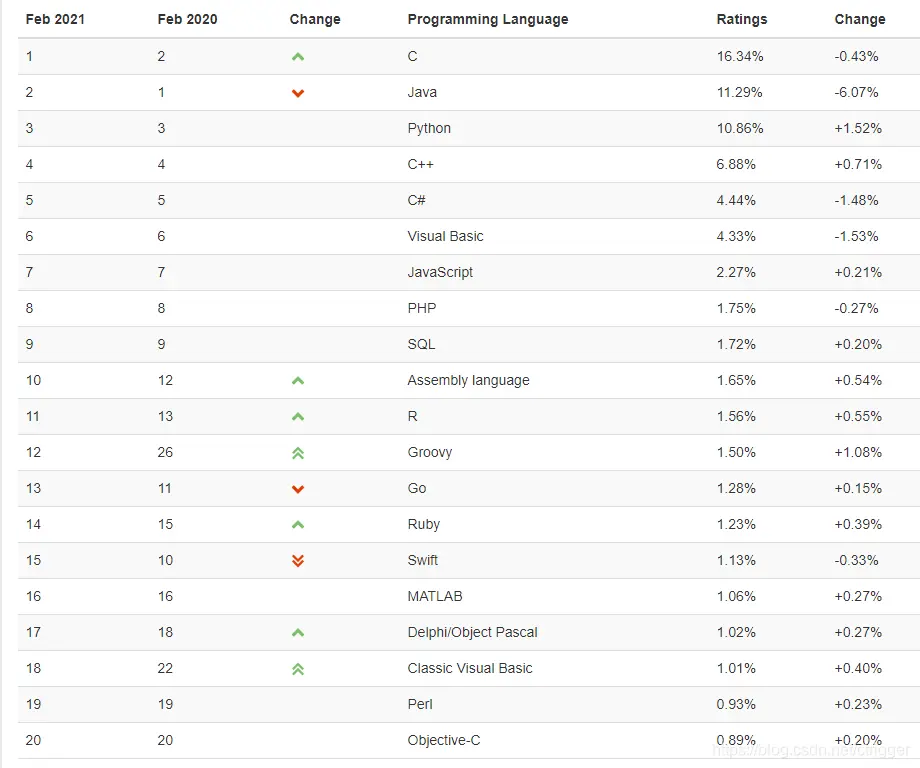

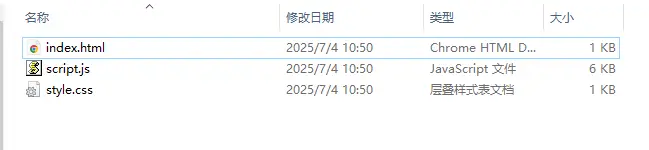

如下所示为2021年2月编程语言排行榜:

从排行榜来看,python越来越吃香了

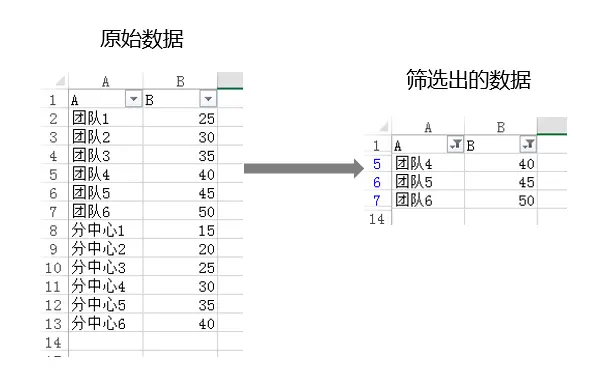

案例

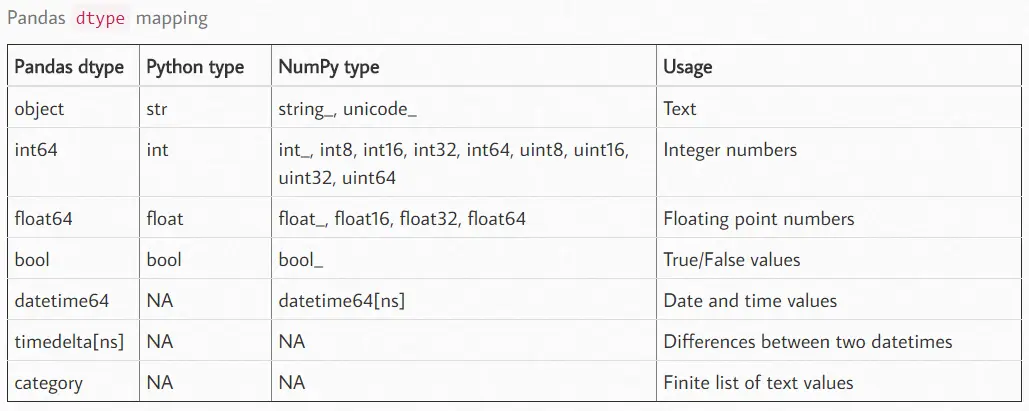

这里只是展示方法,用到数据只有15行

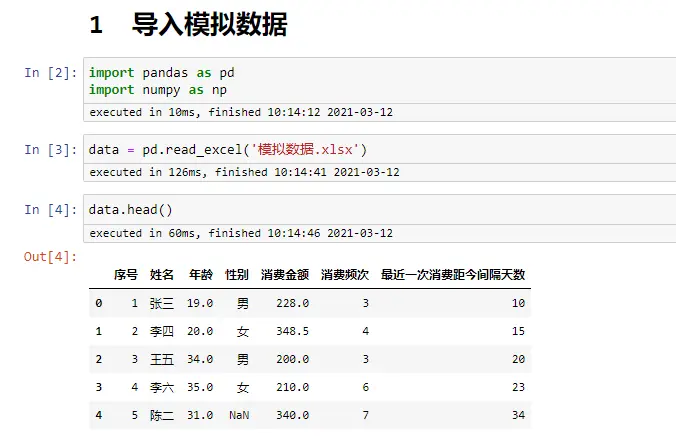

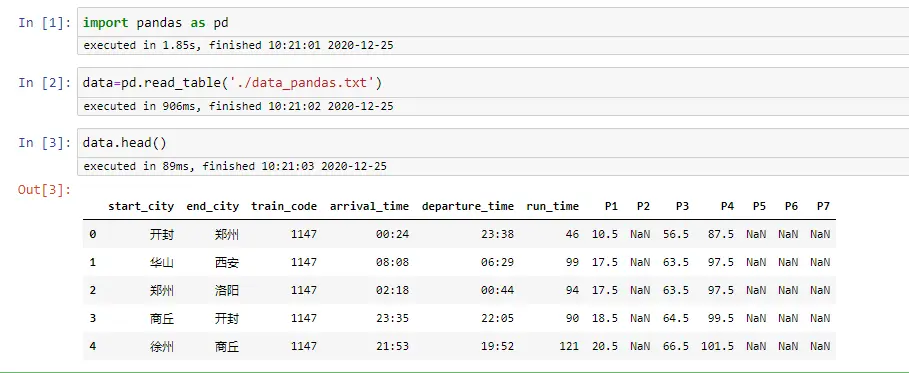

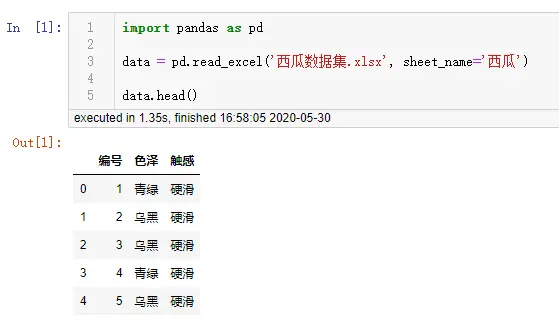

导入模拟数据

import pandas as pd

import numpy as np

data = pd.read_excel('模拟数据.xlsx')

data.head()

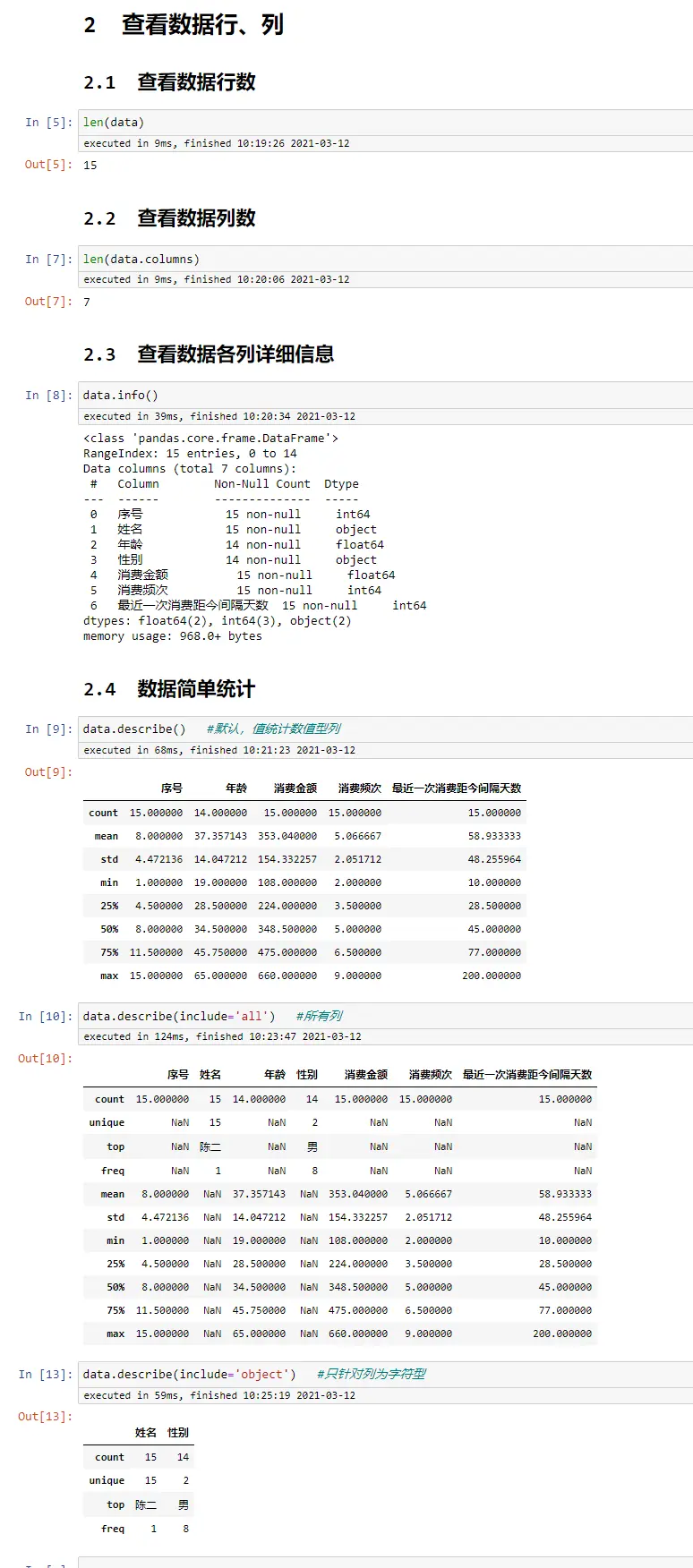

查看数据行、列

len(data) #数据行数

len(data.columns) #数据列数

data.info() #数据各列详细信息

data.describe() #默认,值统计数值型列

data.describe(include='all') #所有列

data.describe(include='object') #只针对列为字符型

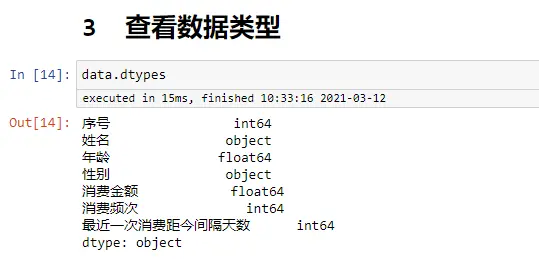

查看数据类型

data.dtypes

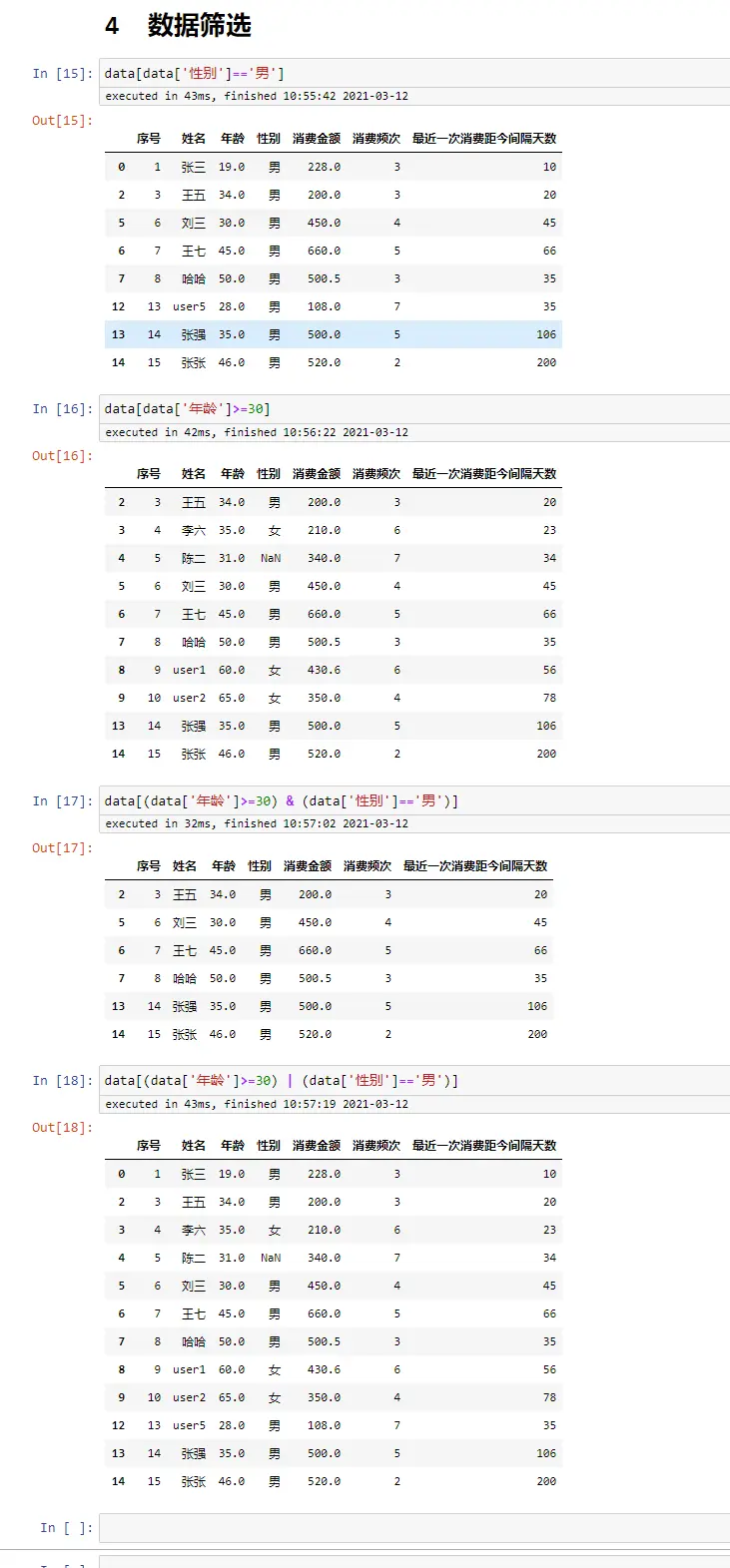

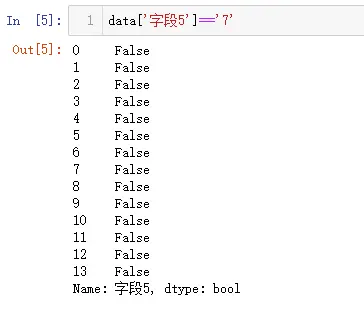

数据筛选

data[data['性别']=='男']

data[data['年龄']>=30]

data[(data['年龄']>=30) & (data['性别']=='男')] #两个条件 与

data[(data['年龄']>=30) | (data['性别']=='男')] #两个条件 或

基于筛选,修改里面的数据

data.loc[data['姓名']=='张三','性别']='女' #把张三 性别 修改为:女

data

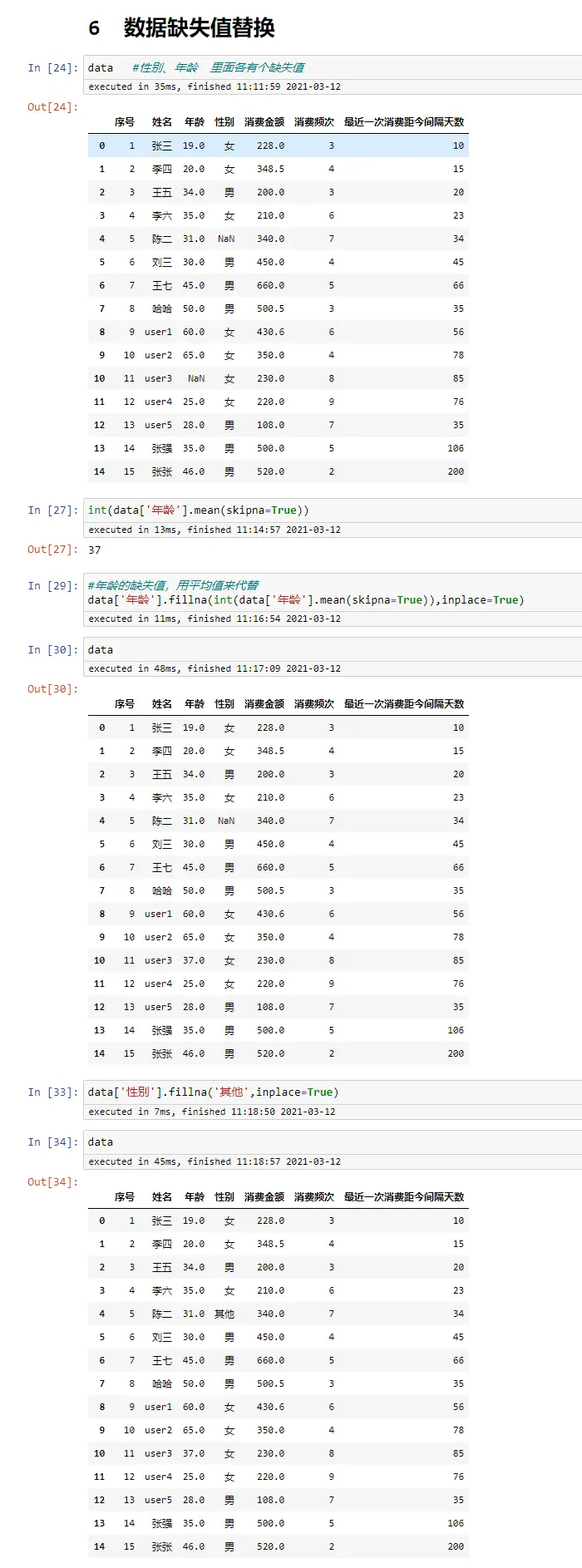

数据缺失值替换

data #性别、年龄 里面各有个缺失值

int(data['年龄'].mean(skipna=True))

#年龄的缺失值,用平均值来代替

data['年龄'].fillna(int(data['年龄'].mean(skipna=True)),inplace=True)

data

data['性别'].fillna('其他',inplace=True)

data

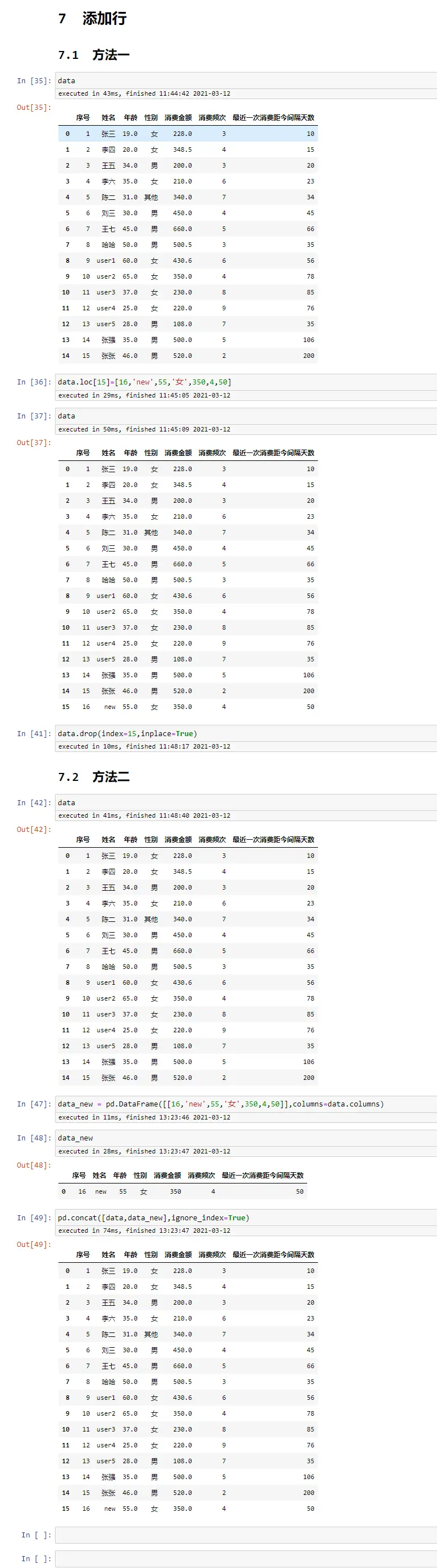

添加行

#方法一

data.loc[15]=[16,'new',55,'女',350,4,50]

data

#方法二

data_new = pd.DataFrame([[16,'new',55,'女',350,4,50]],columns=data.columns)

pd.concat([data,data_new],ignore_index=True)

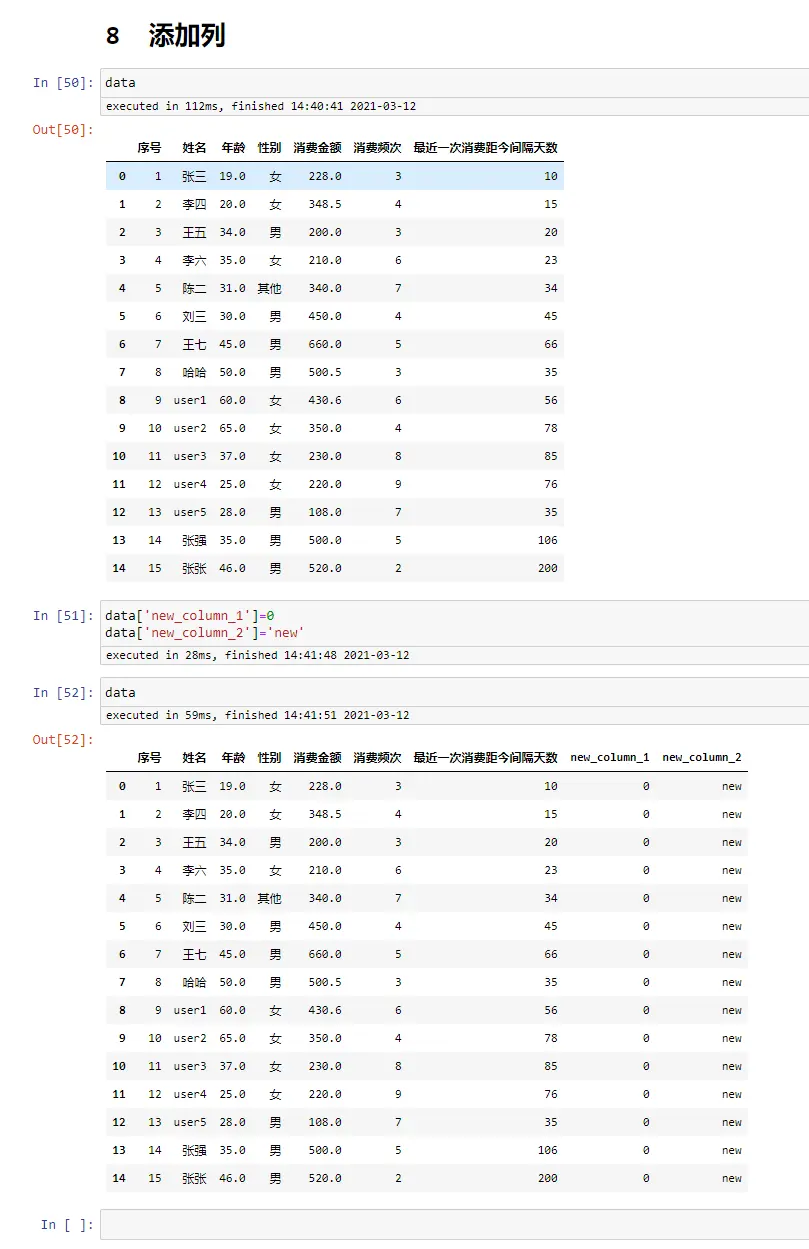

添加列

添加列相对比较简单,直接赋值即可

data['new_column_1']=0

data['new_column_2']='new'

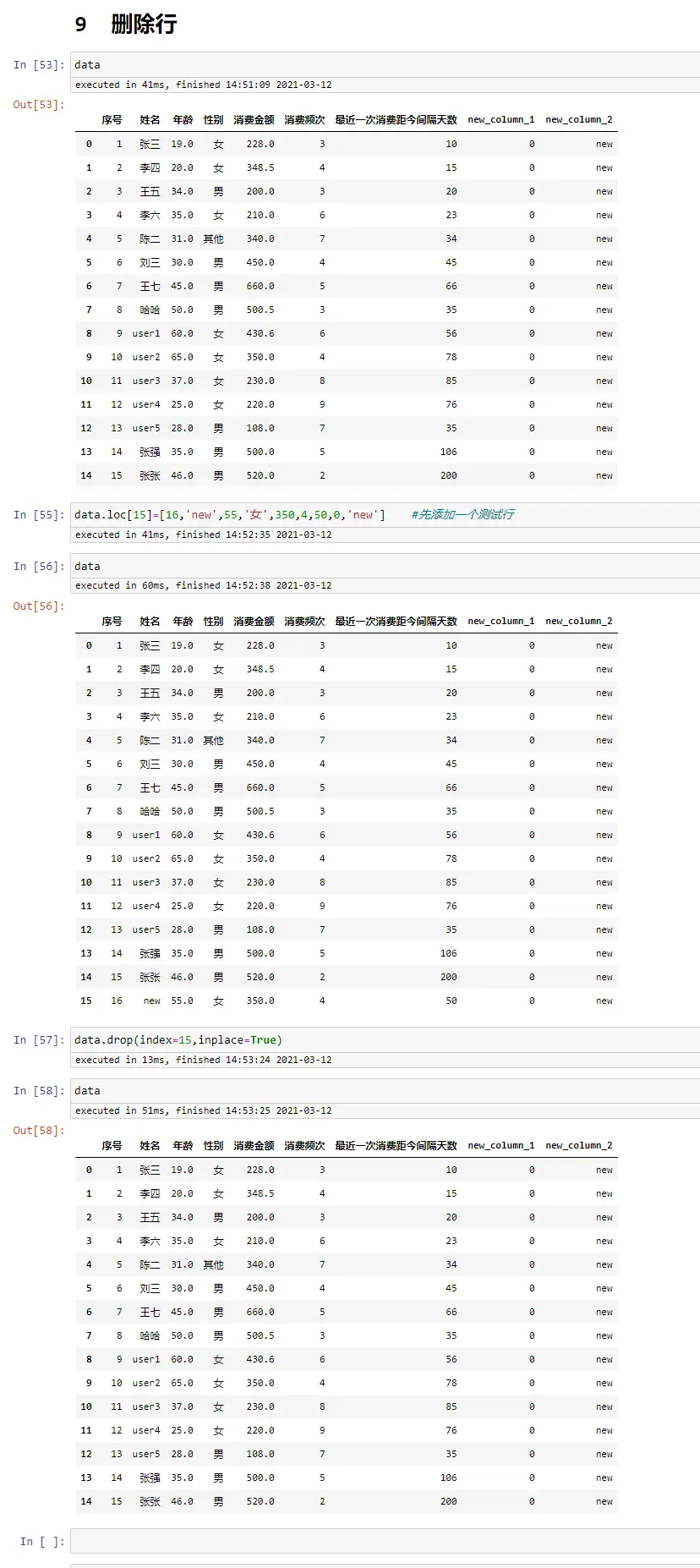

删除行

data.loc[15]=[16,'new',55,'女',350,4,50,0,'new'] #先添加一个测试行

data

data.drop(index=15,inplace=True) #删除行

data

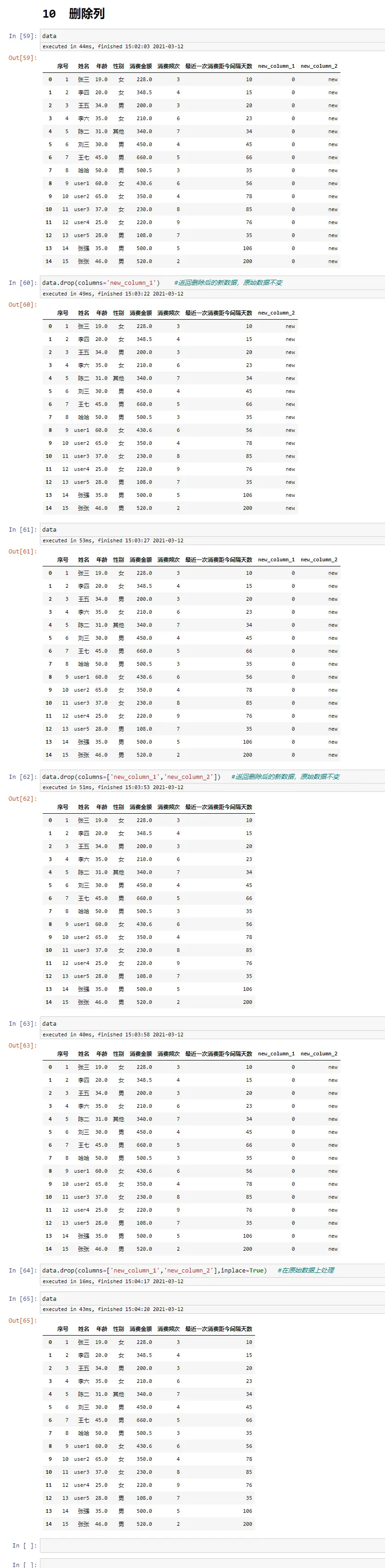

删除列

data.drop(columns='new_column_1') #返回删除后的新数据,原始数据不变

data.drop(columns=['new_column_1','new_column_2']) #返回删除后的新数据,原始数据不变

data.drop(columns=['new_column_1','new_column_2'],inplace=True) #在原始数据上处理

data

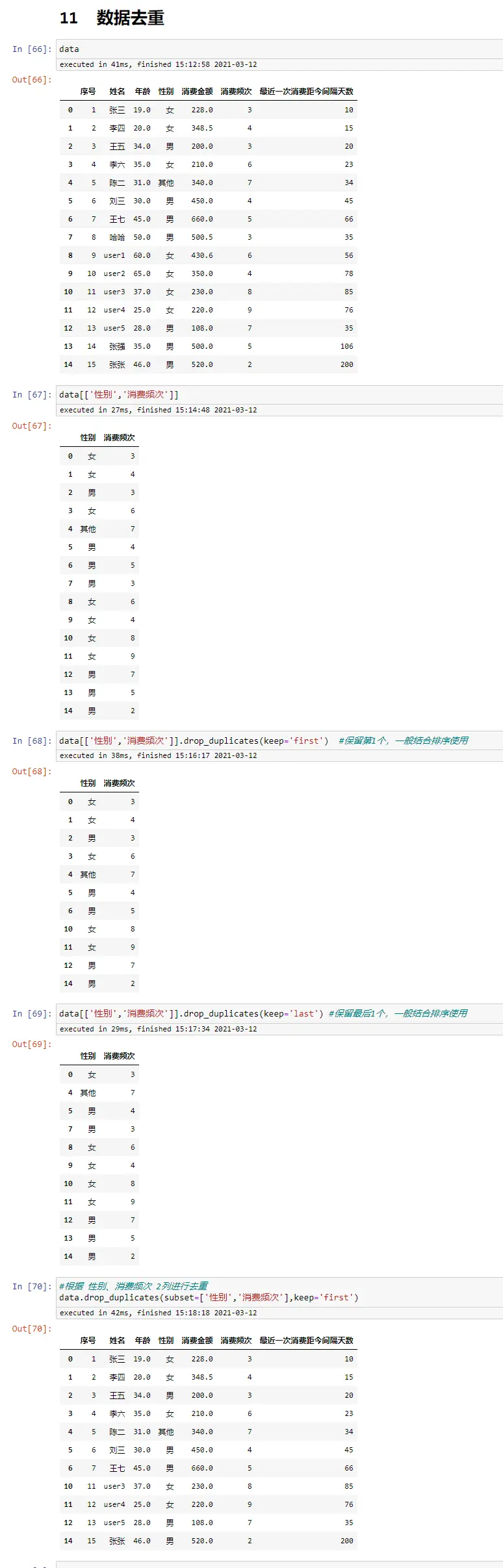

数据去重

data

data[['性别','消费频次']]

data[['性别','消费频次']].drop_duplicates(keep='first') #保留第1个,一般结合排序使用

data[['性别','消费频次']].drop_duplicates(keep='last') #保留最后1个,一般结合排序使用

#根据 性别、消费频次 2列进行去重

data.drop_duplicates(subset=['性别','消费频次'],keep='first')

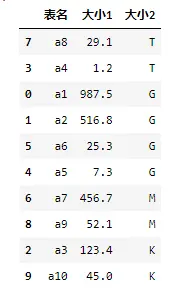

数据排序

相对Excel方便很多

data

data.sort_values(by='消费金额',ascending=True)

data.sort_values(by='消费金额',ascending=False)

data.sort_values(by=['消费频次','消费金额'],ascending=[False,True])

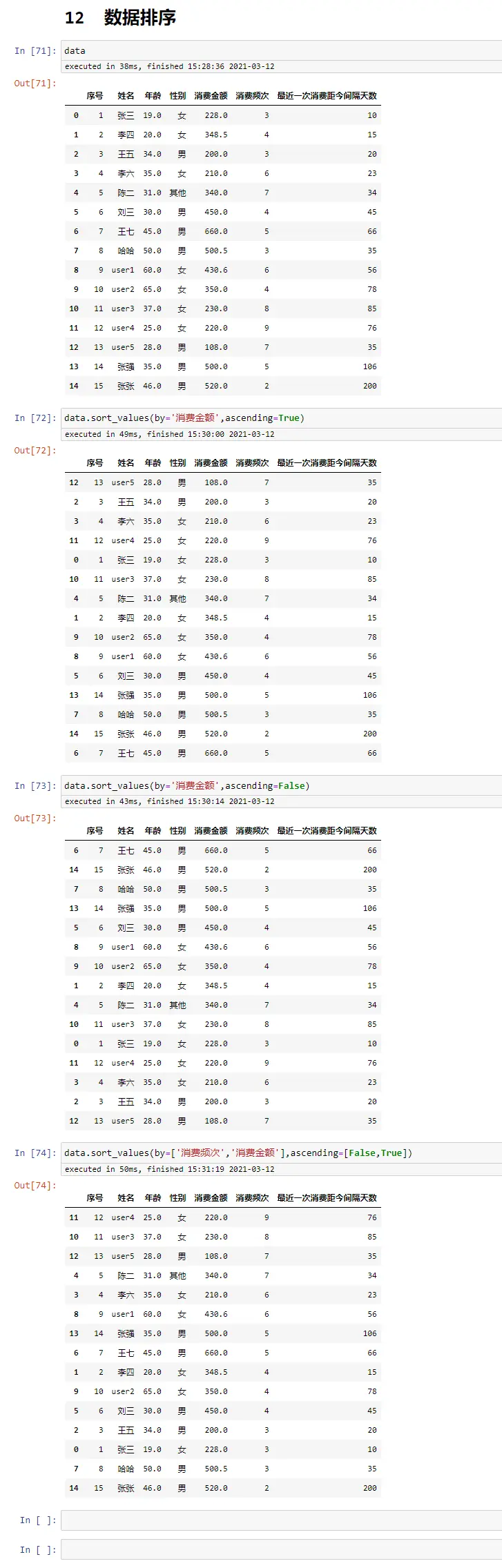

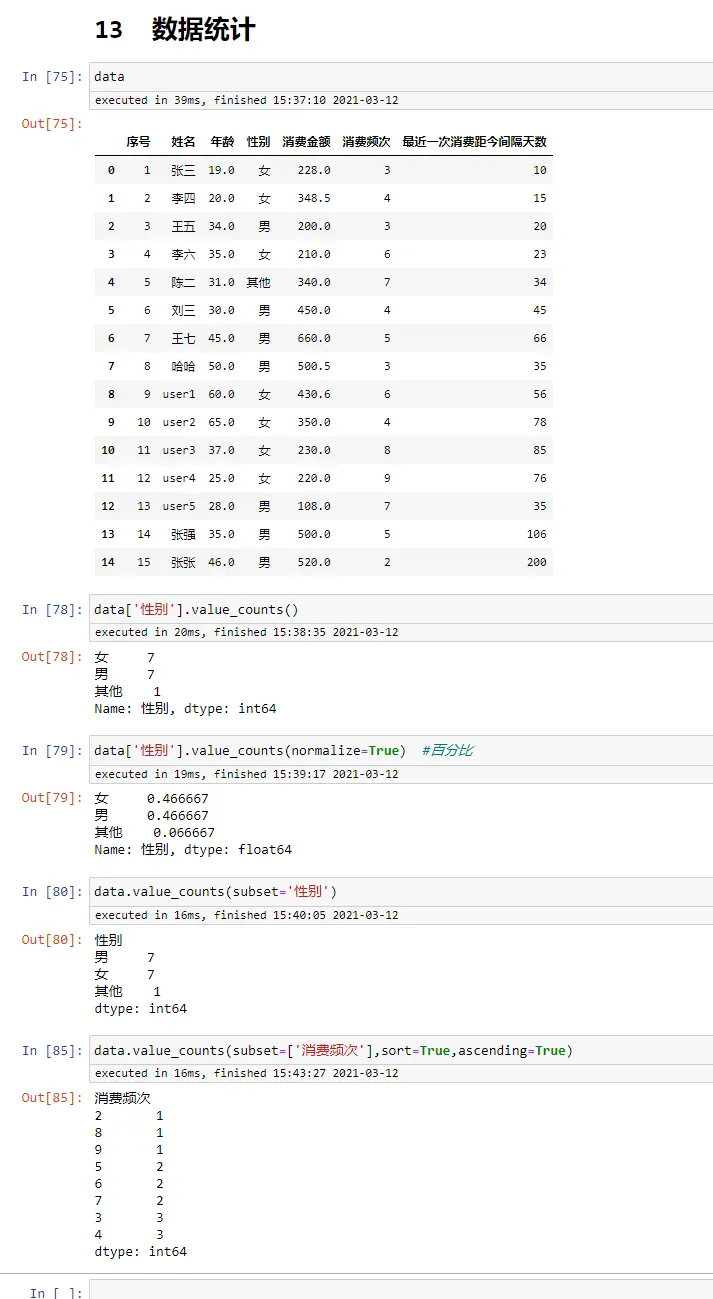

数据统计

data

data['性别'].value_counts()

data['性别'].value_counts(normalize=True) #百分比

data.value_counts(subset='性别')

data.value_counts(subset=['消费频次'],sort=True,ascending=True)

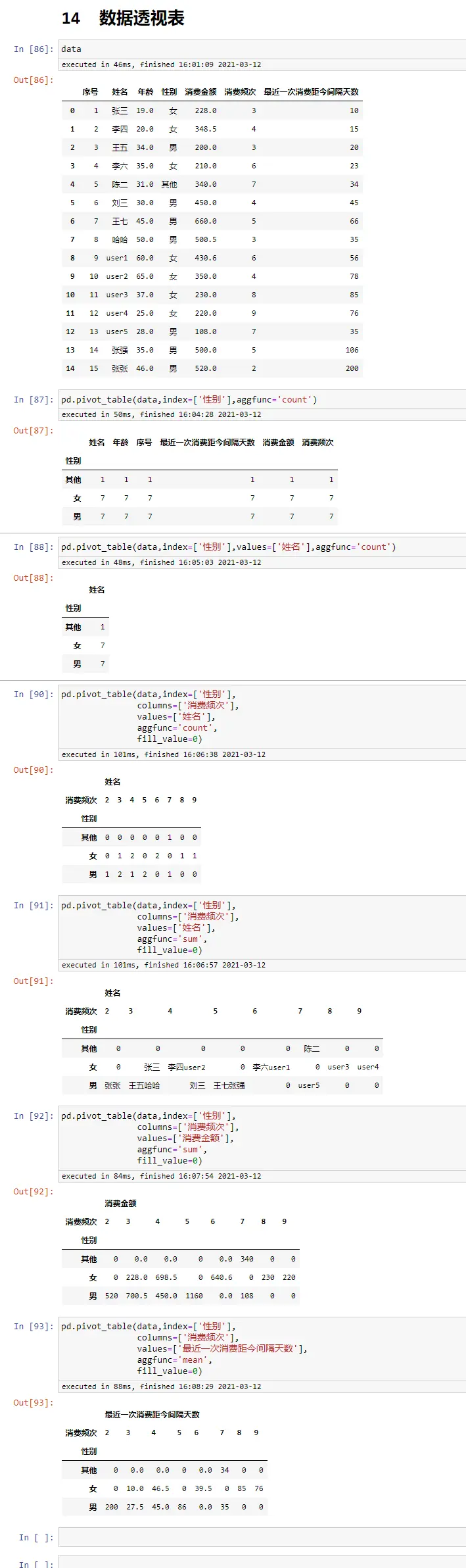

数据透视表

data

pd.pivot_table(data,index=['性别'],aggfunc='count')

pd.pivot_table(data,index=['性别'],values=['姓名'],aggfunc='count')

pd.pivot_table(data,index=['性别'],

columns=['消费频次'],

values=['姓名'],

aggfunc='count',

fill_value=0)

pd.pivot_table(data,index=['性别'],

columns=['消费频次'],

values=['姓名'],

aggfunc='sum',

fill_value=0)

pd.pivot_table(data,index=['性别'],

columns=['消费频次'],

values=['消费金额'],

aggfunc='sum',

fill_value=0)

pd.pivot_table(data,index=['性别'],

columns=['消费频次'],

values=['最近一次消费距今间隔天数'],

aggfunc='mean',

fill_value=0)

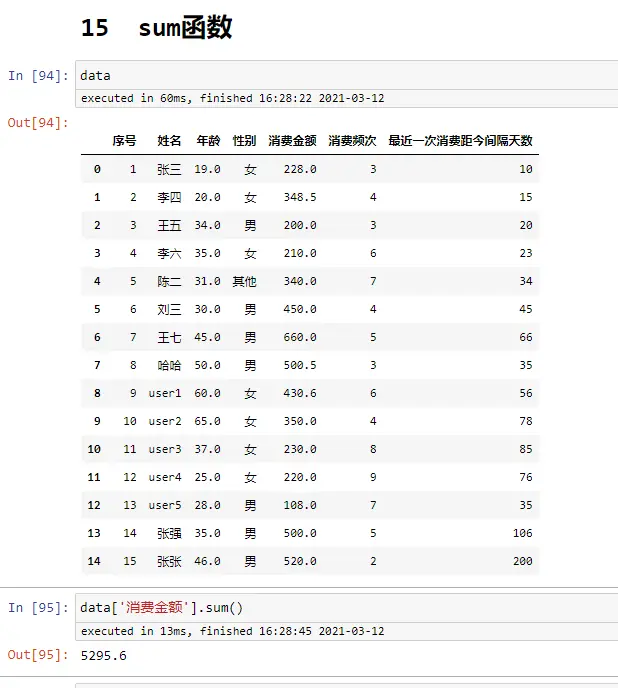

sum函数

data

data['消费金额'].sum()

count函数

data

data.count()

data['姓名'].count()

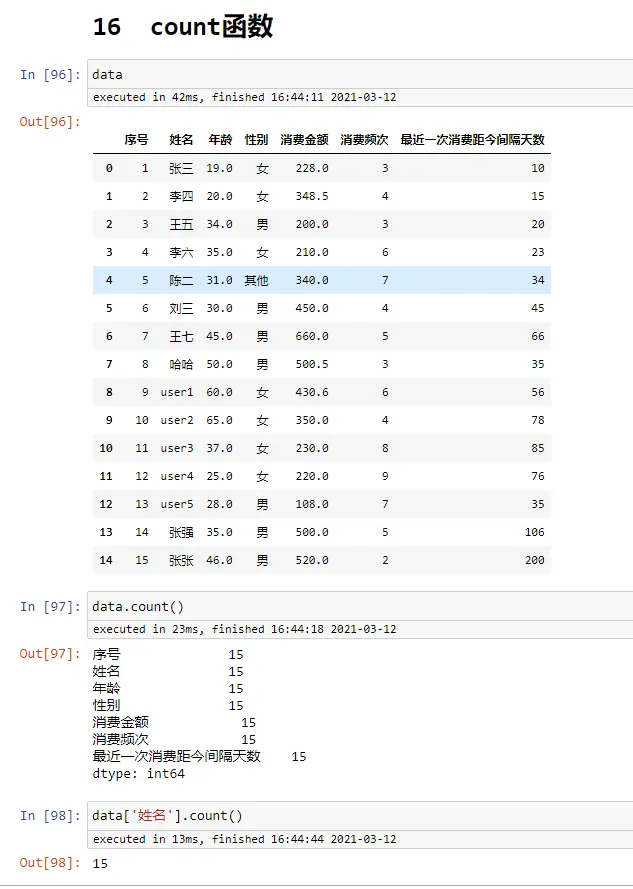

if函数

data

#方法一

data['性别_处理']=data['性别'].map(lambda x:1 if x=='男' else 0)

#方法二

def gender(x):

if x=='男':

return 1

else:

return 0

data['性别_处理2']=data['性别'].map(gender)

#方法三

dict_gender={'男':1,'女':0 ,'其他':0}

data['性别_处理3']=data['性别'].map(dict_gender)

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

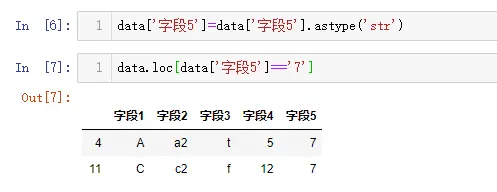

背景

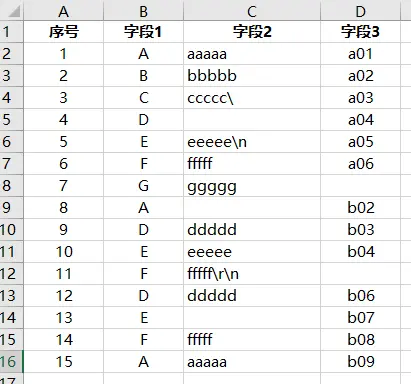

在数据分析时,有时我们会碰到csv格式文件,需要先进行数据处理,转换成所需要的数据格式,然后才能进行分析

业务侧的同学可能对Excel文件比较熟悉,Excel可以把单个sheet直接保存为csv文件,也可以直接读取csv文件,变成Excel文件

技术侧的同学有时需要把数据库里面的数据导出到一个csv文件,有时也需要把别人给的csv文件加载到数据库中

csv文件在各个地方都这么流行,你真的彻底了解它吗?

CSV(逗号分隔值文件格式),逗号分隔值(Comma-Separated Values,CSV,有时也称为字符分隔值,因为分隔字符也可以不是逗号)

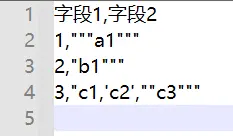

csv文件包含的各种数据

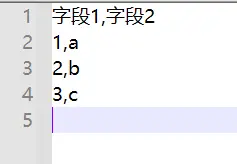

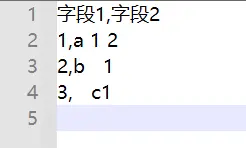

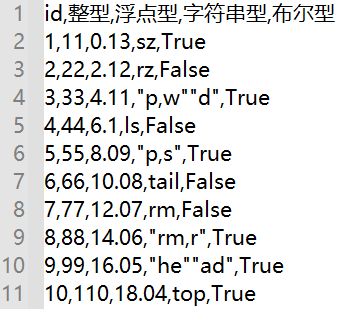

-

常规的内容

表格中:

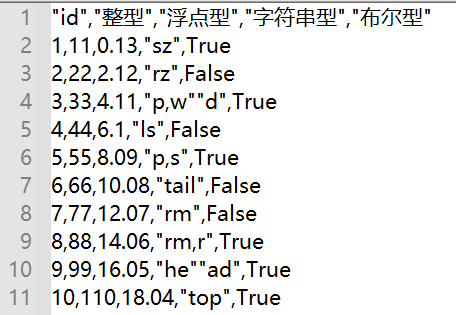

csv文件中:

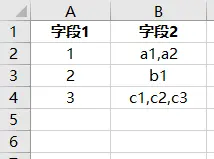

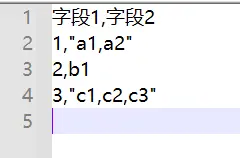

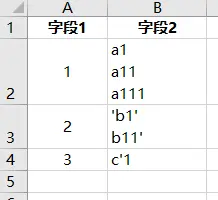

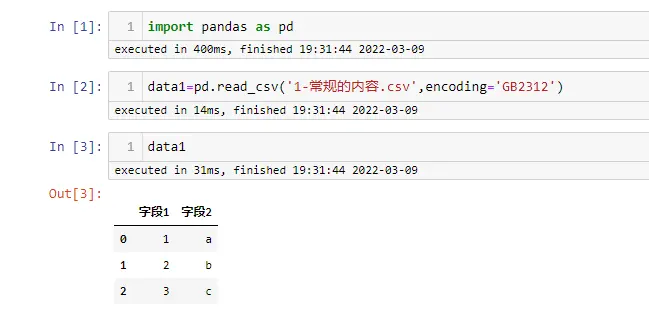

-

字段内部有逗号

表格中:

csv文件中:

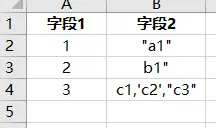

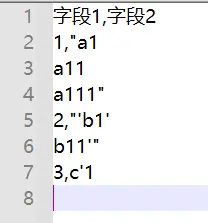

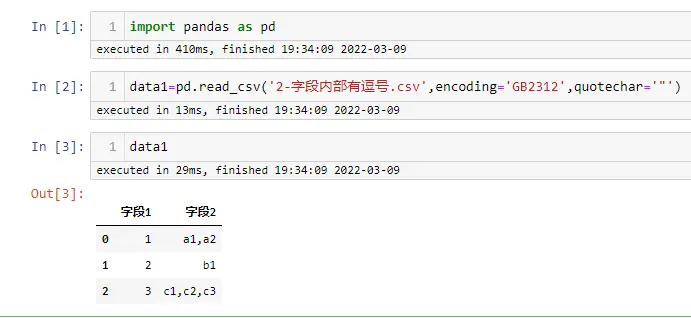

-

字段内部有引号

表格中:

csv文件中:

-

字段内部有换行符

表格中:

csv文件中:

-

字段内部有空格

表格中:

csv文件中:

csv文件规则

从上面的各种内容可以看出,当字段中包含特殊的字符时,在csv文件中会用双引号进行特殊处理

官方标准:

RFC4180:https://www.rfc-editor.org/rfc/rfc4180.txt

维基百科wiki:https://wiki.lazarus.freepascal.org/CSV

- 字段内包含逗号, 双引号, 或是换行符的字段必须放在双引号内

- 字段内包含引号必须在其前面增加一个引号,来实现引号的转码

- 元素中的换行符将被保留下来

- 分隔符逗号前后的空格仍然会被保留

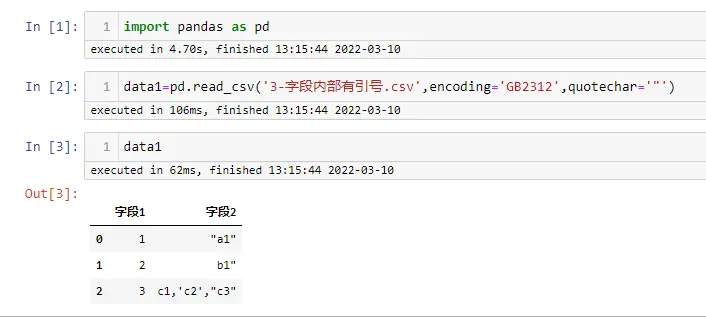

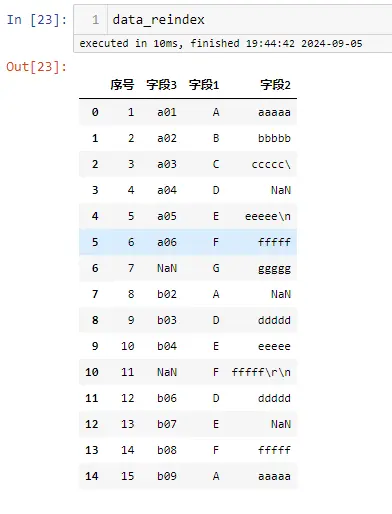

用pandas进行解析

- 常规的内容

import pandas as pd

data1=pd.read_csv('1-常规的内容.csv',encoding='GB2312')

data1

- 字段内部有逗号

import pandas as pd

data1=pd.read_csv('2-字段内部有逗号.csv',encoding='GB2312',quotechar='"')

data1

- 字段内部有引号

import pandas as pd

data1=pd.read_csv('3-字段内部有引号.csv',encoding='GB2312',quotechar='"')

data1

- 字段内部有换行符

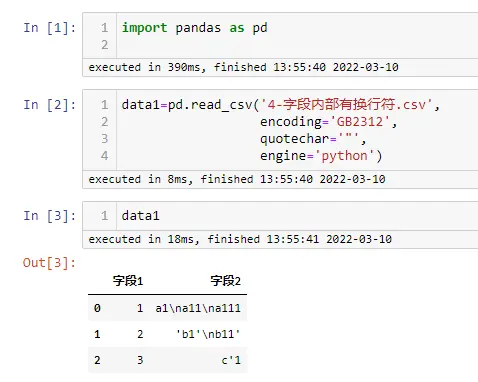

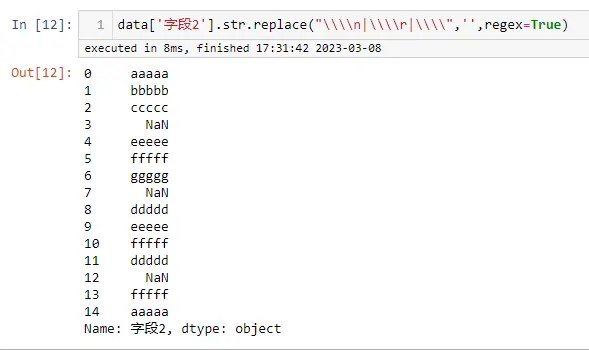

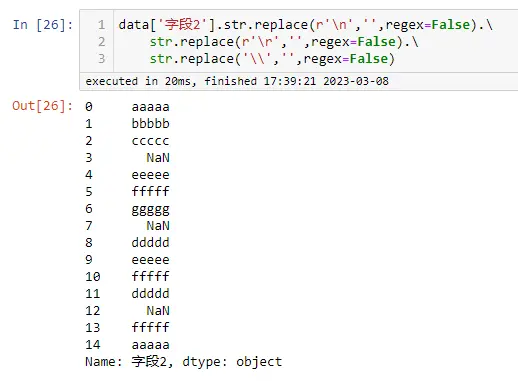

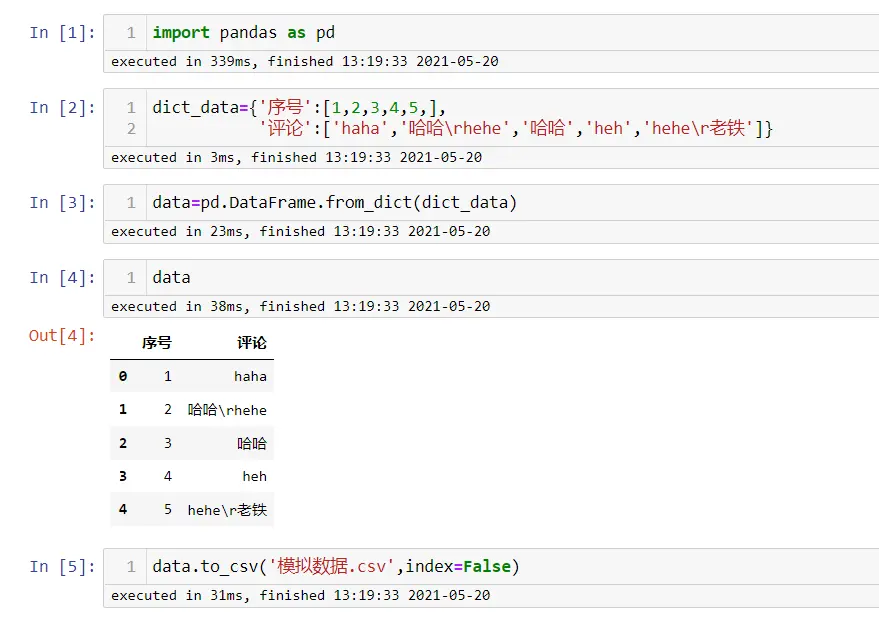

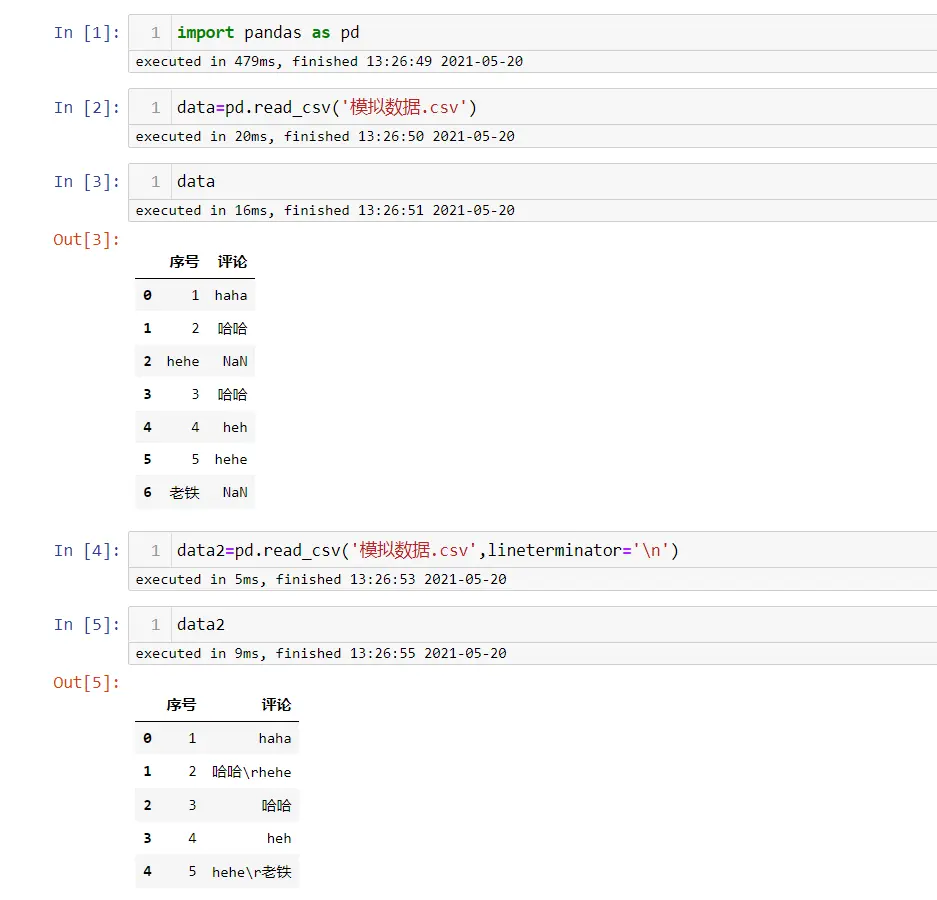

该程序是在 Windows 平台运行,换行符为

\r\n

import pandas as pd

data1=pd.read_csv('4-字段内部有换行符.csv',

encoding='GB2312',

quotechar='"',

engine='python')

data1

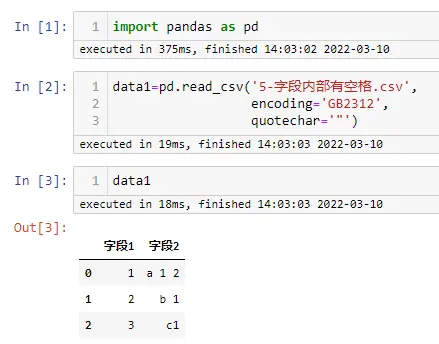

- 字段内部有空格

import pandas as pd

data1=pd.read_csv('5-字段内部有空格.csv',

encoding='GB2312',

quotechar='"')

data1

pd.read_csv部分参数解释

import pandas as pd

print(pd.__version__) #1.3.4

完整的参数:

pd.read_csv(

filepath_or_buffer: 'FilePathOrBuffer',

sep=<no_default>,delimiter=None,header='infer',names=<no_default>,

index_col=None,usecols=None,squeeze=False,prefix=<no_default>,

mangle_dupe_cols=True,dtype: 'DtypeArg | None' = None,

engine=None,converters=None,true_values=None,

false_values=None,skipinitialspace=False,skiprows=None,

skipfooter=0,nrows=None,na_values=None,keep_default_na=True,

na_filter=True,verbose=False,skip_blank_lines=True,

parse_dates=False,infer_datetime_format=False,keep_date_col=False,

date_parser=None,dayfirst=False,cache_dates=True,iterator=False,

chunksize=None,compression='infer',thousands=None,

decimal: 'str' = '.',lineterminator=None,quotechar='"',

quoting=0,doublequote=True,escapechar=None,

comment=None,encoding=None,encoding_errors: 'str | None' = 'strict',

dialect=None,error_bad_lines=None,warn_bad_lines=None,

on_bad_lines=None,delim_whitespace=False,low_memory=True,

memory_map=False,float_precision=None,storage_options: 'StorageOptions' = None,

)

下面主要解释一些常用的参数:

-

sep

sep参数是字符型的,代表每行数据内容的分隔符号,默认是逗号,另外常见的还有制表符(\t)、空格等,根据数据的实际情况传值 还提供了一个参数名为delimiter的定界符,这是一个备选分隔符,是sep的别名,效果和sep一样。如果指定该参数,则sep参数失效 -

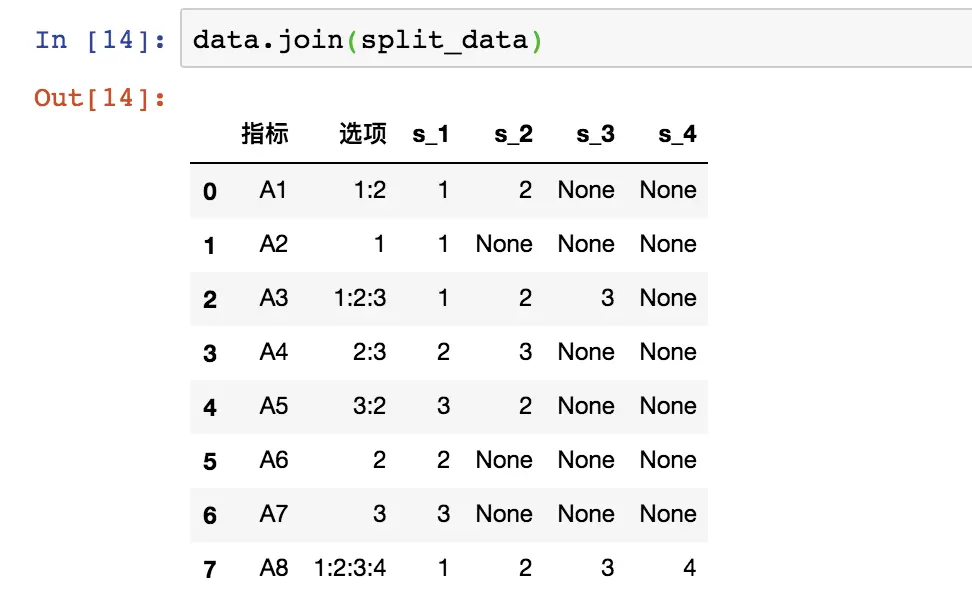

dtype

指定各数据列的数据类型,建议在导入数据时全部使用字符型,dtype='str',后面在数据处理时再转换为需要的类型 -

engine

解析器、引擎,可以选择C或Python。 C语言的速度最快,Python语言的功能最为完善 -

iterator

是否设置为迭代器,如果设置为True,则返回一个TextFileReader对象,并可以对它进行迭代,以便逐块处理文件,一般结合chunksize使用,指定文件块的大小,分块处理大型CSV文件 -

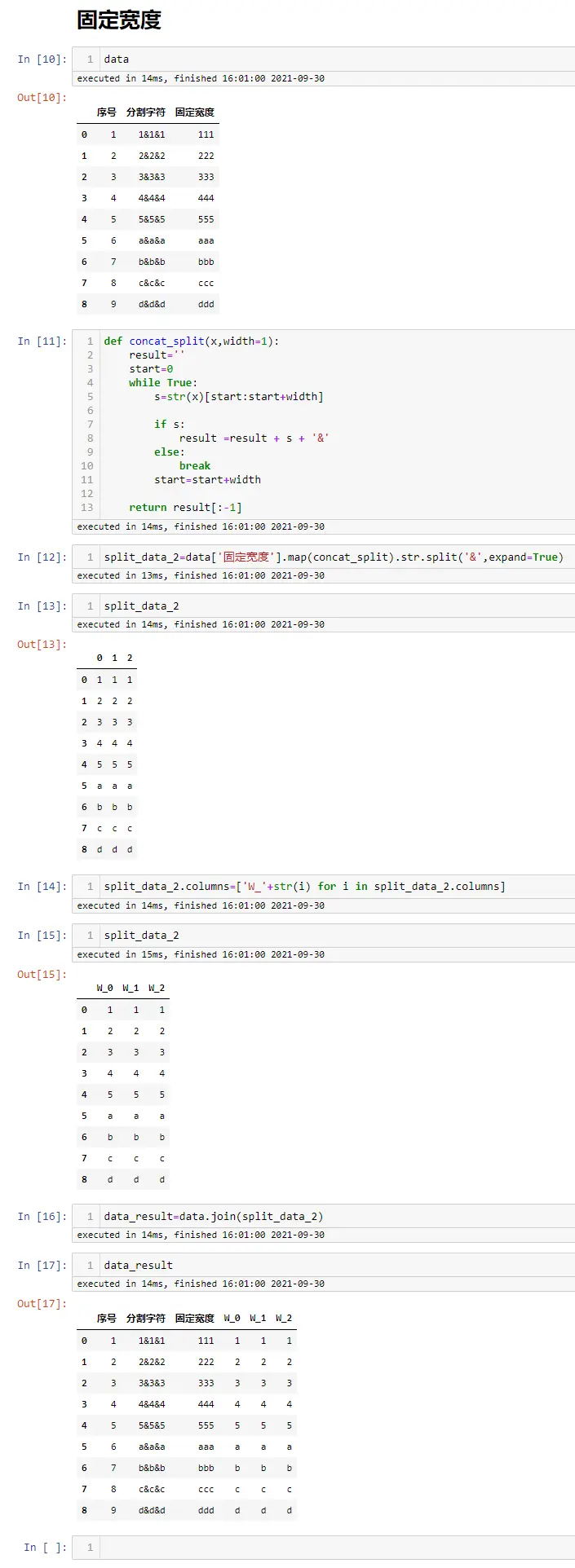

lineterminator

每行的解释符号,但只能允许一个字符长度,仅对C解析器有效 -

quotechar

字段之间的定界符,这样就能正确解析包含特殊符号的字段了

历史相关文章

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

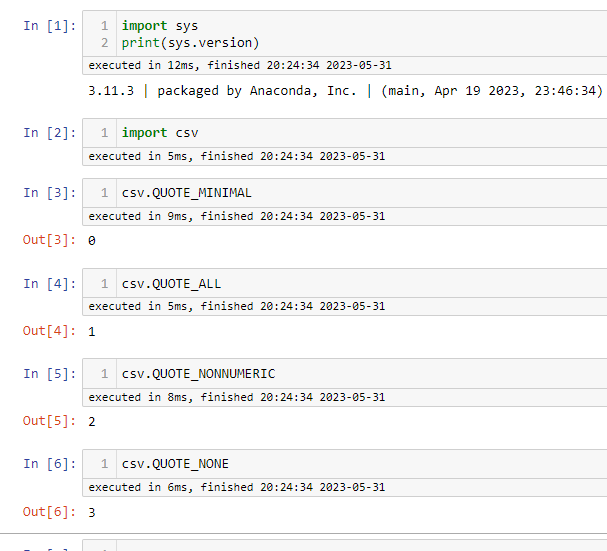

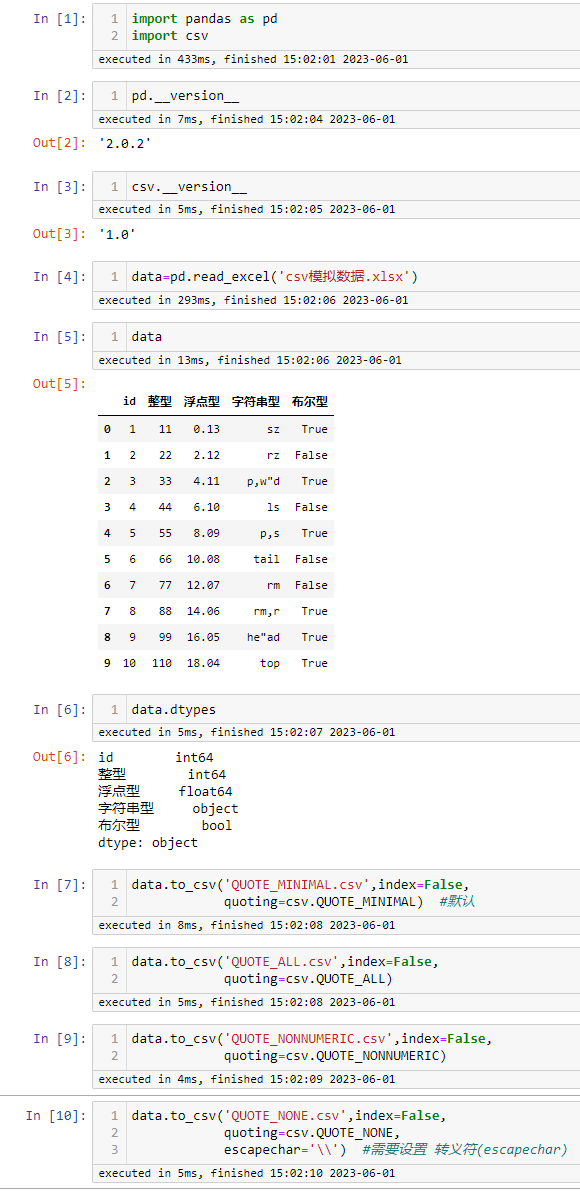

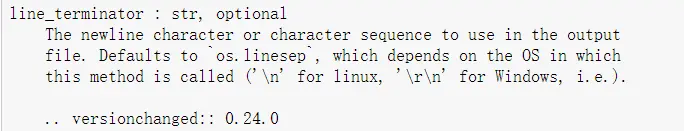

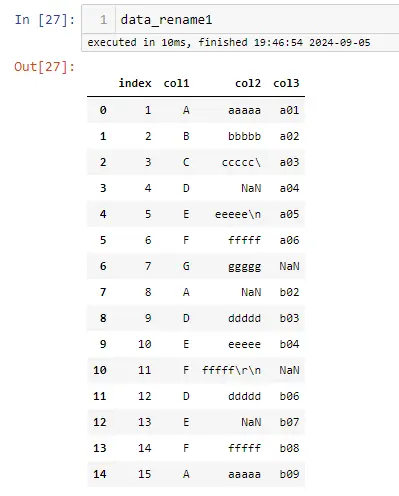

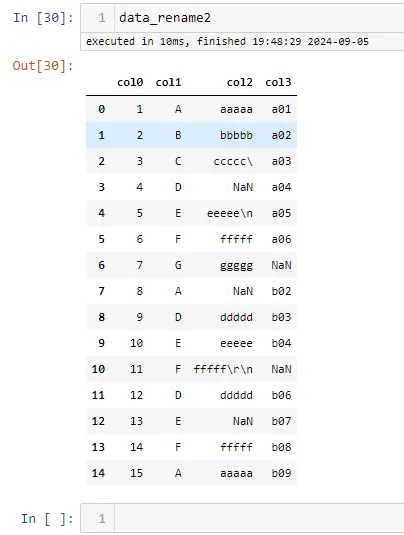

背景

最近在做数据处理时,发现别人给的 csv 文件用 txt 打开后,发现里面的所有字段都是带双引号,与自己之前见过的 csv 文件有点不一样,自己脑海里面隐约也见过 python 有相关的设置参数,于是就查看 python 官方文档中的 csv 模块介绍,总结分享出来予以记录,方便后续查看

csv文档地址:https://docs.python.org/zh-cn/3.11/library/csv.html

csv代码:https://github.com/python/cpython/blob/3.11/Lib/csv.py

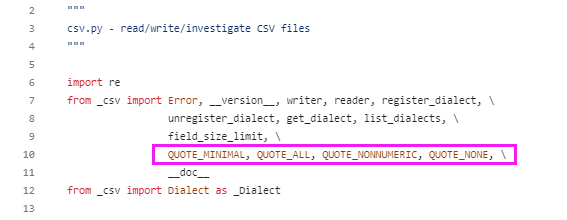

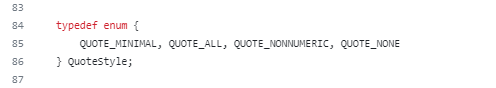

csv 模块的常量是从 _csv 模型引入,_csv 是用 c 语言编写

csv模块定义的常量说明

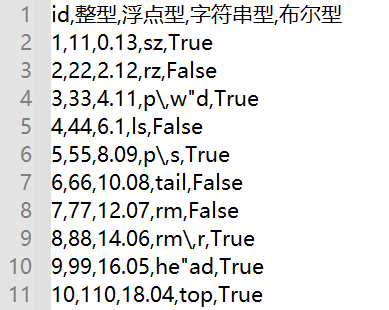

- csv.QUOTE_ALL,等于0

指示writer对象给所有字段加上引号 - csv.QUOTE_MINIMAL,等于1

指示writer对象仅为包含特殊字符(例如 定界符(delimiter)、引号字符(quotechar) 或 行结束符(lineterminator) 中的任何字符)的字段加上引号 - csv.QUOTE_NONNUMERIC,等于2

指示writer对象为所有非数字字段加上引号 指示reader将所有未用引号引出的字段转换为 float 类型 - csv.QUOTE_NONE,等于3

指示writer对象不使用引号括住字段。当 定界符(delimiter) 出现在输出数据中时,其前面应该有 转义符(escapechar)。如果未设置 转义符(escapechar),则遇到任何需要转义的字符时,writer都会抛出 Error 异常 指示reader不对引号字符进行特殊处理

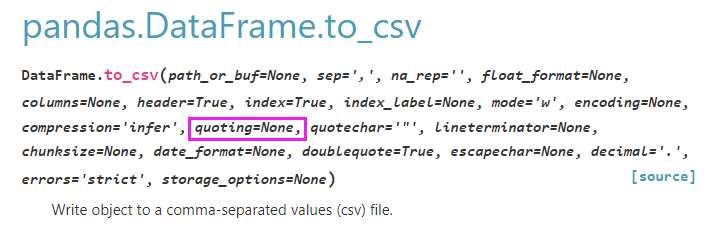

在 pandas 中的案例演示

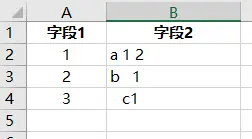

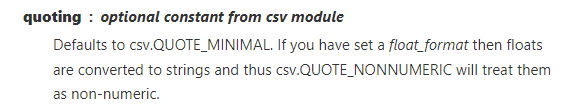

模拟数据

pandas to_csv

默认使用的是 csv.QUOTE_MINIMAL

文档:https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.DataFrame.to_csv.html

csv.QUOTE_ALL 生成csv文件

csv.QUOTE_MINIMAL 生成csv文件

csv.QUOTE_NONNUMERIC 生成csv文件

csv.QUOTE_NONE 生成csv文件

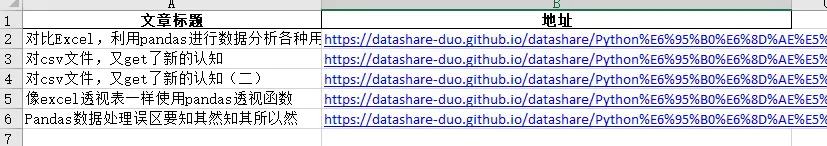

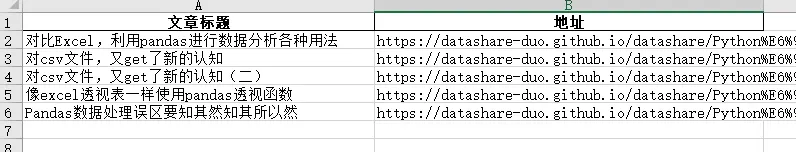

jupyter-notebook 完整代码

历史相关文章

- 对csv文件,又get了新的认知

- Python pandas在读取csv文件时(linux与windows之间传输),数据行数不一致的问题

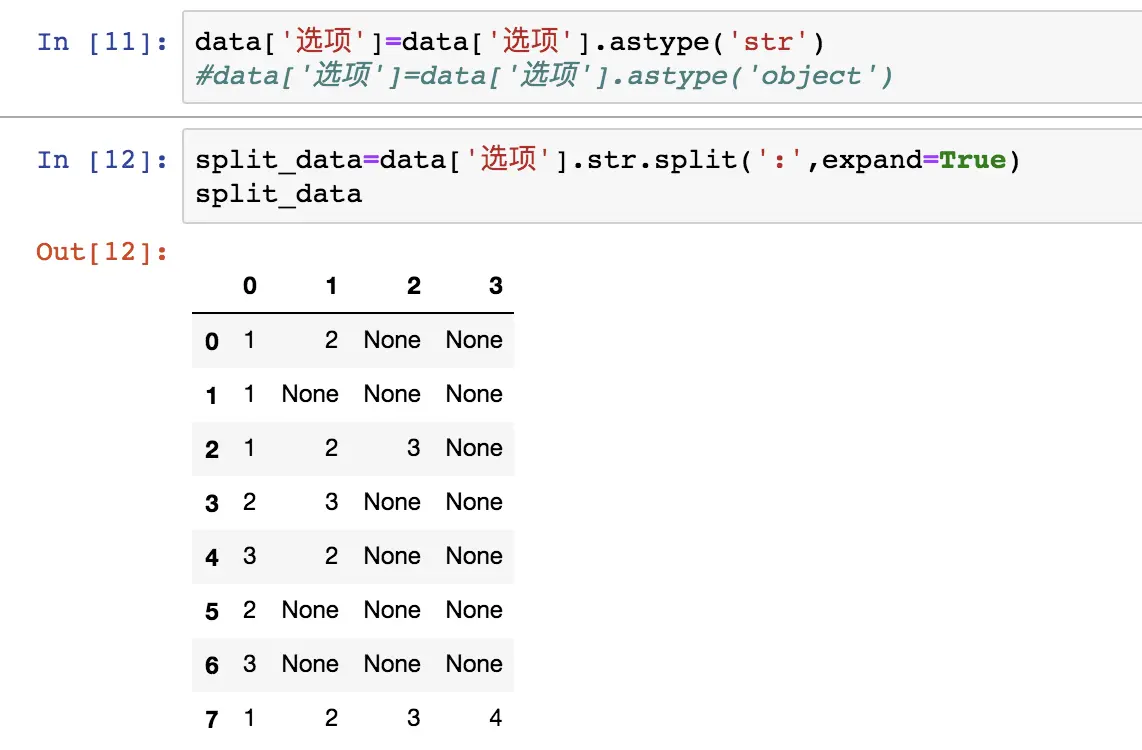

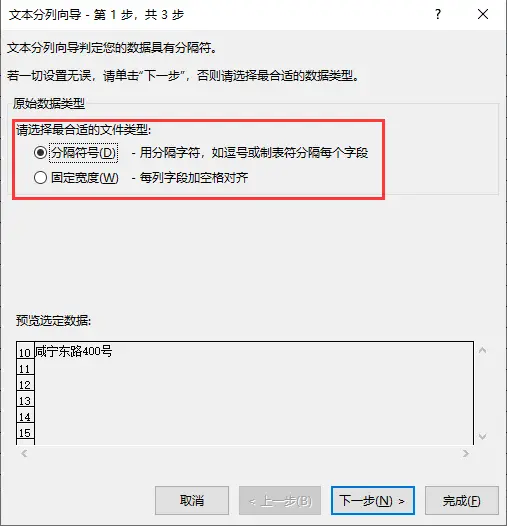

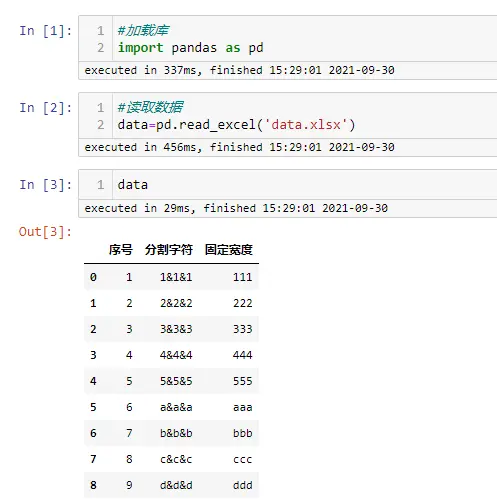

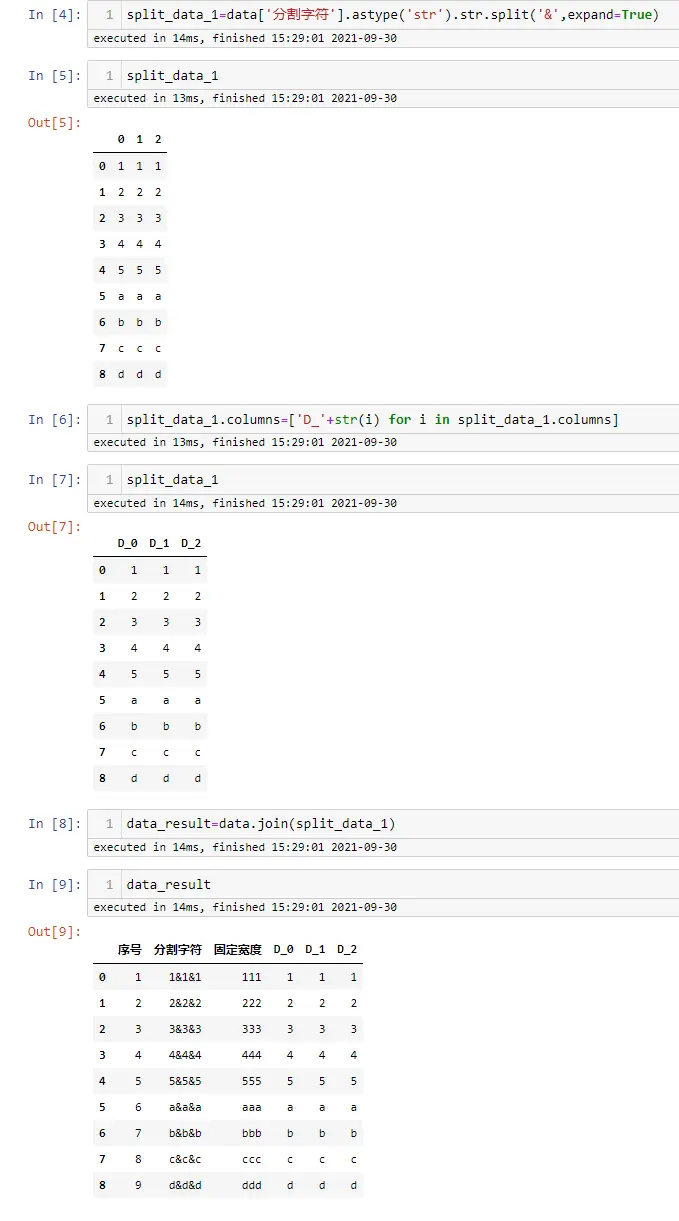

- Python pandas数据分列,分割符号&固定宽度

- Python 字符串格式化方法总结

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

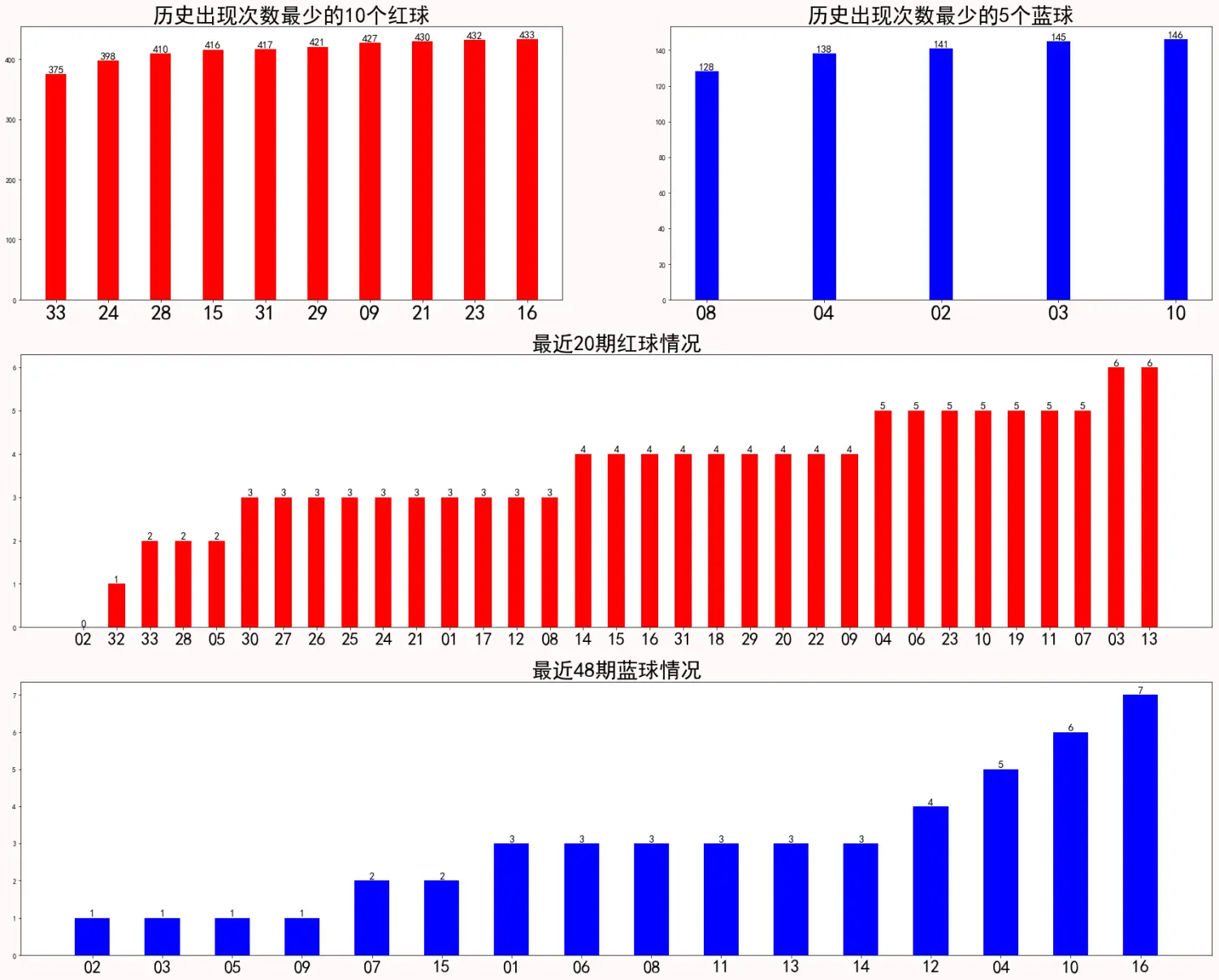

由于身边同事经常买双色球,时间长了也就慢慢关注这个,我们中午经常也一块去吃饭,然后去彩票站点。之前是在支付宝上面就可以买,那会自己也会偶尔买10元的。这片文章主要是爬取了历史双色球所有数据,并进行简单分析,纯属业余爱好,分析结果仅供参考。

1.数据爬取网页

历史双色球数据:https://datachart.500.com/ssq/

#分析网页后可以得知get历史所有数据的参数

url='https://datachart.500.com/ssq/history/newinc/history.php?start=03001'

#加载相关的库

import requests

import numpy as np

import pandas as pd

#获取历史所有双色球数据

response = requests.get(url)

response.encoding = 'utf-8'

re_text = response.text

#网页数据解析

re=re_text.split('<tbody id="tdata">')[1].split('</tbody>')[0]

result=re.split('<tr class="t_tr1">')[1:]

all_numbers=[]

for i in result:

each_numbers=[]

i=i.replace('<!--<td>2</td>-->','')

each=i.split('</td>')[:-1]

for j in each:

each_numbers.append(j.split('>')[1].replace(' ',''))

all_numbers.append(each_numbers)

#定义列名称

col=['期号','红球1','红球2','红球3','红球4','红球5','红球6','蓝球','快乐星期天','奖池奖金(元)',

'一等奖注数','一等奖奖金(元)','二等奖注数','二等奖奖金(元)','总投注额(元)','开奖日期']

#解析完网页数据,生成双色球数据框

df_all=pd.DataFrame(all_numbers,columns=col)

df_all.head()

2.数据转换

#日期转换

df_all['开奖日期_dt']=pd.to_datetime(df_all['开奖日期'])

df_all['year']=df_all['开奖日期_dt'].dt.year

df_all['month']=df_all['开奖日期_dt'].dt.month

df_all['day']=df_all['开奖日期_dt'].dt.day

df_all['weekday']=df_all['开奖日期_dt'].dt.weekday_name

df_all.head()

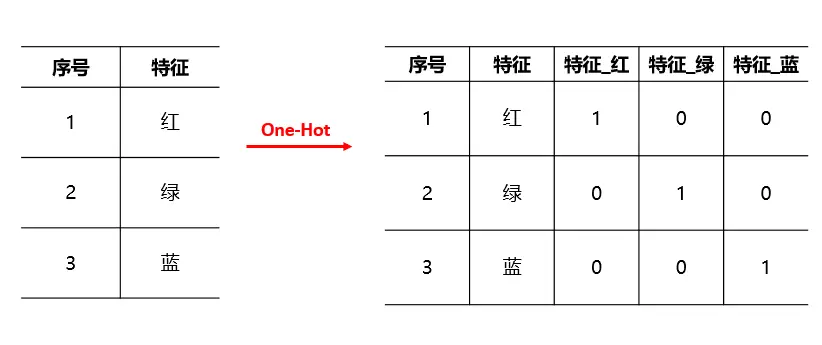

#one-hot 编码转换自定义函数

def lotterydata(df):

modeldata=df.copy()

redball=[]

for i in range(1,34):

redball.append('红球'+'%02d'%i)

for i in redball:

modeldata[i]=0

blueball=[]

for i in range(1,17):

blueball.append('蓝球'+'%02d'%i)

for i in blueball:

modeldata[i]=0

for row in range(modeldata.shape[0]):

#print(row)

#print(modeldata.iloc[row,:])

for i in redball:

#print(i)

#modeldata[i]=0

if (modeldata.iloc[row,:]['红球1']==i[-2:] or modeldata.iloc[row,:]['红球2']==i[-2:]

or modeldata.iloc[row,:]['红球3']==i[-2:] or modeldata.iloc[row,:]['红球4']==i[-2:]

or modeldata.iloc[row,:]['红球5']==i[-2:] or modeldata.iloc[row,:]['红球6']==i[-2:]):

modeldata.loc[row,i]=1

for j in blueball:

#modeldata[j]=0

if modeldata.iloc[row,:]['蓝球']==j[-2:]:

modeldata.loc[row,j]=1

return modeldata

#生成各颜色球的0-1编码

modeldata=lotterydata(df_all)

modeldata.head()

3.数据分析与展示

allhistorydata=modeldata.iloc[:,-49:].copy()

#历史所有红球和蓝球数据

allhistorydata_red=allhistorydata.iloc[:,:33]

allhistorydata_blue=allhistorydata.iloc[:,-16:]

#最近20期红球和最近48期蓝球

#(33*3)/6 每个红球有3次出现机会,看一共需要多少期,这里取整数20期

#(16*3)/1 每个蓝球有3次出现机会,看一共需要多少期

recently20_red=allhistorydata.iloc[:20,:33]

recently48_blue=allhistorydata.iloc[:48,-16:]

#求和

historyred_sum=allhistorydata_red.sum()

historyblue_sum=allhistorydata_blue.sum()

recently20red_sum=recently20_red.sum()

recently48blue_sum=recently48_blue.sum()

#排序

historyred_sum=historyred_sum.sort_values(ascending=True)

historyblue_sum=historyblue_sum.sort_values(ascending=True)

recently20red_sum=recently20red_sum.sort_values(ascending=True)

recently48blue_sum=recently48blue_sum.sort_values(ascending=True)

#数据展示

import matplotlib.pyplot as plt

%matplotlib inline

plt.rcParams['font.sans-serif'] = ['SimHei'] #显示中文

plt.figure(figsize=(30,24),facecolor='snow')

#历史出现次数最少的10个红球

x_red=historyred_sum.index.map(lambda x:x[-2:])[:10]

y_red=historyred_sum.values[:10]

#历史出现次数最少的5个蓝球

x_blue=historyblue_sum.index.map(lambda x:x[-2:])[:5]

y_blue=historyblue_sum.values[:5]

plt.subplot(3,2,1)

plt.bar(x_red,y_red,width=0.4,align='center',color='r')

for a,b in zip(x_red,y_red):

plt.text(a,b,b,ha='center',va='bottom',fontsize=15)

plt.tick_params(axis='x',labelsize=30)

plt.title("历史出现次数最少的10个红球",fontsize=30)

plt.subplot(3,2,2)

plt.bar(x_blue,y_blue,width=0.2,align='center',color='b')

for a,b in zip(x_blue,y_blue):

plt.text(a,b,b,ha='center',va='bottom',fontsize=15)

plt.tick_params(axis='x',labelsize=30)

plt.title("历史出现次数最少的5个蓝球",fontsize=30)

#最近20期红球

x20_red=recently20red_sum.index.map(lambda x:x[-2:])

y20_red=recently20red_sum.values

#最近48期蓝球

x48_blue=recently48blue_sum.index.map(lambda x:x[-2:])

y48_blue=recently48blue_sum.values

plt.subplot(3,1,2)

plt.bar(x20_red,y20_red,width=0.5,align='center',color='r')

for a,b in zip(x20_red,y20_red):

plt.text(a,b,b,ha='center',va='bottom',fontsize=15)

plt.tick_params(axis='x',labelsize=25)

plt.title("最近20期红球情况",fontsize=30)

plt.subplot(3,1,3)

plt.bar(x48_blue,y48_blue,width=0.5,align='center',color='b')

for a,b in zip(x20_blue,y20_blue):

plt.text(a,b,b,ha='center',va='bottom',fontsize=15)

plt.tick_params(axis='x',labelsize=25)

plt.title("最近48期蓝球情况",fontsize=30)

plt.show()

最终的数据展示结果,仅供参考!!!

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

介绍

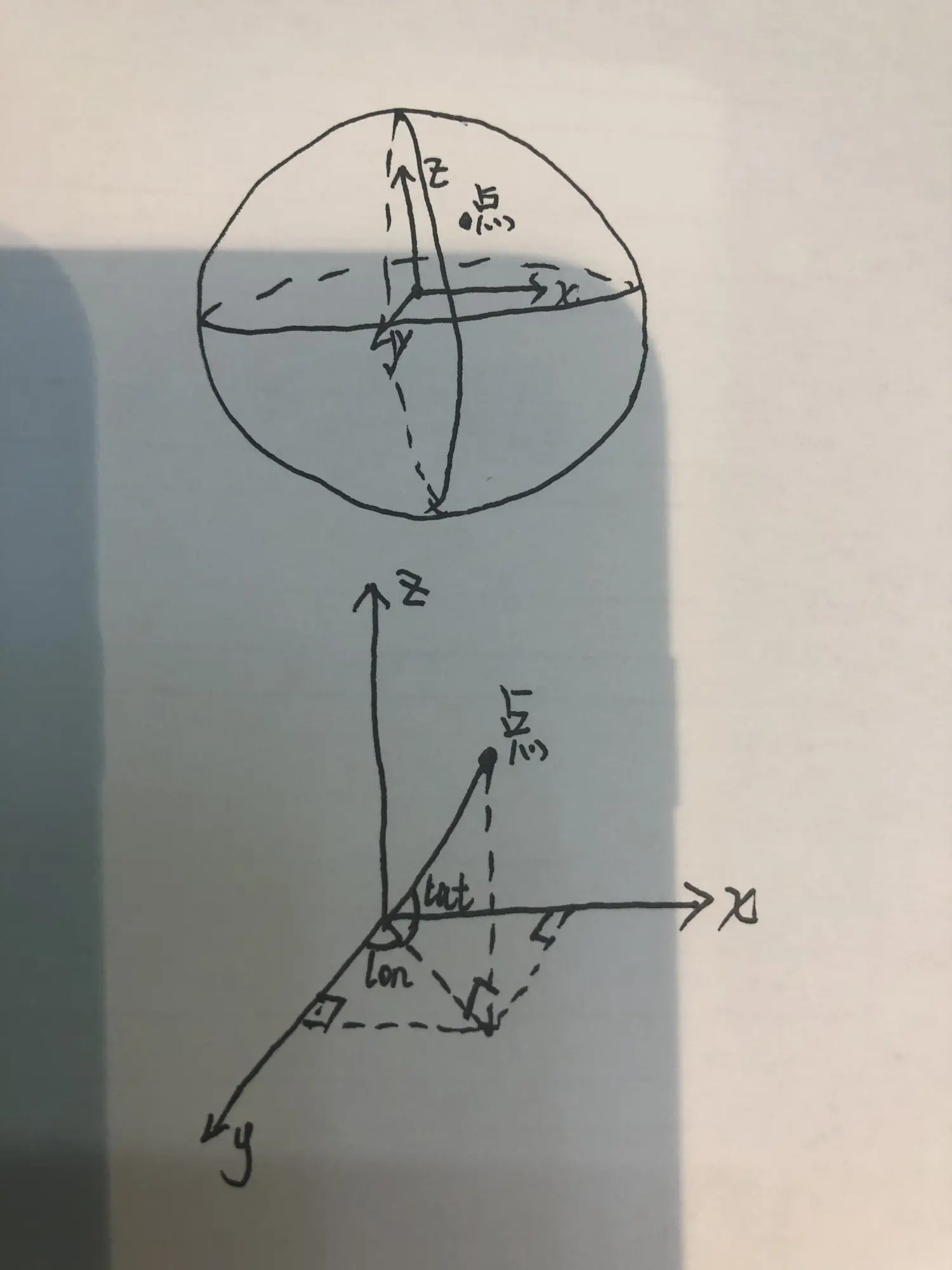

众所周知地球是一个球体,地平面是一个弧形,那么两个地理位置之间的中点该如何确定,比如北京与上海两个城市之间的中点在哪里?

可以直接对经纬度进行平均,求中点吗?

答案:当然不可以

我们都知道一个地理位置是由经度、维度来确定,平时在计算地理信息时基本都是两列数据,一列是经度,一列是维度,比如:

北京:"lon":116.512885,"lat":39.847469,

上海:"lon":116.332334,"lat":39.882806

- lon:longitude 经度

经度是指通过某地的经线面与本初子午面所成的二面角。

在本初子午线以东的经度叫东经,在本初子午线以西的叫西经。

东经用“E”表示,西经用“W”表示。

- lat:latitude 维度

赤道的纬度为0°,将行星平分为南半球和北半球。

纬度是指某点与地球球心的连线和地球赤道面所成的线面角,其数值在0至90度之间。

位于赤道以北的点的纬度叫北纬,记为N,位于赤道以南的点的纬度称南纬,记为S。

概念-----计算原理

那么应该怎么计算呢?

我们可以把地球看做是一个立体坐标系,有x轴,y轴,z轴三个方向,对于球面上的一个点,可以分别计算出在x轴,y轴,z轴的投影,那么在三个轴上面的分量是可以直接求均值,最后再进行反向合成,这样即可求出球面上对应的中点。

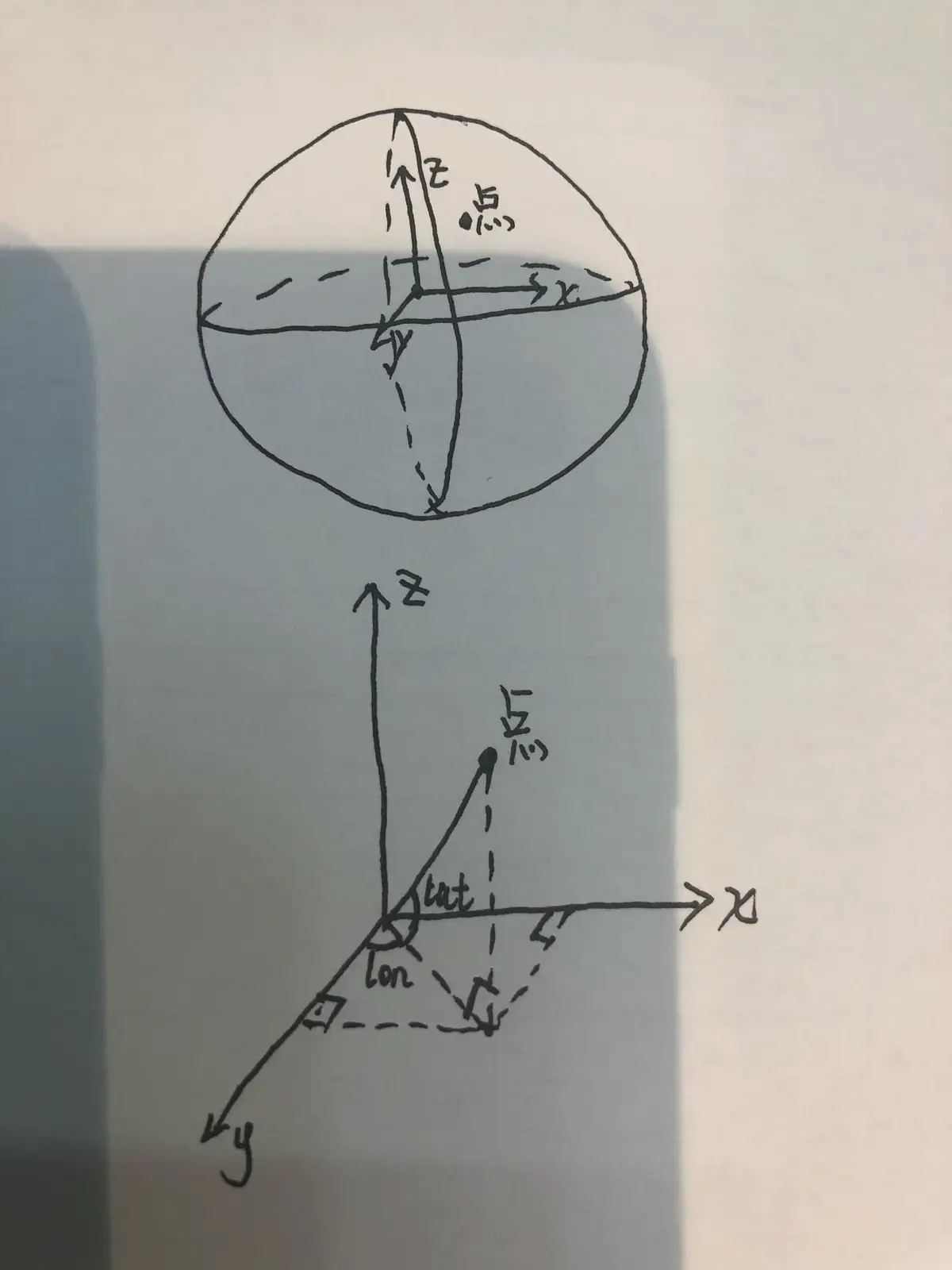

下图手工画出了,在x轴,y轴,z轴如何进行投影(可进行参考):

根据手绘图可以计算出,各个分量:

根据手绘图可以计算出,各个分量:

x = cos(lat) * sin(lon)

y = cos(lat) * cos(lon)

z = sin(lat)

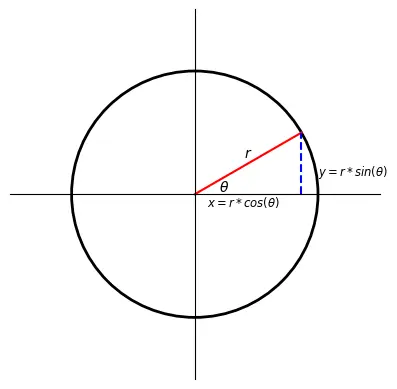

角度和弧度相互转换

由于我们实际数据中的经纬度是角度,而我们在计算分量时需要用弧度,比如 cos(π/2) ,这里就先需要转换,那么怎么进行转换:

python的math模块里面有相应转换函数

radians()-----将角度转换为弧度

degrees()-----将弧度转换为角度

脑补一下角度与弧度:

度和弧度都是衡量角的大小的单位,就像米(m)和英寸(in)都是用来衡量长度的单位。度用°来表示,弧度用rad表示。

1rad = (180/π)° ≈ 57.3°

1° = (π/180)rad ≈ 0.01745rad

弧度的定义

在一个圆中,弧长等于半径的弧,其所对的圆心角就是 1rad。也就是说,两条射线从圆心向圆周射出,形成一个夹角和夹角正对的一段弧。当这段弧的长度正好等于圆的半径时,两条射线的夹角的弧度为 1。根据定义,圆一周的弧度数为 2πr/r = 2π,360° = 2πrad,平角(即 180° 角)为 πrad,直角为 π/2rad

在具体计算中,角度以弧度给出时,通常不写弧度单位,直接写值。最典型的例子是三角函数,例如:sin(8π)、tan(3π/2)

自定义函数

import pandas as pd

import numpy as np

from math import cos, sin, atan2, sqrt, radians, degrees

data=pd.read_excel('./data.xlsx')

def center_geolocation(df):

"""

输入多个经纬度坐标,找出中心点 [lon,lat]->[经度,维度]

:param geolocations: 列表

:return 中心经纬度

"""

x = 0

y = 0

z = 0

lenth = len(df)

for lon, lat in zip(df['lon'].to_list(),df['lat'].to_list()):

lon = radians(float(lon)) #radians将角度转换为弧度

lat = radians(float(lat))

x += cos(lat) * sin(lon)

y += cos(lat) * cos(lon)

z += sin(lat)

x = float(x / lenth)

y = float(y / lenth)

z = float(z / lenth)

#degrees将弧度转换为角度

lon=degrees(atan2(x, y))

lat=degrees(atan2(z, sqrt(x * x + y * y)))

return pd.DataFrame({'lon':[lon],'lat':[lat]})

#使用

result_data=data.groupby('ID').apply(center_geolocation)

result_data.index=result_data.index.droplevel(level=1)

result_data.to_excel('./result_data.xlsx')

以上是自己实践中遇到的一些问题,分享出来供大家参考学习,欢迎关注微信公众号:DataShare ,不定期分享干货

作者:数据人阿多

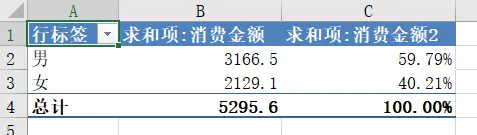

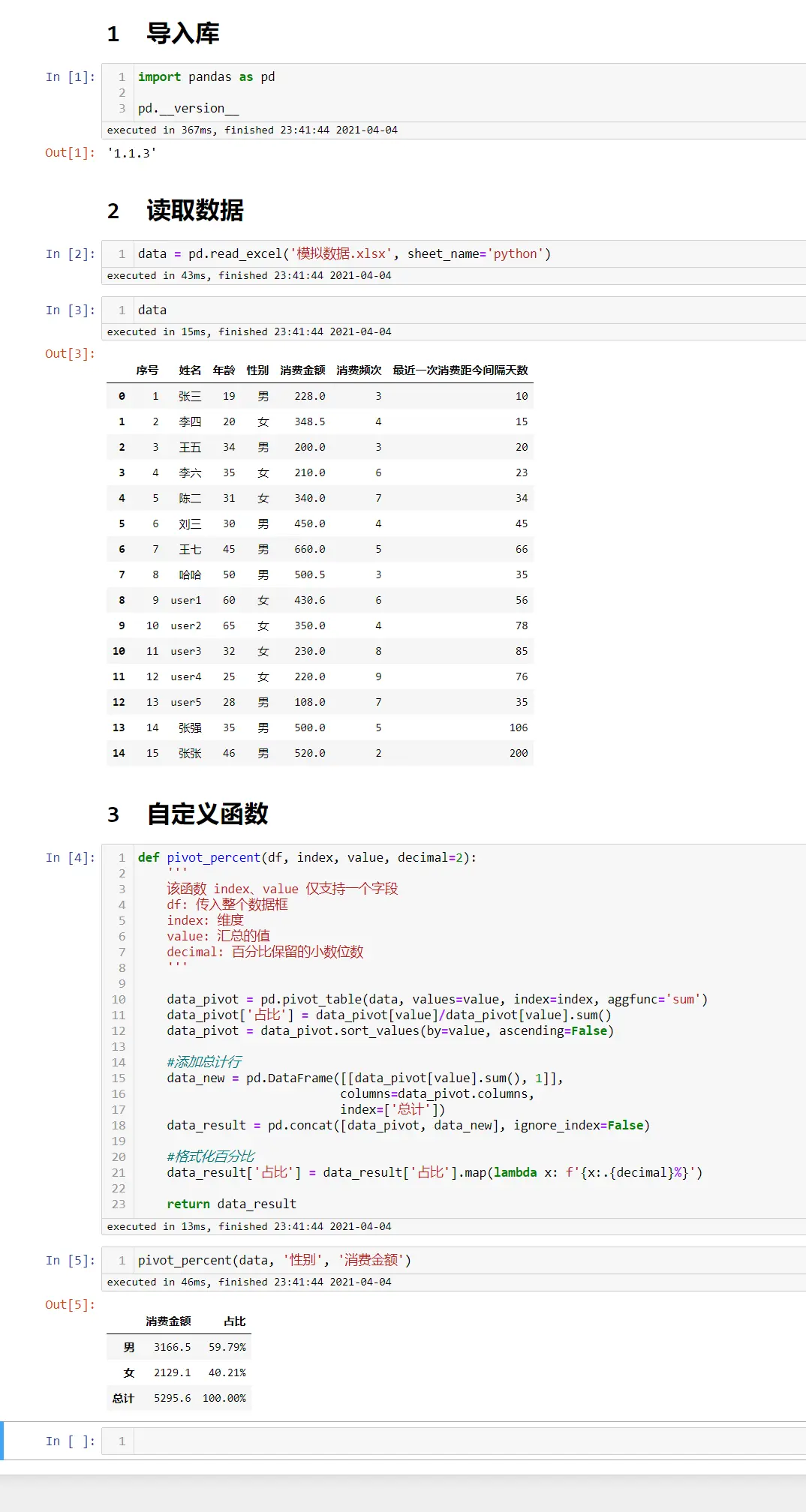

背景

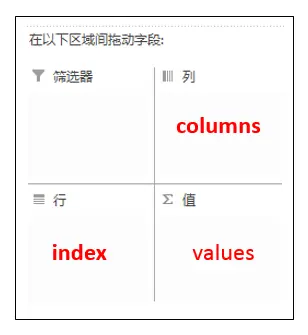

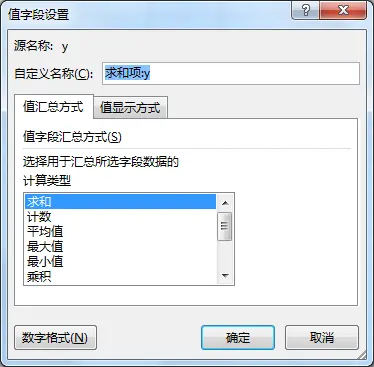

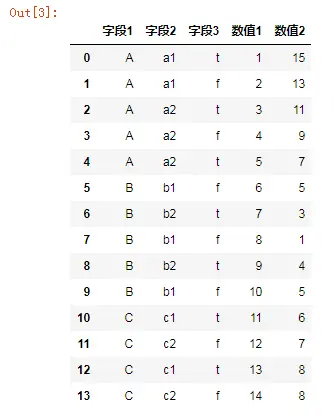

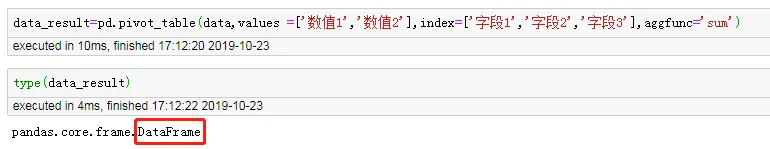

Excel里面数据透视表可谓是功能强大,可以对数据进行去重,可以方便的对数据进行汇总,可以对数据从不同维度进行交叉分析等,而且速度还非常快,即使有几万行数据。